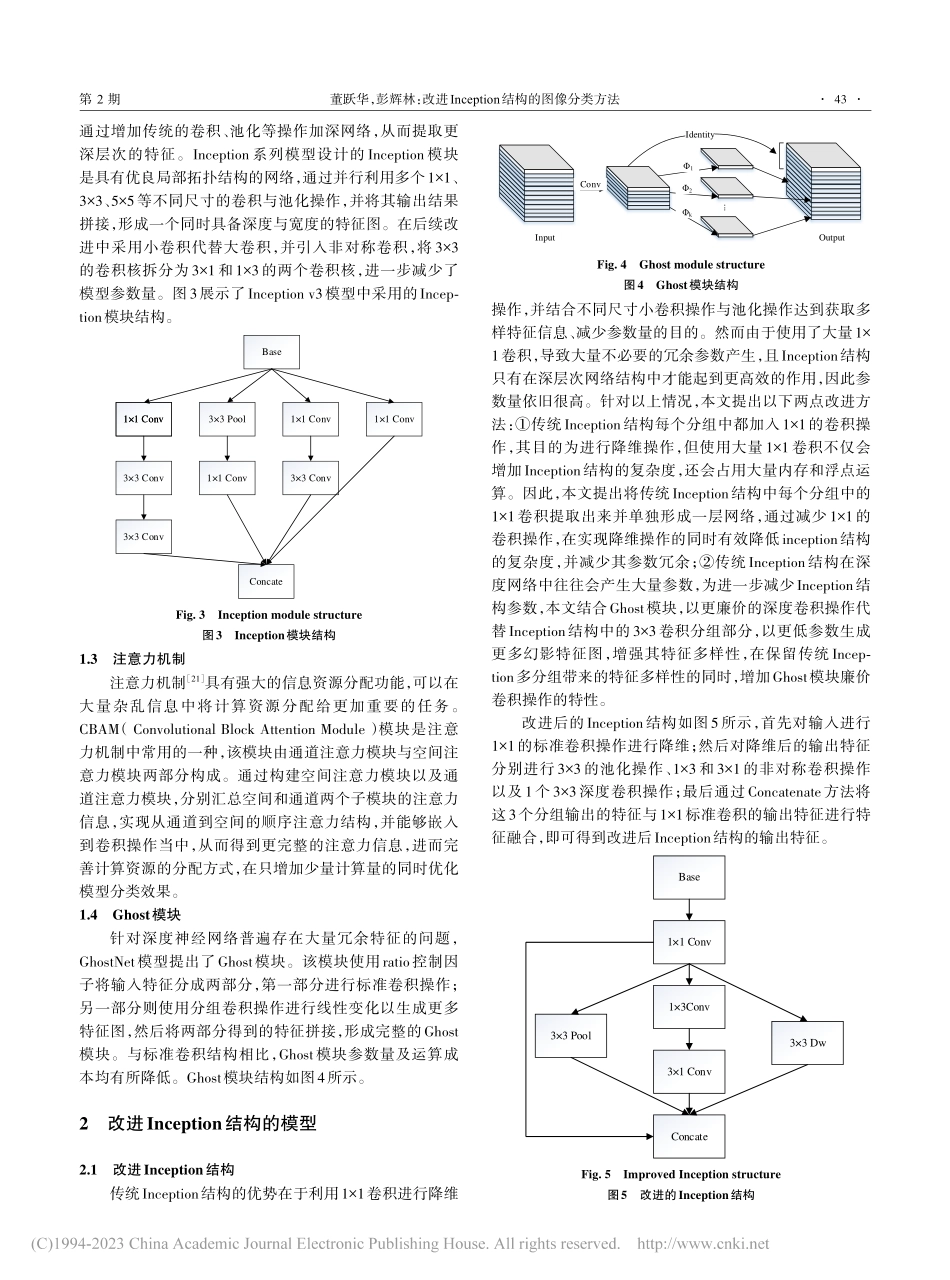

第22卷第2期2023年2月Vol.22No.2Feb.2023软件导刊SoftwareGuide改进Inception结构的图像分类方法董跃华,彭辉林(江西理工大学信息工程学院,江西赣州341000)摘要:为解决图像分类中Inception结构复杂且在深度网络中存在参数冗余的问题,提出一种改进的Inception结构。该结构整合了传统Inception结构中繁杂的1×1卷积操作,通过引入深度卷积增加Inception结构的特征多样性,降低模型参数量,并结合残差结构防止梯度爆炸及梯度消失。同时引入注意力机制,获取关键特征权重信息,优化资源分配方式,并在此基础上设计了一个基于标准卷积与非对称卷积的轻量化网络模型。实验对象选择苹果叶病害数据集与CIFAR-10数据集,通过与经典卷积神经网络VGG16、Inception-V3与MobileNet进行比较后发现,改进Inception结构的轻量化模型具有参数量少、训练时间短、分类效果好的优势。同时,通过比较改进前后Inception结构在所提网络模型中的训练结果,证明了改进Inception结构较传统Inception结构分类性能更好。关键词:图像分类;Inception;深度卷积;苹果叶病害;卷积神经网络DOI:10.11907/rjdk.221304开放科学(资源服务)标识码(OSID):中图分类号:TP391.4文献标识码:A文章编号:1672-7800(2023)002-0041-06ImageClassificationMethodBasedonImprovedInceptionStructureDONGYue-hua,PENGHui-lin(SchoolofInformationEngineering,JiangxiUniversityofScienceandTechnology,Ganzhou341000,China)Abstract:InordertosolvetheproblemofcomplexInceptionstructureandredundantparametersindeepnetworkinimageclassification,animprovedInceptionstructureisproposed,whichintegratesthecomplicated1×1convolutionoperationinthetraditionalInceptionstructure,andintroducesdepthwiseconvolution.IncreasethefeaturediversityoftheInceptionstructure,reducetheamountofparameters,andcombinetheresidualstructuretopreventgradientexplosionandgradientdisappearance.Atthesametime,anattentionmechanismisintroducedtoob⁃tainkeyfeatureweightinformationandoptimizeresourceallocation.Onthisbasis,alightweightnetworkmodelbasedonstandardconvolutionandasymmetricconvolutionisdesigned.Intheexperiment,theappleleafdiseasedatasetandtheCIFAR-10datasetwereselectedastheex⁃perimentalobjects.Theresultsaftercomparingwiththecl...