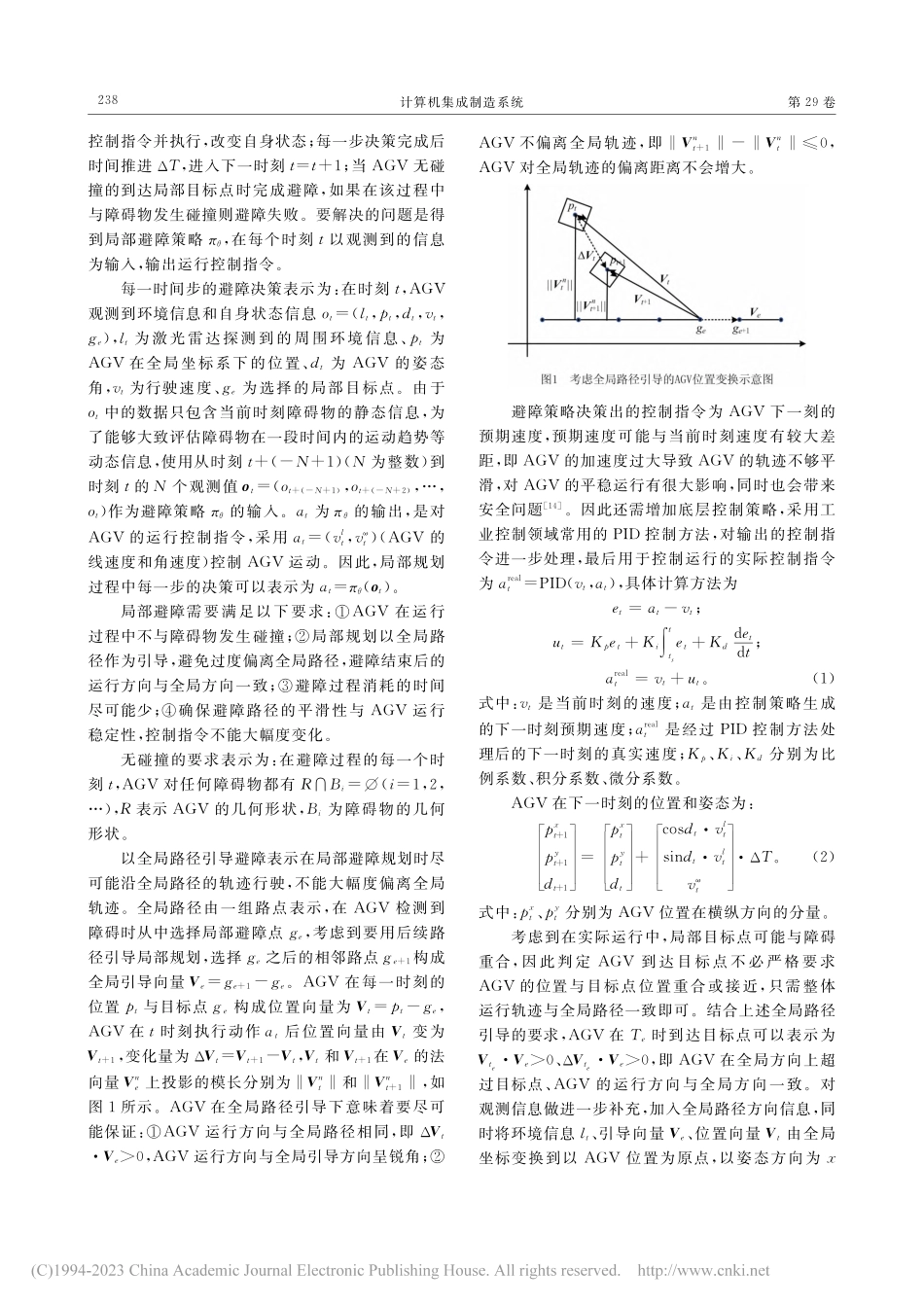

第29卷第1期计算机集成制造系统Vol.29No.12023年1月ComputerIntegratedManufacturingSystemsJan.2023DOI:10.13196/j.cims.2023.01.020收稿日期:2021-10-09;修订日期:2022-02-29。Received09Oct.2021;accepted29Feb.2022.基金项目:国家重点研发计划资助项目(2021YFB1715700);国家自然科学基金资助项目(52175451)。Foundationitems:ProjectsupportedbytheNationalKeyResearchandDevelopmentProgram,China(No.2021YFB1715700),andtheNationalNaturalScienceFoundation,China(No.52175451).复杂动态环境下基于深度强化学习的AGV避障方法蔡泽,胡耀光+,闻敬谦,张立祥(北京理工大学工业与智能系统工程研究所,北京100081)摘要:为提升自动导引车(AGV)在智能工厂复杂动态环境下的避障能力,使其能在全局路径引导下安全、高效地完成避障任务,提出一种基于深度强化学习的局部避障方法。首先,将避障问题表示为部分观测马尔可夫决策过程,详细描述了观测空间、动作空间、奖励函数和最优避障策略,通过设置不同的奖励实现以全局路径引导局部避障规划;然后,在此基础上,采用深度确定性策略梯度算法训练避障策略;最后,建立了仿真实验环境,并设计多种实验场景来验证所提方法的有效性。实验结果表明,所提方法可以应对复杂动态环境,减小避障时间与距离,提高运行效率。关键词:动态避障;深度强化学习;全局路径引导;智能工厂中图分类号:TH166文献标识码:ACollisionavoidanceforAGVbasedondeepreinforcementlearningincomplexdynamicenvironmentCAIZe,HUYaoguang+,WENJingqian,ZHANGLixiang(LaboratoryofIndustrialandIntelligentSystemEngineering,BeijingInstituteofTechnology,Beijing100081,China)Abs...