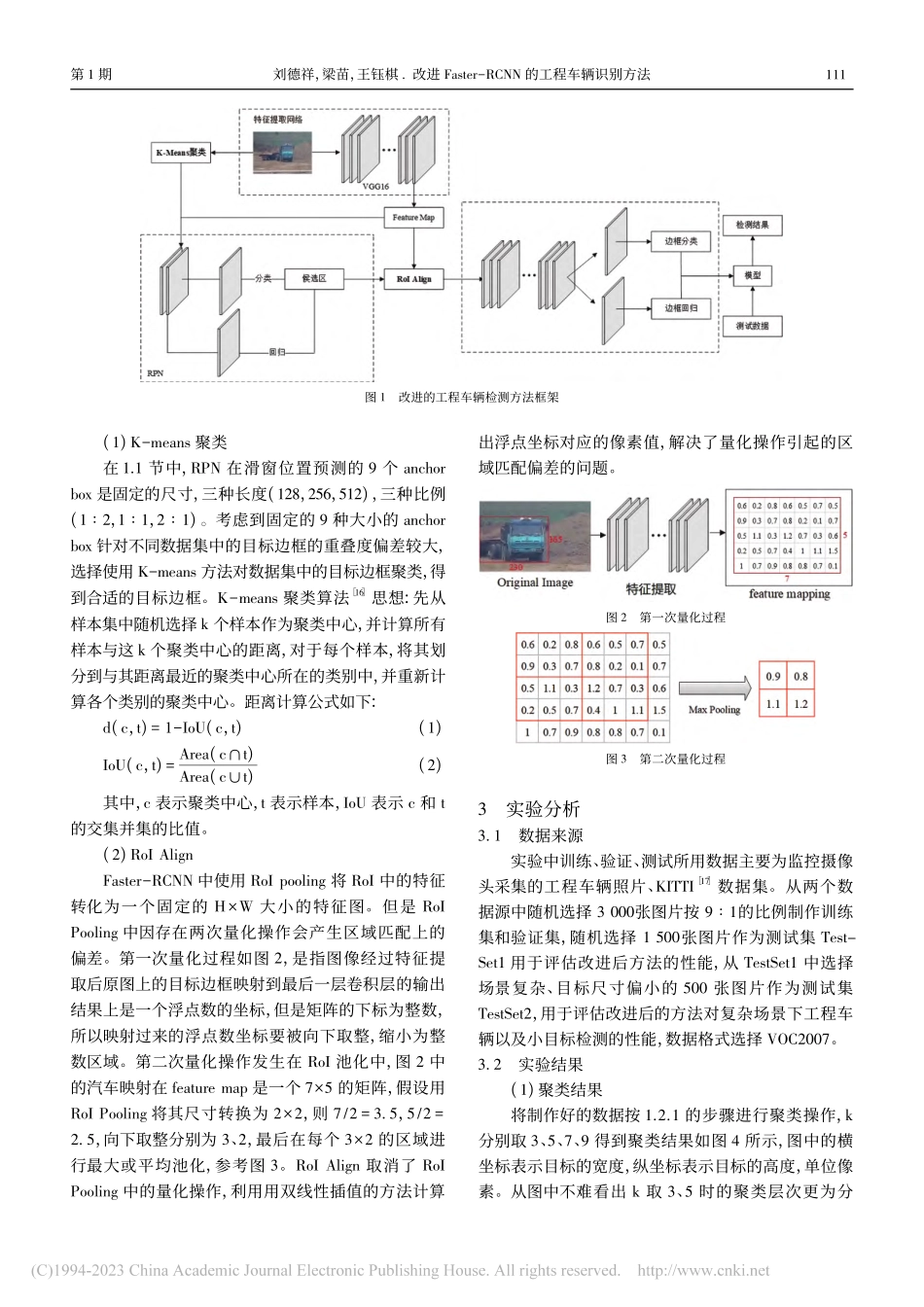

2023年2月第1期城市勘测UrbanGeotechnicalInvestigation&SurveyingFeb.2023No.1引文格式:刘德祥,梁苗,王钰棋.改进Faster-RCNN的工程车辆识别方法[J].城市勘测,2023(1):110-113.文章编号:1672-8262(2023)01-110-04中图分类号:TP391.41文献标识码:A改进Faster-RCNN的工程车辆识别方法刘德祥*,梁苗,王钰棋*收稿日期:2022—05—16作者简介:刘德祥(1996—),男,硕士,主要从事目标检测、语义分割工作。E-mail:763950828@qq.com(徐州市勘察测绘研究院有限公司,江苏徐州221000)摘要:针对Faster-RCNN中预设锚点框尺寸与数据集不匹配、RoIPooling中量化操作带来的区域不匹配问题,研究了一种改进Faster-RCNN的方法,实现城镇视频监控场景下工程车辆(铲车、挖掘机及大货车等)的快速、准确识别。首先,使用K-means算法对训练数据中的目标边框聚类分析,通过聚类分析得到7种较优的锚点框,将聚类结果用于区域建议网络;其次,以区域特征聚集方法RoIAlign替换ROIPooling,解决因量化操作带来的区域不匹配问题;实验结果表明改进FasterRCNN方法的精度更高,mAP达到87.73%,提高14.06%。关键词:工程车辆识别;Faster-RCNN;RoIAlign;聚类;区域建议网络1引言随着我国社会经济的发展,土地的需求量也日益增大,使得各地区非法取土的违法行为频发。非法取土会破坏土地生态系统的平衡,削弱土地的生产力,进而导致土壤侵蚀、水土流失等问题[1,2]。工程车辆(如铲车、挖掘机及大货车等)作为非法取土的重要工具,对其准确识别可以有效地监察非法取土的行为。传统的国土监测手段以人工巡查为主,工作效率低,且受人为因素影响较大。近年来,国土资源管理部门在重点地区设置监控系统,通过摄像头监控的方式替代人工巡查,虽取得了一定的成效。但是,通过摄像头监控仍需人工辨别,难以直接识别工程车辆,无法实现全天24小时的自动化监控。因此,如何从摄像头监控数据中自动、高效地识别工程车辆,对非法取土的监测具有重要的意义。从图像中识别工程车辆是一种典型的目标检测任务。随着计算机科学的快速发展,基于深度学习的目标检测算法的精度和速度远高于使用滑动窗口、人工设计的特征提取算子(Harr,HOG,SIFT等)[3~5]、分类器(SVM、Adaboost等)[6,7]结合的传统目标检测算法,已经成为图像目标检测方法的主流。当前,基于深度学习的目标检测算法主要分为基于候选区域检测与基于回归检测两大类。基于候选区域的目标检测算法是一...