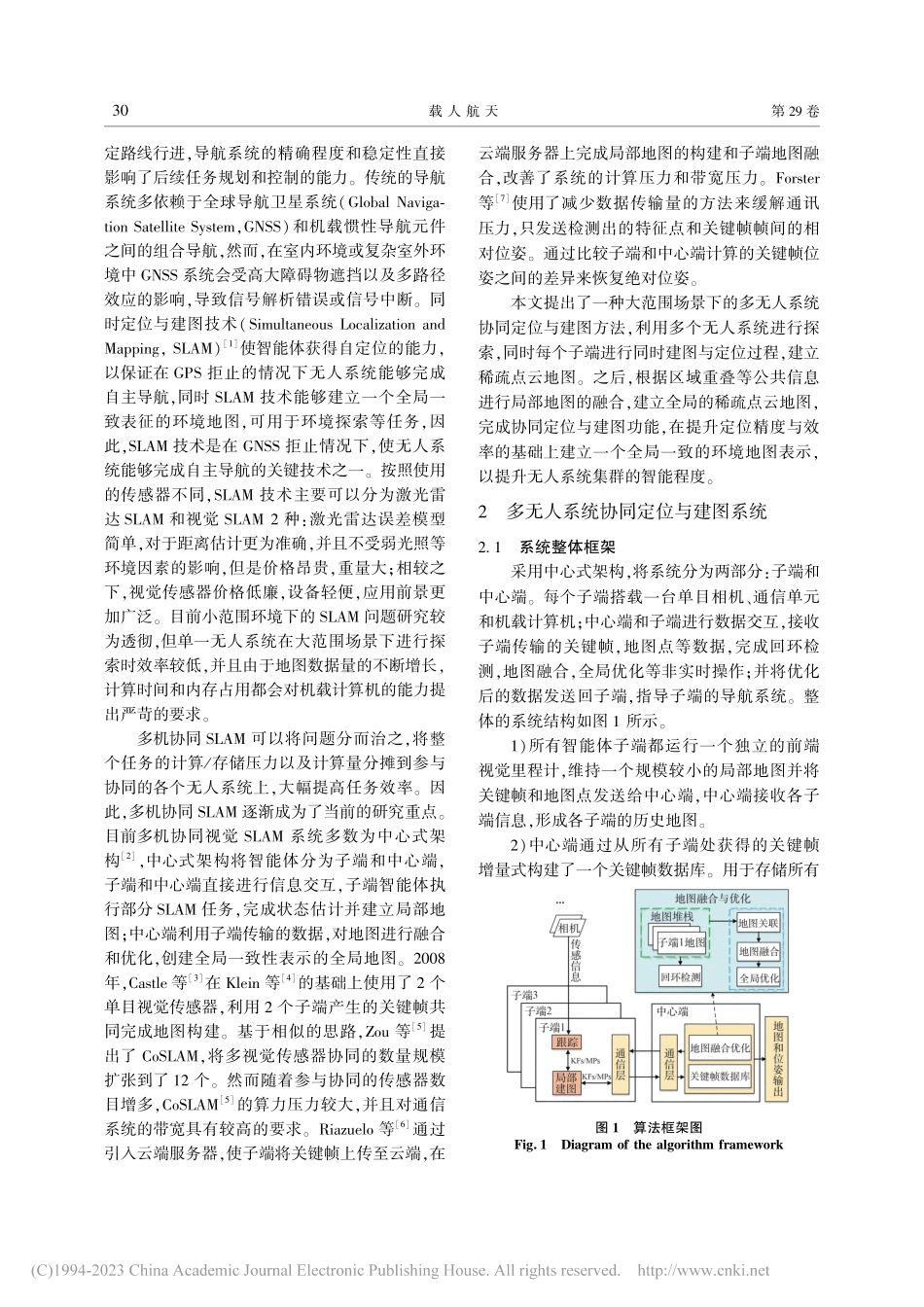

多无人系统协同视觉SLAM算法魏强1,张冬梅2,范勇生3(1.中国空间技术研究院,北京100098;2.中国东方红卫星股份有限公司,北京100081;3.上海宇航系统工程研究所,上海201108)摘要:针对传统同时定位与地图构建(SLAM)方法受计算能力、存储能力的限制无法在大范围场景下作业,无法建立大范围场景的全局一致性地图等问题,基于ORB⁃SLAM2系统框架建立了一种中心式的多无人系统协同视觉SLAM算法。设计了地图大小限制策略,以保证无人系统不受机载设备算力和存储能力的影响,基于字典机制和Sim3转换构建了地图融合优化算法,以完成全局地图构建与优化。最后进行了数据集测试,结果表明:所提出算法能够完成多无人系统协同SLAM,相对传统SLAM算法具有明显优势。关键词:视觉SLAM;无人系统协同;地图融合;状态估计中图分类号:V19文献标识码:A文章编号:1674⁃5825(2023)01⁃0029⁃07收稿日期:2022⁃07⁃20;修回日期:2022⁃11⁃30第一作者:魏强,男,硕士,高级工程师,研究方向为航天管理科学与工程。E⁃mail:13910652379@163.comCollaborativeVisionSLAMAlgorithmforMultipleUnmannedSystemsWeiQiang1,ZhangDongmei2,FanYongsheng3(1.ChinaAcademyofSpaceTechnology,Beijing100098,China;2.ChinaSpacesatCo.,Ltd.Beijing100098,China;3.AerospaceSystemEngineeringShanghai,Shanghai201108,China)Abstract:Traditionalsimultaneouslocalizationandmappingmethodsarelimitedbycomputingpowerandstoragecapacity.Tosolvetheproblemthataglobalconsistencymapoflarge⁃scalescenescouldnotbebuiltbythosetraditionalmethods,acentralcooperativevisionSLAMalgorithmfor...