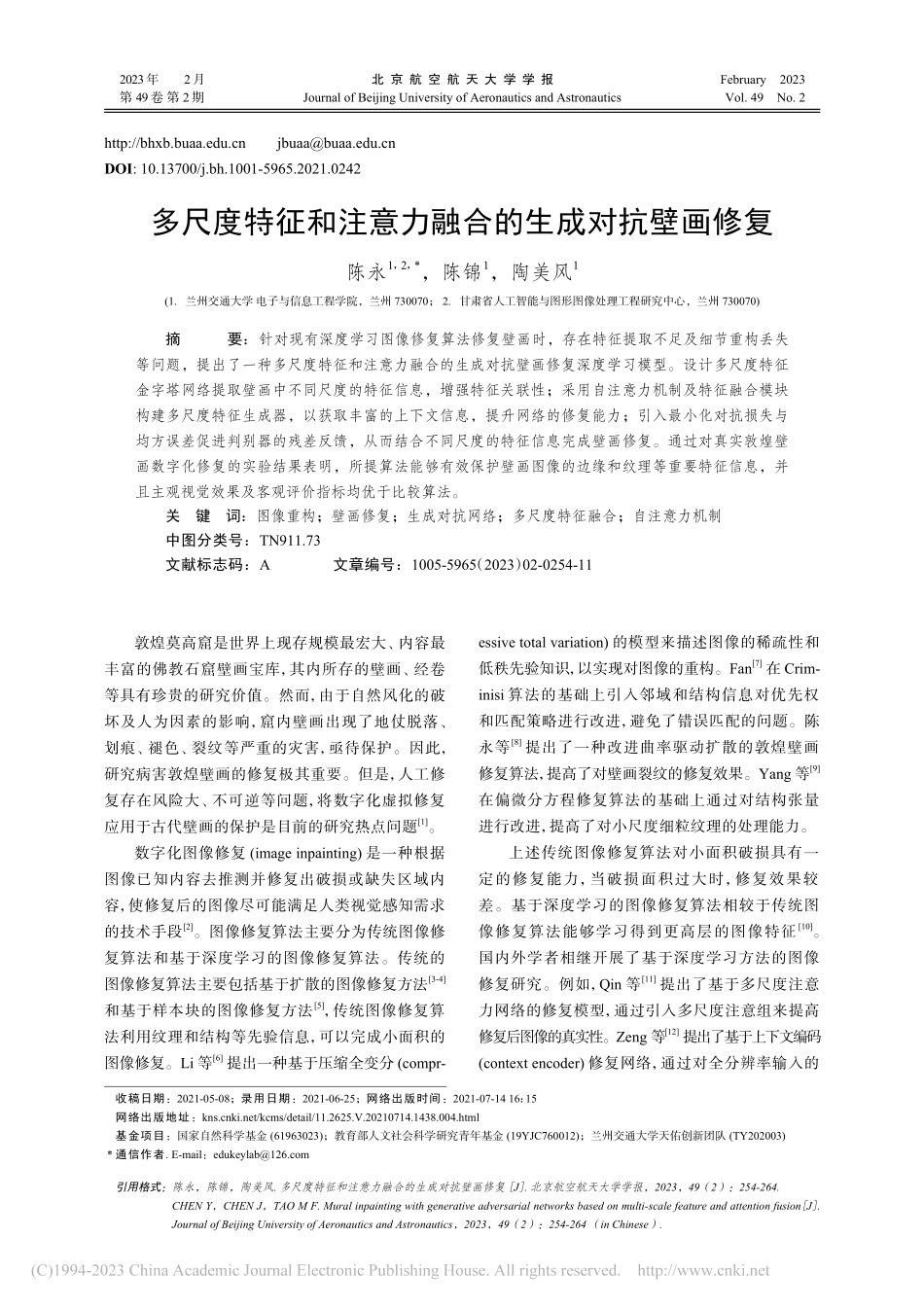

http://bhxb.buaa.edu.cnjbuaa@buaa.edu.cnDOI:10.13700/j.bh.1001-5965.2021.0242多尺度特征和注意力融合的生成对抗壁画修复陈永1,2,*,陈锦1,陶美风1(1.兰州交通大学电子与信息工程学院,兰州730070;2.甘肃省人工智能与图形图像处理工程研究中心,兰州730070)摘要:针对现有深度学习图像修复算法修复壁画时,存在特征提取不足及细节重构丢失等问题,提出了一种多尺度特征和注意力融合的生成对抗壁画修复深度学习模型。设计多尺度特征金字塔网络提取壁画中不同尺度的特征信息,增强特征关联性;采用自注意力机制及特征融合模块构建多尺度特征生成器,以获取丰富的上下文信息,提升网络的修复能力;引入最小化对抗损失与均方误差促进判别器的残差反馈,从而结合不同尺度的特征信息完成壁画修复。通过对真实敦煌壁画数字化修复的实验结果表明,所提算法能够有效保护壁画图像的边缘和纹理等重要特征信息,并且主观视觉效果及客观评价指标均优于比较算法。关键词:图像重构;壁画修复;生成对抗网络;多尺度特征融合;自注意力机制中图分类号:TN911.73文献标志码:A文章编号:1005-5965(2023)02-0254-11敦煌莫高窟是世界上现存规模最宏大、内容最丰富的佛教石窟壁画宝库,其内所存的壁画、经卷等具有珍贵的研究价值。然而,由于自然风化的破坏及人为因素的影响,窟内壁画出现了地仗脱落、划痕、褪色、裂纹等严重的灾害,亟待保护。因此,研究病害敦煌壁画的修复极其重要。但是,人工修复存在风险大、不可逆等问题,将数字化虚拟修复应用于古代壁画的保护是目前的研究热点问题[1]。数字化图像修复(imageinpainting)是一种根据图像已知内容去推测并修复出破损或缺失区域内容,使修复后的图像尽可能满足人类视觉感知需求的技术手段[2]。图像修复算法主要分为传统图像修复算法和基于深度学习的图像修复算法。传统的图像修复算法主要包括基于扩散的图像修复方法[3-4]和基于样本块的图像修复方法[5],传统图像修复算法利用纹理和结构等先验信息,可以完成小面积的图像修复。Li等[6]提出一种基于压缩全变分(compr-essivetotalvariation)的模型来描述图像的稀疏性和低秩先验知识,以实现对图像的重构。Fan[7]在Crim-inisi算法的基础上引入邻域和结构信息对优先权和匹配策略进行改进,避免了错误匹配的问题。陈永等[8]提出了一种改进曲率驱动扩散的敦煌壁画修复算法,提高了对壁画裂纹的修复效果。Yang等[9]在偏微分方程修复算法的基础上通过对结构张量...