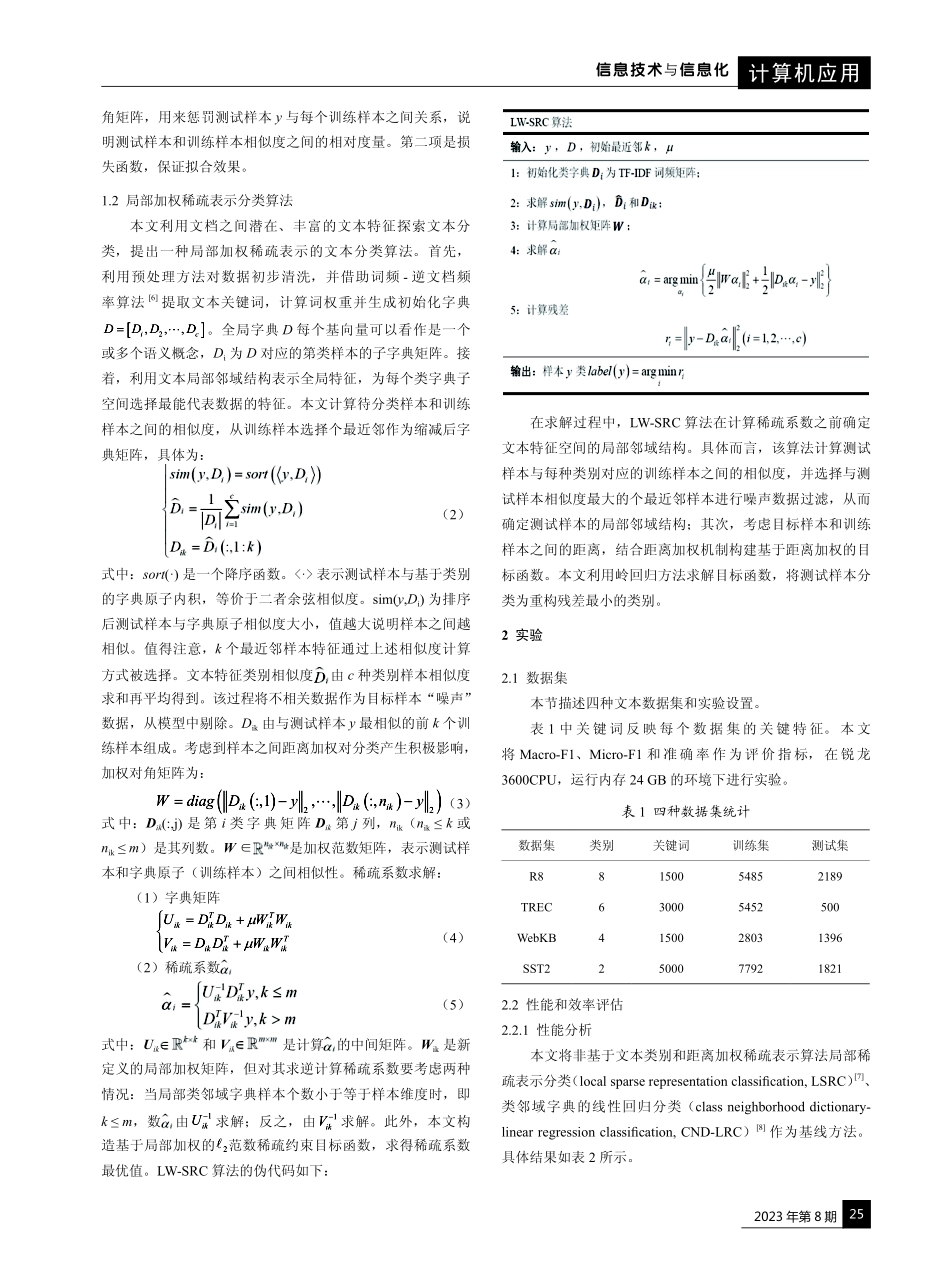

2023年第8期24计算机应用信息技术与信息化局部加权稀疏表示的文本分类算法研究祝利杰1罗迪凡2史彦丽3ZHULijieLUODifanSHIYanli摘要基于稀疏表示方法的文本分类强调使用训练样本特征的全局结构对测试样本进行稀疏表示,而对文本特征的局部邻域结构和文档之间相似性缺乏考虑,导致文本分类准确率低和高耗时。为了解决上述问题,本研究以最近邻和最近特征子空间为基础,并建立局部邻域结构和距离加权机制,提出一种局部加权稀疏表示的文本分类算法,使文本语义信息表达更丰富、稀疏表示更具判别力。实验结果表明本文算法准确率高于基线算法2.4%~5%,运行速度提高1.35~2.8倍。关键词文本分类;稀疏表示;局部邻域结构;距离加权doi:10.3969/j.issn.1672-9528.2023.08.0061.暨南大学信息科学技术/网络空间安全学院广东广州5114362.暨南大学伯明翰大学联合学院广东广州5114363.吉林化工学院理学院吉林吉林1320220引言文本分类(textcategorization,TC)是自然语言处理的重要技术之一,根据主题自动将(非)结构化文档分类为一个或多个预定义类别,对包含大数据信息进行组织和管理,降低搜索信息成本,在情感分析[1]和垃圾邮件过滤[2]等方面具有广泛应用。随着文本数据量迅速增长,文本数据特征维度越来越大,数据结构变得更加复杂。经典分类方法,如决策树、K近邻分类器及其变体,依赖数据统计算法和特征选择算法,使用奇异值分解和词频-逆文本频率方法生成的词向量存在高维度和高稀疏问题,不能很好地表征文本特征信息。与此不同,稀疏表示分类方法不关注任何特征选择技术,而使用单词标识来表示特征,从训练样本中自适应地选择一些相关样本对文本文档进行分类,解决文本数据高维性问题。Sainath等人[3]研究稀疏表示如何用于文本分类,以及分类性能随文档词汇量大小的变化。随后,高等人[4]引入结构化稀疏表示分类器,提高短文本分类效率和性能。该方案虽考虑结构化稀疏表示,但忽略高维数据中被聚类对象不是针对整个空间且子空间重要程度不同。因此,脱婷等人[5]针对短文本在某些潜在子空间比较相似,提出一种熵权约束稀疏表示分类方法,缓解短文本特征稀疏问题。以上这些算法在构建稀疏字典矩阵时未考虑训练样本到所属类别中心的相似度,忽略样本在不同类别中的重要程度及样本之间距离加权因素,分类效果仍不佳。本文提出一种局部加权稀疏表示的文本分类(localweighted-sparserepresentationclassification,LW-SRC)算法。该算法从文本特征局部结构以...