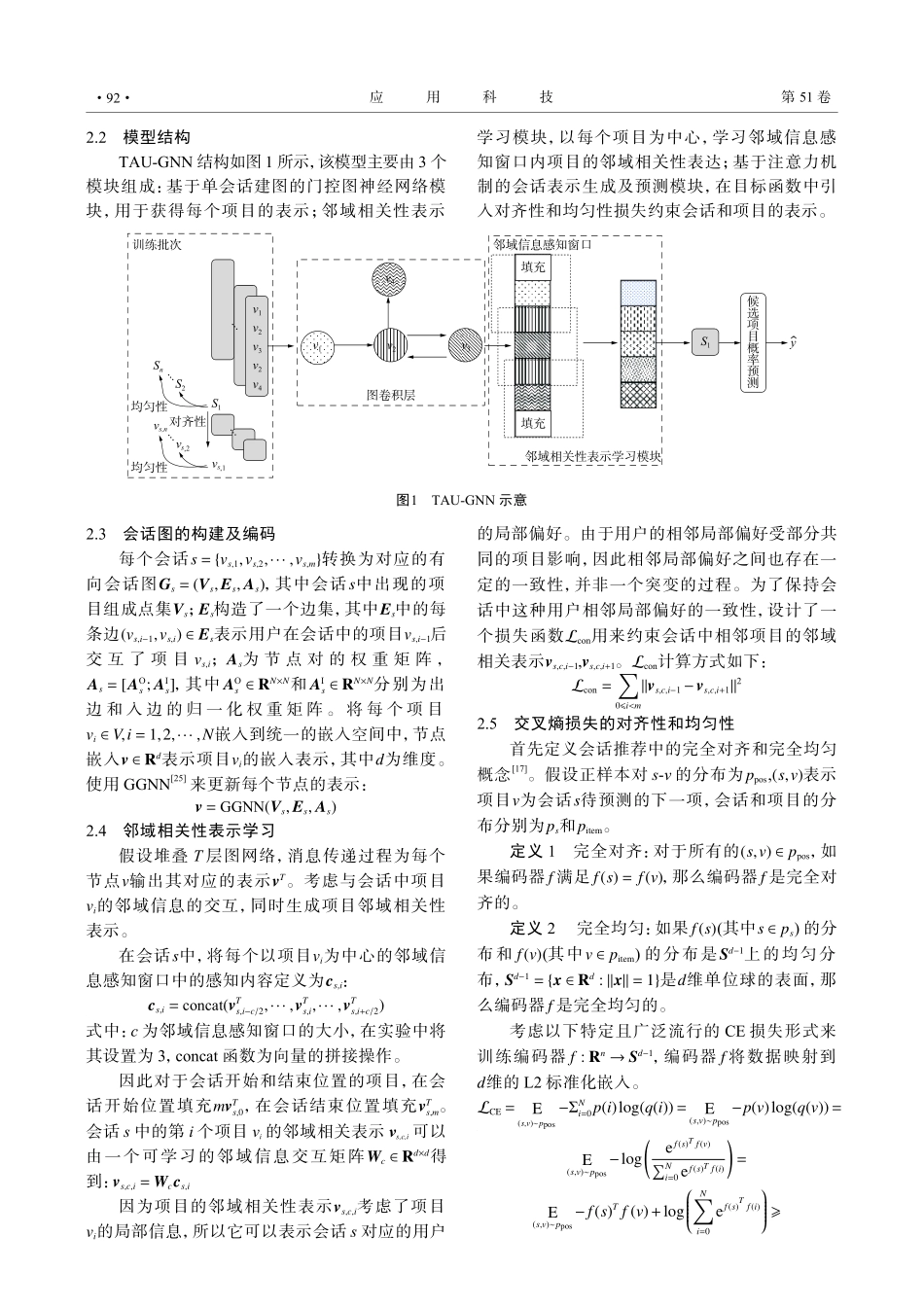

DOI:10.11991/yykj.202306005网络出版地址:https://link.cnki.net/urlid/23.1191.U.20231127.1135.002基于对齐性和均匀性约束的图神经网络会话推荐方法唐韬韬1,楚飞1,汪炅1,贾彩燕1,21.北京交通大学计算机与信息技术学院,北京1000442.交通数据分析与挖掘北京市重点实验室,北京100044摘要:会话推荐(session-basedrecommendation,SBR)旨在匿名状态下通过用户的短期历史行为序列来预测下一个待点击的项目。为解决现有基于图神经网络(graphneuralnetworks,GNNs)的会话推荐方法忽略会话中不同位置相同项目之间差异的问题,在图卷积获得项目表示后,进一步考虑该项目与相邻项目之间的相关性,生成邻域相关的项目表示。此外,鉴于对齐性和均匀性在对比学习中的起到的重要作用,还提出了一种适用于会话推荐的对齐性和均匀性损失方法,以约束生成的会话表示和项目表示。在3个公开数据集上的实验表明,文中提出的模型TAU-GNN的推荐性能优于对比的主流会话推荐模型。关键词:会话推荐;图神经网络;对齐性;均匀性;对比学习;交叉熵损失;匿名会话;邻域信息中图分类号:TP391文献标志码:A文章编号:1009−671X(2024)02−0090−09Graphneuralnetworktowardrepresentationalignmentanduniformityforsession-basedrecommendationTANGTaotao1,CHUFei1,WANGJiong1,JIACaiyan1,21.SchoolofComputerandInformationTechnology,BeijingJiaotongUniversity,Beijing100044,China2.BeijingKeyLabofTrafficDataAnalysisandMining,Beijing100044,ChinaAbstract:Session-basedrecommendation(SBR)aimstopredictthenextclickitemofananonymoususerbasedonashortinteractionsequence.InordertosolvetheproblemthatexistingSBRmethodsbasedongraphneuralnetworks(GNNs)ignorethedifferencesbetweenthesameitemsatdifferentlocationsinasession,afterobtaininganitemembeddingbyaGNN,wefurtherconsiderthecorrelationofitsneighboritemsinasessiontogeneratetheitemneighborhoodcorrelationrepresentation.Consideringtheimportanceofalignmentanduniformityincontrastivelearning,weproposeanalignmentanduniformitylossmethodforsessionrecommendationtoconstrainthegeneratedsessionrepresentationanditemrepresentation.ExperimentsonthreepublicbenchmarkdatasetsshowthatournewlyproposedmodelTAU-GNNisbetterthanthatofthemainstreammodelsforSBR.Keywords:...