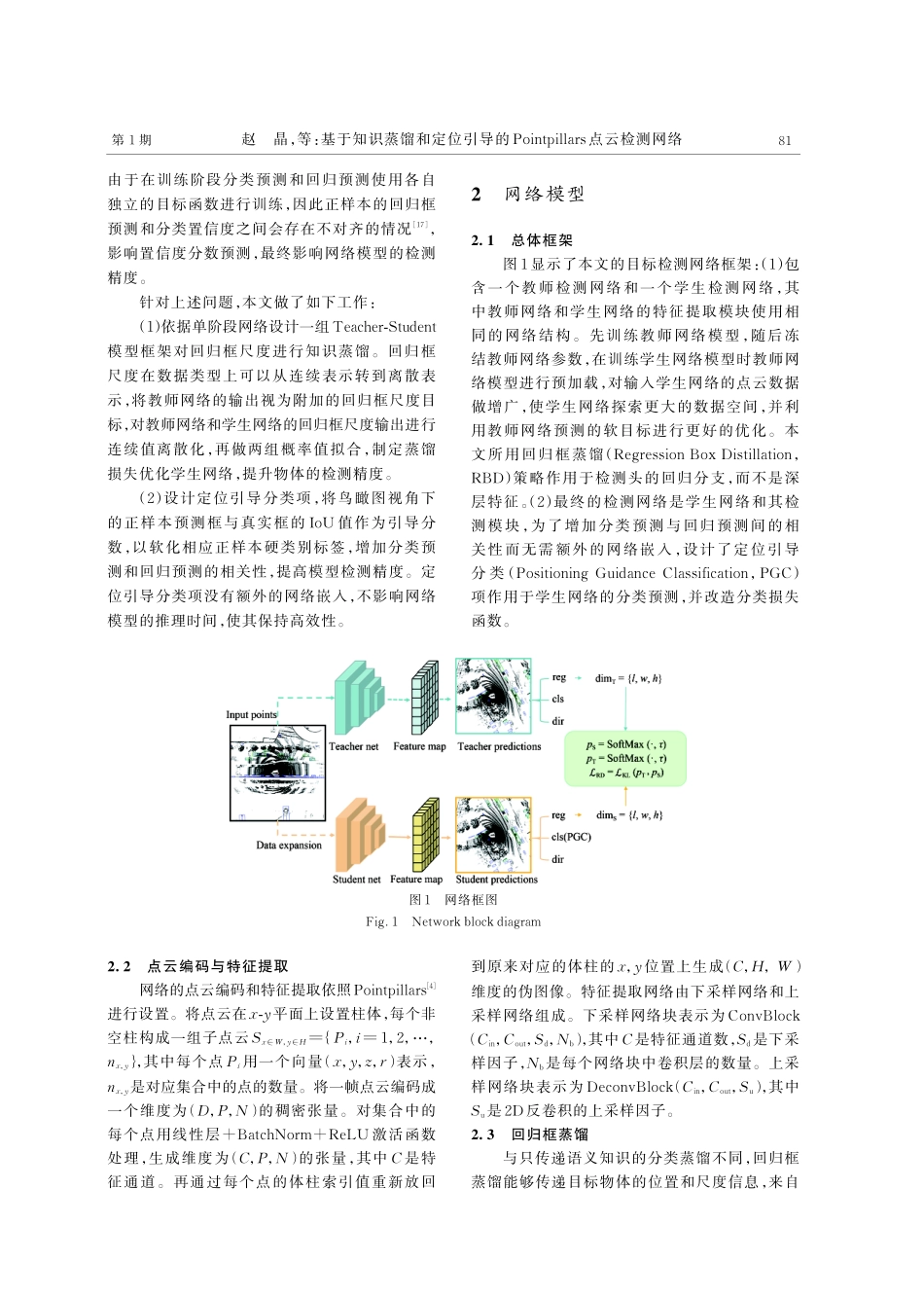

第39卷第1期2024年1月Vol.39No.1Jan.2024液晶与显示ChineseJournalofLiquidCrystalsandDisplays基于知识蒸馏和定位引导的Pointpillars点云检测网络赵晶1,4,李少博1,2,郭杰龙2,3*,俞辉2,3,张剑锋2,3,李杰2,3(1.厦门理工学院电气工程与自动化学院,福建厦门361024;2.中国科学院福建物质结构研究所,福建福州350108;3.中国科学院海西研究院泉州装备制造研究中心,福建泉州362000;4.厦门市高端电力装备及智能控制重点实验室,福建厦门361024)摘要:激光雷达数据由于其几何特性,被广泛应用于三维目标检测任务中。由于点云数据的稀疏性和不规则性,难以实现特征提取的质量和推理速度间的平衡。本文提出一种基于体柱特征编码的三维目标检测算法,以Pointpillars网络为基础,设计Teacher-Student模型框架对回归框尺度进行蒸馏,增加蒸馏损失,优化训练网络模型,提升特征提取的质量。为进一步提高模型检测效果,设计定位引导分类项,增加分类预测和回归预测之间的相关性,提高物体识别准确率。本网络所做改进没有引入额外的网络嵌入。算法在KITTI数据集上的实验结果表明,相比于基准网络,在三维模式下的平均精度值从60.65%提升到了64.69%,鸟瞰图模式下的平均精度值从67.74%提升到70.24%。模型推理速度为45FPS,在提升检测精度的同时满足了实时性要求。关键词:激光点云;三维目标检测;知识蒸馏;分类置信度中图分类号:TP391.4文献标识码:Adoi:10.37188/CJLCD.2023-0058PointpillarspointclouddetectionnetworkbasedonknowledgedistillationandlocationguidanceZHAOJing1,4,LIShaobo1,2,GUOJielong2,3*,YUHui2,3,ZHANGJianfeng2,3,LIJie2,3(1.SchoolofElectricalEngineeringandAutomation,XiamenUniversityofTechnology,Xiamen361024,China;2.FujianInstituteofResearchontheStructureofMatter,ChineseAcademyofSciences,Fuzhou350108,China;3.QuanzhouInstituteofEquipmentManufacturing,HaixiInstitutes,ChineseAcademyofSciences,Quanzhou362000,China;4.XiamenKeyLaboratoryofFrontierElectricPowerEquipmentandIntelligentControly,Xiamen361024,China)Abstract:Lidardataiswidelyusedin3Dtargetdetectiontasksduetoitsgeometriccharacteristics.Due文章编号:1007-2780(2024)01-0079-10收稿日期:2023-02-17;修订日期:2023-03-21.基金项目:福建省科技计划(No.2021T3003);泉州市科技计划...