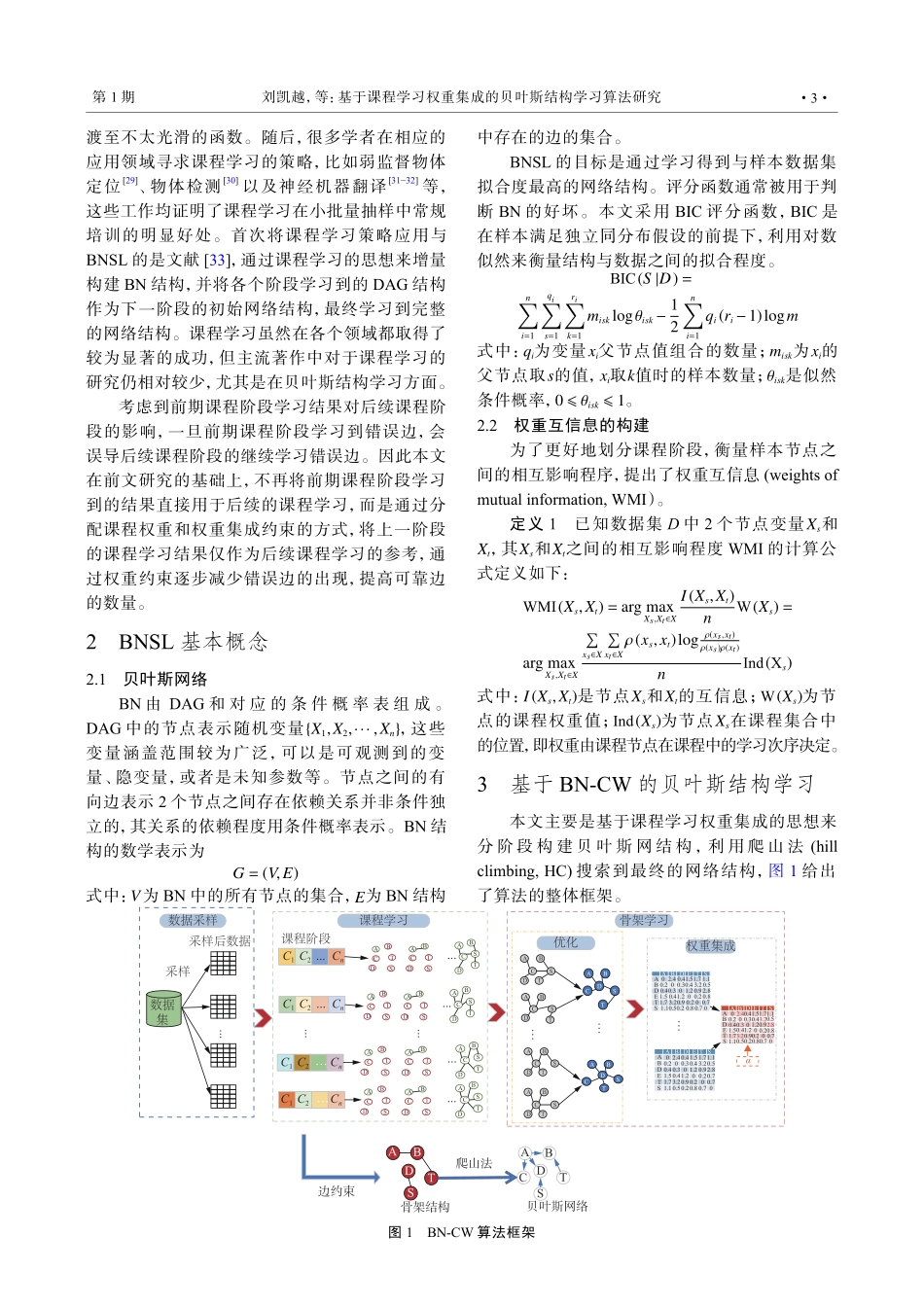

DOI:10.11991/yykj.202305024网络出版地址:https://link.cnki.net/urlid/23.1191.U.20231215.1052.002基于课程学习权重集成的贝叶斯结构学习算法研究刘凯越,周鋆国防科技大学信息系统工程重点实验室,湖南长沙410073摘要:从大量复杂的数据中学习贝叶斯网络(Bayesiannetwork,BN)一直是一个难点问题,本文借鉴课程学习的思想,引入了一种适合于BN中节点之间互相影响程度的测量,然后划分课程阶段,分阶段构造无向图骨架,并利用优化函数对骨架进行优化;通过集成策略,将各个集成学习结果所得到的课程权重进行集合,并通过边过滤来减少错误边的出现;最后,通过爬山搜索构建BN结构。实验结果表明,在4个标准数据集上,本文所提方法具有较高的精确度和稳定性。与多种传统贝叶斯结构学习(Bayesiannetworkstructurelearning,BNSL)方法相比,本文所提方法性能平均提高了37.18%。本文分析结果可为BNSL的增量学习过程进一步提供参考。关键词:贝叶斯网络;结构学习;课程学习;权重;边约束;权重互信息;集成学习;无向图骨架中图分类号:TP181文献标志码:A文章编号:1009−671X(2024)01−0001−09BayesiannetworkstructurelearningbasedoncurriculumlearningweightintegrationLIUKaiyue,ZHOUYunScienceandTechnologyonInformationSystemsandEngineeringLaboratory,NationalUniversityofDefenseTechnology,Changsha410073,ChinaAbstract:LearningBayesiannetwork(BN)fromalargenumberofcomplexdatahasalwaysbeenadifficultproblem.Basedontheideaofcourselearning,thispaperintroducesameasurementsuitableforthedegreeofmutualinfluencebetweennodesinBNstructure,thendividesthecoursestage,constructstheundirectedgraphskeletoninstages,andusestheoptimizationfunctiontooptimizetheskeleton.Throughtheintegrationstrategy,thecourseweightsobtainedfromeachintegratedlearningresultareaggregated,andtheerroredgesarereducedbyedgefiltering.Finally,theBNstructureisconstructedbyhill-climbingsearch.Theexperimentalresultsindicatethatthemethodproposedinthispaperexhibitshighprecisionandstabilityonfourstandarddatasets.Comparedwithvarioustraditionalbayesiannetworkstructurelearning(BNSL)methods,themethodproposedinthispapershowsanaverageperformanceimprovementof37.18%.Theanalyticalresultspresentedinthispapercanfurthe...