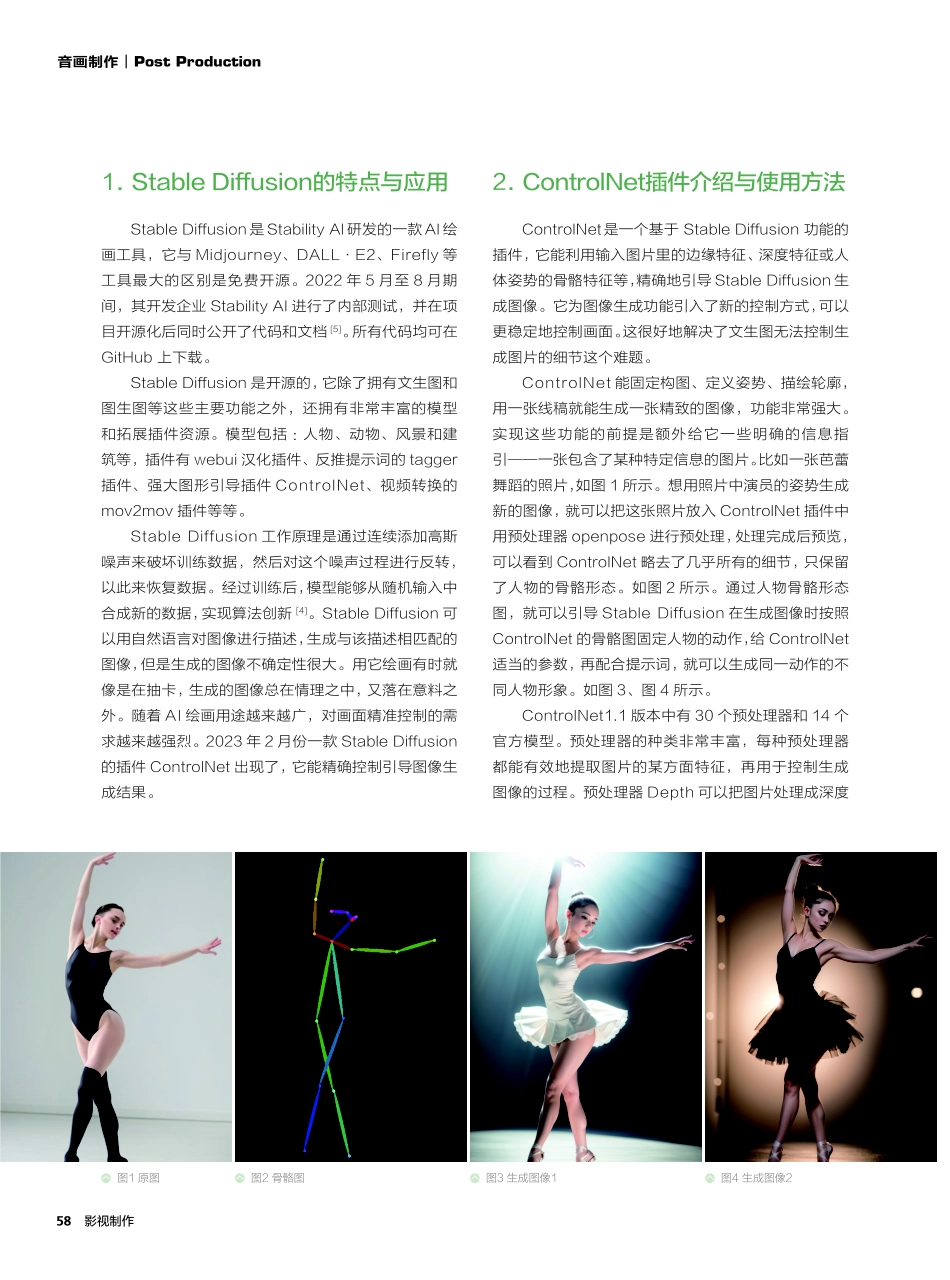

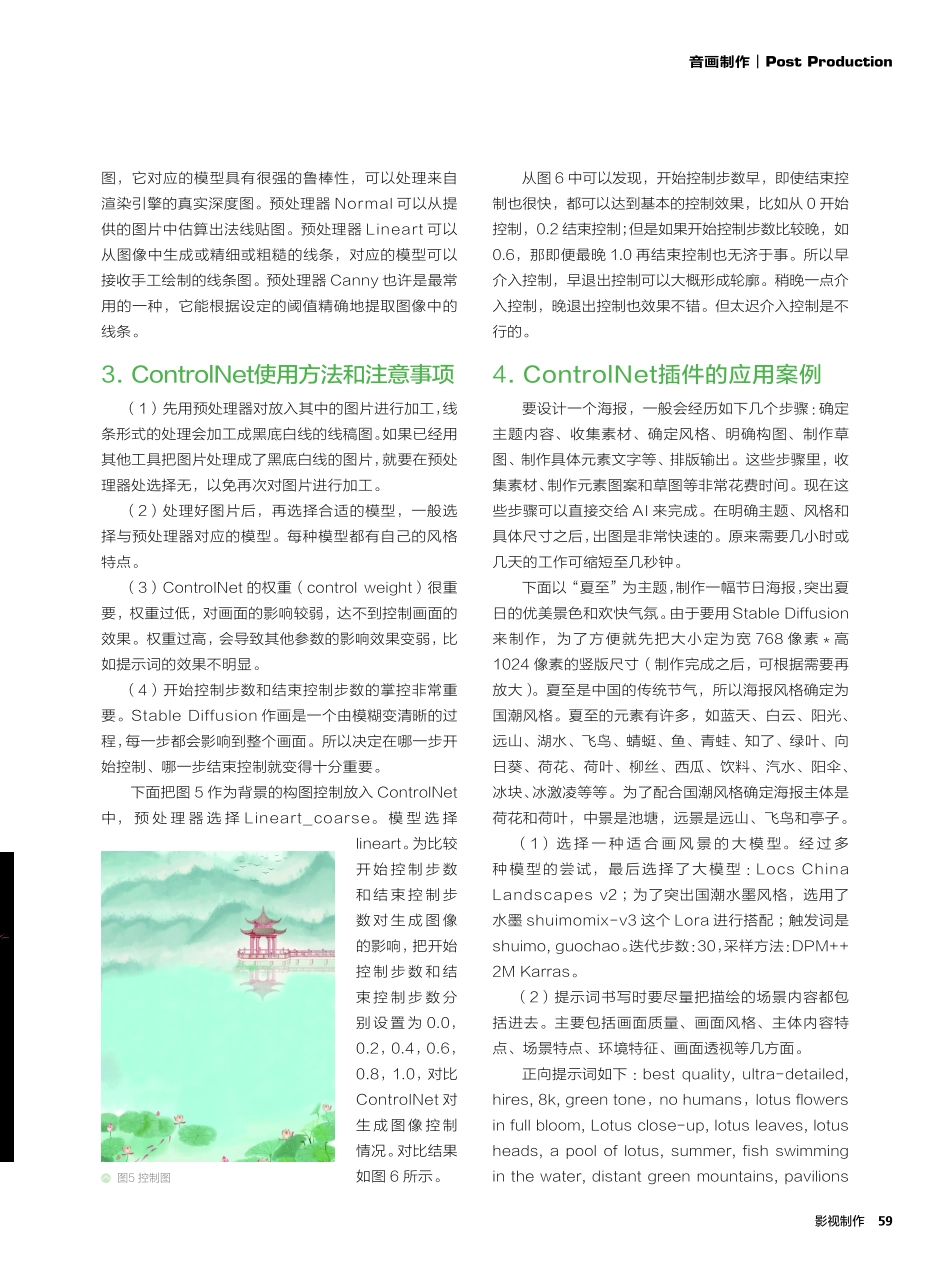

57影视制作音画制作︱PostProductionControlNet插件在AI生成图像中的控制应用分析文/河北工程大学温逸娴摘要:运用AI绘图工具StableDiffusion生成图像的过程中,虽然可以用提示词来描述画面,但生成图像的不确定性很大。为了生成满意的图像,可以使用StableDiffusion的插件ControlNet对图像生成进行控制。本文分析了用ControlNet对图像生成过程的控制方法,并运用该方法在具体案例中实现了在生成图像过程中对画面构图的控制。关键词:AIGC;AI绘画;StableDiffusion;ControlNet;人工智能AI绘图已成为行业关注焦点。它的神奇之处在于,可以通过语言描绘生成一幅杰作。不需要学习绘画,不需要操作各种复杂的作图软件,只需要运用想象力,用语言描述出画面的内容,AI就能在几秒钟之内把画面呈现出来。传统的计算机绘画技术局限于机器执行预先设定的规则和算法,因此无法创造出高质量的图像。随着深度学习和生成对抗网络技术的应用,AI绘画发展出了一种全新的生成方式,即通过对数据集的学习,机器能够自主生成新的图像[1]。AI绘画是一种不需要通过人类主动参与创作而通过计算机视觉即可生成视觉图像的绘画工具,凭借着庞大的数据库和训练样本,就可以根据与图像相关联的关键词,通过其绘画算法输出一张不存在于训练样本数据库中的崭新作品[2]。现在流行的AI绘画工具有Midjourney、StableDiffusion、DALL·E2、Firefly、文心一格等。这些AI绘画工具各有特点。StableDiffusion对于生成当代艺术图像具有较强的理解力,善于刻画图像的细节。DALL·E2由其前身DALL·E发展而来,其训练量无比庞大,更适合用于企业所需的图像生成场景,视觉效果也更接近于真实的照片。而Midjourney则使用Discord机器人来收发对服务器的请求,所有的环节基本上都发生在Discord上,并以其独特的艺术风格而闻名[3]。许多艺术家在寻找灵感时,都会使用Midjourney生成图像。2022年8月,在美国科罗拉多州举办的新兴数字艺术家竞赛中的获奖作品《太空歌剧院》就由Midjourney生成[4]。58影视制作音画制作︱PostProduction1.StableDiffusion的特点与应用StableDiffusion是StabilityAI研发的一款AI绘画工具,它与Midjourney、DALL·E2、Firefly等工具最大的区别是免费开源。2022年5月至8月期间,其开发企业StabilityAI进行了内部测试,并在项目开源化后同时公开了代码和文档[5]。所有代码均可在GitHub上下载。StableDiffusion是开源的,它除了拥有文生图和图生图等这些主要功能之外,...