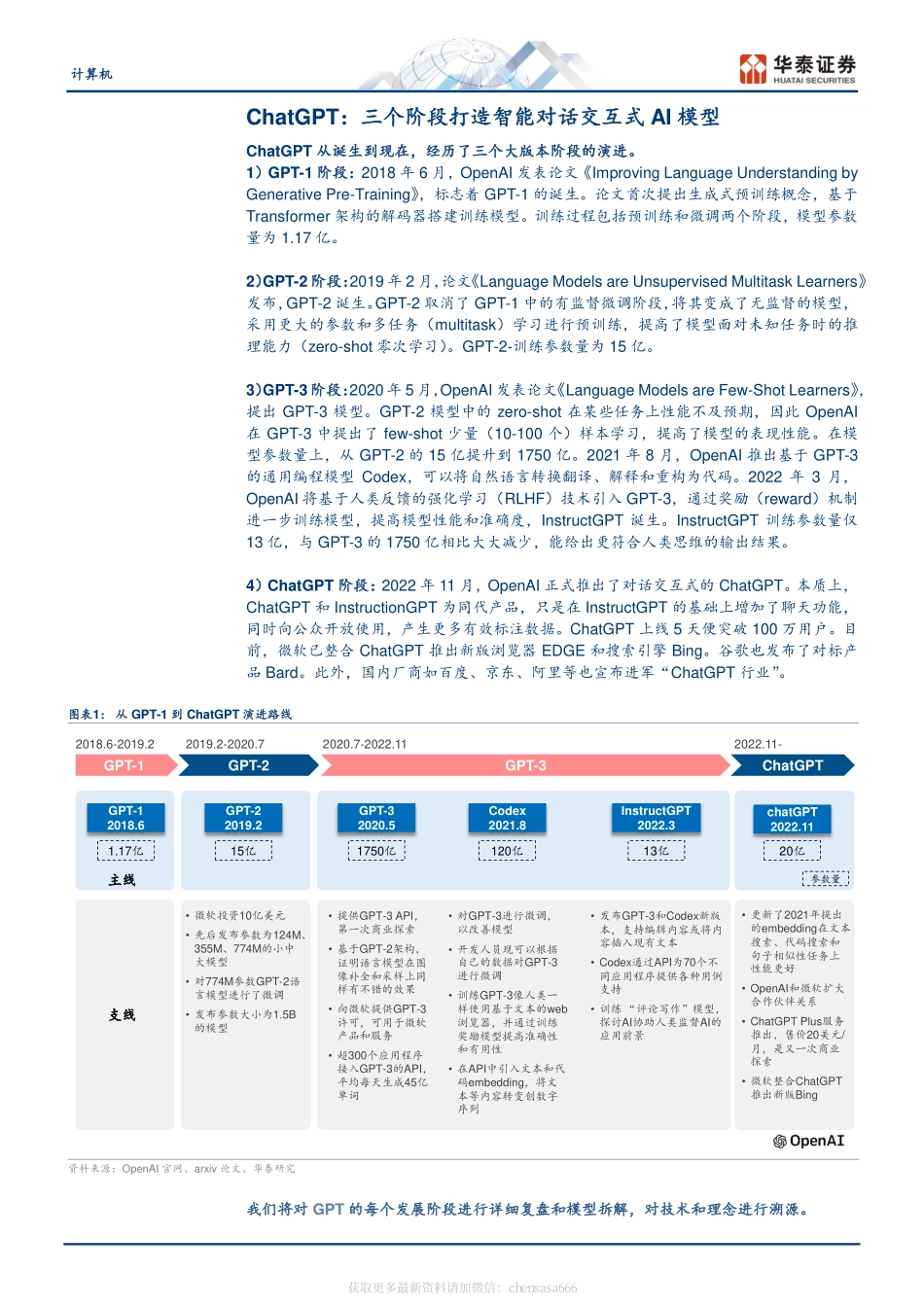

免责声明和披露以及分析师声明是报告的一部分,请务必一起阅读。1证券研究报告计算机GPT产业梳理:GPT-1到ChatGPT华泰研究计算机增持(维持)研究员谢春生SACNo.S0570519080006SFCNo.BQZ938xiechunsheng@htsc.com+(86)2129872036联系人袁泽世,PhDSACNo.S0570122080053yuanzeshi@htsc.com+(86)2128972228行业走势图资料来源:Wind,华泰研究2023年2月14日│中国内地专题研究ChatGPT:三个阶段打造智能对话交互式AI模型ChatGPT从诞生到现在,经历了三个大版本阶段演进。2018年,生成式预训练模型GPT-1诞生,引入有监督的微调训练。2019年,GPT-2以增加模型通用性为目标,移除GPT-1的微调,以更大的参数量和多任务训练,进行zero-shot学习;2020年,GPT-3用few-shot代替zero-shot,并将训练参数增加到1750亿,再次提高模型表现性能。2022年,InstructGPT引入基于人类反馈的强化学习(RLHF),在GPT-3基础上进行奖励训练,以13亿训练参数实现了更好的模型性能。2022年11月,基于InstructGPT,OpenAI正式推出对话交互式模型ChatGPT,5天时间突破了100万用户。GPT-1阶段:开启生成式预训练模型时代GPT-1基于Transformer架构,仅保留了架构中的解码器(Decoder)部分。GPT-1的训练过程包括预训练和微调两个阶段。1)阶段一:预训练采用内含长段连续文本的BooksCorpus数据集,进行高容量无监督学习。2)阶段二:在做下游任务时,首先根据任务类型将其转换为不同的输入形式,再针对不用类型任务用特定训练集进行微调训练。GPT-1的参数量为1.17亿。GPT-1在常识推理、问题回答、文本蕴涵等任务上分别比对比方法进步了8.9%、5.7%和1.5%。GPT-2阶段:无监督训练替代有监督训练GPT-2通过海量数据和庞大的模型参数训练出更为通用的模型,无需经过特定的数据集训练也能解决各类问题,即zero-shotlearning(零次学习),从而提高模型的泛化能力。GPT-2在架构上与GPT-1基本保持相同,预训练阶段与GPT-1方法一致,采用了更大的数据集WebText。处理下游任务时,以无监督的训练方式进行zero-shot学习,通过增加prompt文本提示的方式提示模型具体任务类型。GPT-2的参数量增加到15亿。GPT-2在命名实体识别、阅读理解等任务上表现优异,在部分任务上不及预期。GPT-3阶段:性能不断突破,开启商业探索GPT-3在GPT-2架构基础上,舍弃极端的zero-shot,采用few-shot理念,对于特定任务给予少量(10-100个)样例。GPT-3最大训练参数量为1750亿,训练结果准确度随着few-shot样例的...