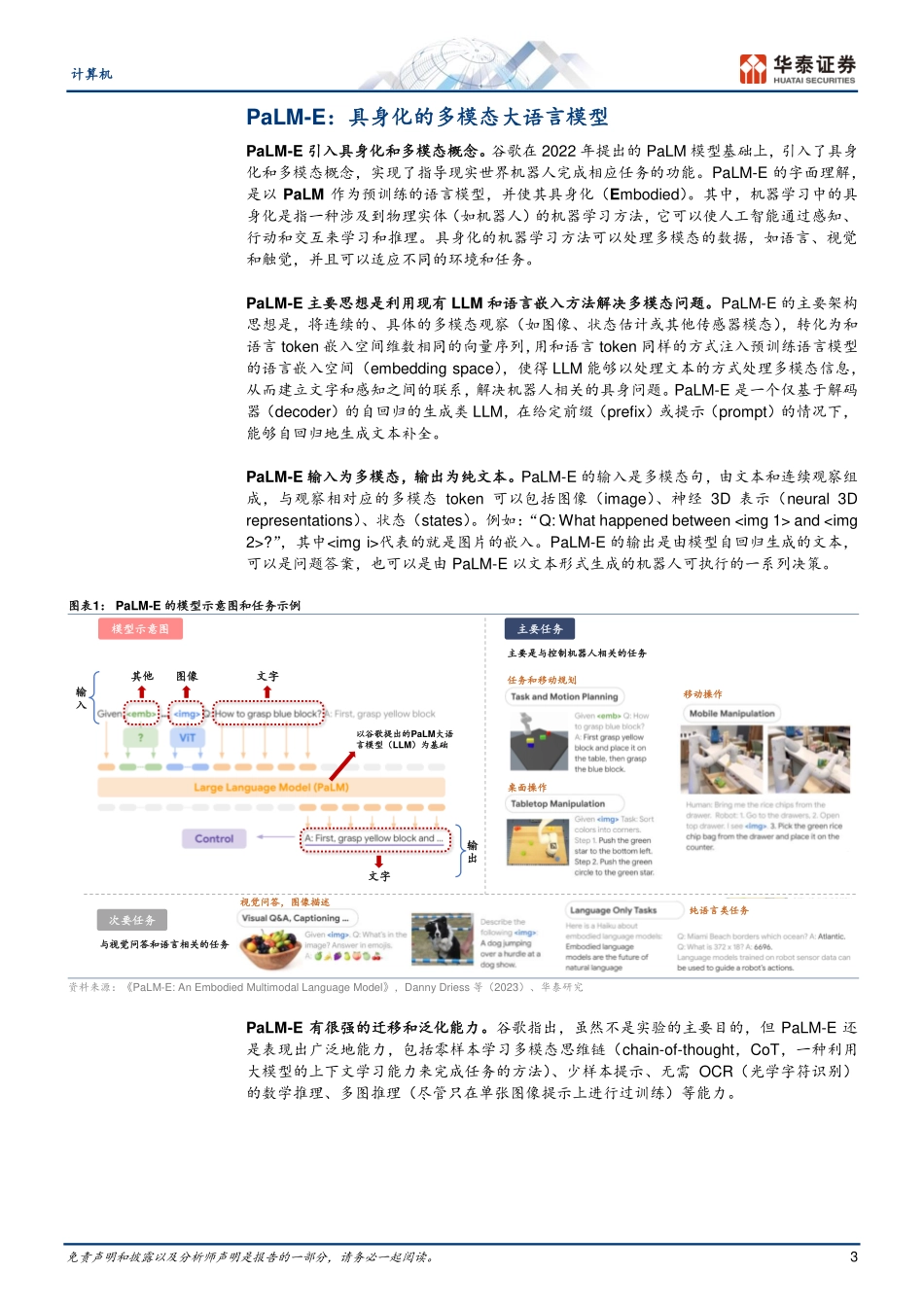

免责声明和披露以及分析师声明是报告的一部分,请务必一起阅读。1证券研究报告计算机GPT系列:具身化多模态PaLM-E华泰研究计算机增持(维持)研究员谢春生SACNo.S0570519080006SFCNo.BQZ938xiechunsheng@htsc.com+(86)2129872036联系人袁泽世,PhDSACNo.S0570122080053yuanzeshi@htsc.com+(86)2128972228行业走势图资料来源:Wind,华泰研究2023年3月14日│中国内地专题研究PaLM-E:具身化的多模态大语言模型PaLM-E是由谷歌于3月6日提出的最新大语言模型,其特点在于引入具身化和多模态概念。具身化指的是在机器学习中涉及物理实体,对应PaLM-E指导现实的机器人完成相应任务;多模态指的是PaLM-E在模型输入中嵌入了文本、图像、具身数据等信息。PaLM-E的核心思想在于,通过将多模态信息编码为与语言相似的形式,嵌入已有的PaLM模型,实现多模态的联合训练。其中,规模最大的PaLM-E参数达5620亿,是目前最大的视觉语言模型。从训练结果看,PaLM-E具有很强的泛化和迁移能力,不仅能完成机器人具身推理任务,还能完成常规的视觉语言任务和通用语言任务。PaLM-E解决了机器学习的grounding问题机器学习的grounding问题,指的是如何将抽象的符号或概念与真实世界的物体或事件联系起来的问题。例如,让机器学习模型将“苹果”这个词与“具有形状、颜色、味道等属性的水果”相关联。已有的很多模型是基于文本数据训练,没能与真实世界的视觉和物理传感器模态建立良好联系,且多模态输入尚未普及,限制了模型在现实世界中的推理能力。PaLM-E通过将图像、文字、具身数据联合训练,并引入多模态输入,增强了模型对现实中对象的理解,实现了机器人处理具身推理任务,较好解决了grounding问题。编码器是实现多模态输入的关键对应不同类别的多模态,需要分别设计不同类型的编码器进行编码。根据多模态的种类,PaLM-E涉及的编码器主要包括:1)状态估计向量,实现物体位置、尺寸和颜色等状态信息编码;2)ViT:实现2D图像编码;3)对象为中心的表示:实现对视觉输入中各对象的编码;4)OSRT:实现对3D场景的编码;5)实体引用:实现对难以用自然语言表述的对象的指代。完成编码后,即可注入已有模型进行训练和下游任务执行。PaLM-E以“在环路”的方式指导现实机器人完成具身任务PaLM-E训练数据集包含数十个子训练集,涉及视觉、语言和具身数据。由于以往的LLM在具身研究和相应数据集积累上较少,因此训练集中的具身数据占比仅8.9%。在实际执行任务时,PaLM-E以“在环...