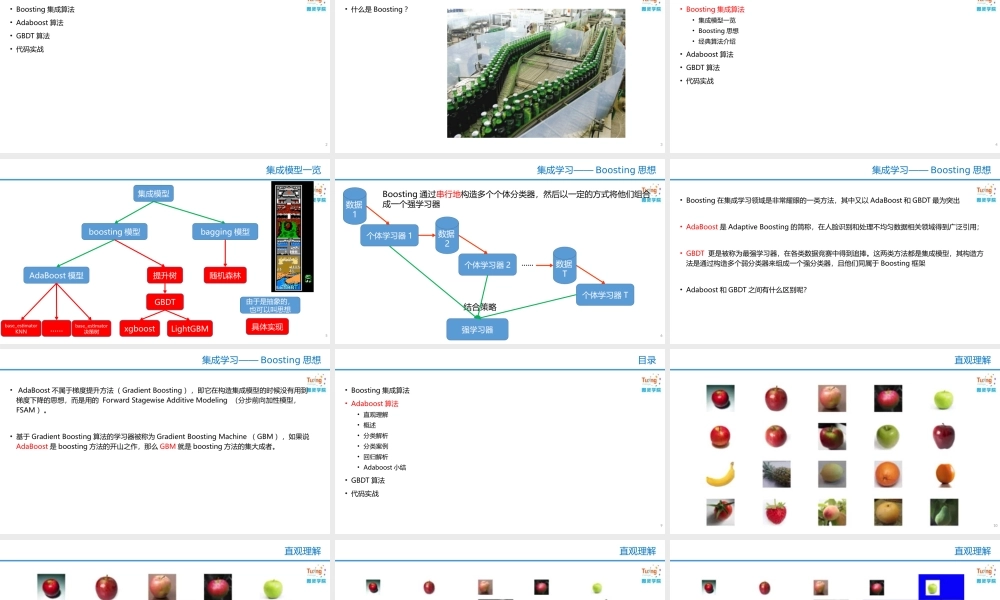

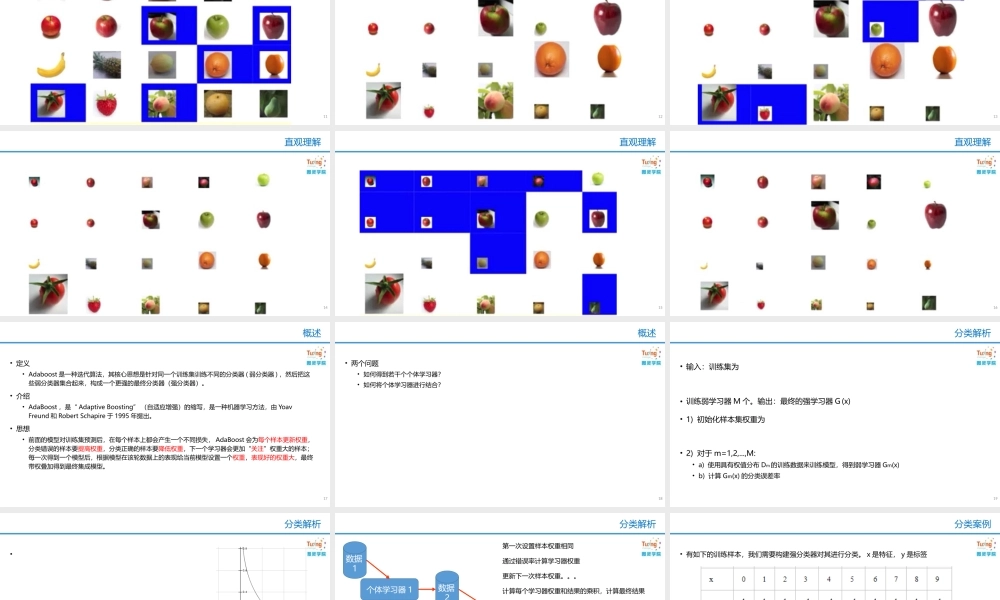

徐idealxuideal@163.com集成学习2•Boosting集成算法•Adaboost算法•GBDT算法•代码实战目录2•什么是Boosting?目录3•Boosting集成算法•集成模型一览•Boosting思想•经典算法介绍•Adaboost算法•GBDT算法•代码实战目录4集成模型一览5由于是抽象的,也可以叫思想具体实现集成模型boosting模型bagging模型AdaBoost模型提升树GBDTxgboost随机森林base_estimatorKNNbase_estimator决策树……LightGBM集成学习——Boosting思想6个体学习器1强学习器结合策略数据1个体学习器2数据2个体学习器T数据T......Boosting通过串行地构造多个个体分类器,然后以一定的方式将他们组合成一个强学习器•Boosting在集成学习领域是非常耀眼的一类方法,其中又以AdaBoost和GBDT最为突出•AdaBoost是AdaptiveBoosting的简称,在人脸识别和处理不均匀数据相关领域得到广泛引用;•GBDT更是被称为最强学习器,在各类数据竞赛中得到追捧。这两类方法都是集成模型,其构造方法是通过构造多个弱分类器来组成一个强分类器,且他们同属于Boosting框架•Adaboost和GBDT之间有什么区别呢?集成学习——Boosting思想•AdaBoost不属于梯度提升方法(GradientBoosting),即它在构造集成模型的时候没有用到梯度下降的思想,而是用的ForwardStagewiseAdditiveModeling(分步前向加性模型,FSAM)。•基于GradientBoosting算法的学习器被称为GradientBoostingMachine(GBM),如果说AdaBoost是boosting方法的开山之作,那么GBM就是boosting方法的集大成者。集成学习——Boosting思想•Boosting集成算法•Adaboost算法•直观理解•概述•分类解析•分类案例•回归解析•Adaboost小结•GBDT算法•代码实战目录9直观理解10直观理解11直观理解12直观理解13直观理解14直观理解15直观理解16概述17•定义•Adaboost是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。•介绍•AdaBoost,是“AdaptiveBoosting”(自适应增强)的缩写,是一种机器学习方法,由YoavFreund和RobertSchapire于1995年提出。•思想•前面的模型对训练集预测后,在每个样本上都会产生一个不同损失,AdaBoost会为每个样本更新权重,分类错误的样本要提高权重,分类正确的样本要降低权重,下一个学习器会更加“关注”权重大的样本;每一次得到一个模型后,根据模型在该轮数据上的表现给当前模型设置一个权重,表现好的...