1.HBase安装操作1.1上传解压HBase安装包tar-xvzfhbase-2.1.0.tar.gz-C../server/1.2修改HBase配置文件1.2.1hbase-env.shcd/export/server/hbase-2.1.0/confvimhbase-env.sh#第28行exportJAVA_HOME=/export/server/jdk1.8.0_241/exportHBASE_MANAGES_ZK=false1.2.2hbase-site.xmlvimhbase-site.xml------------------------------

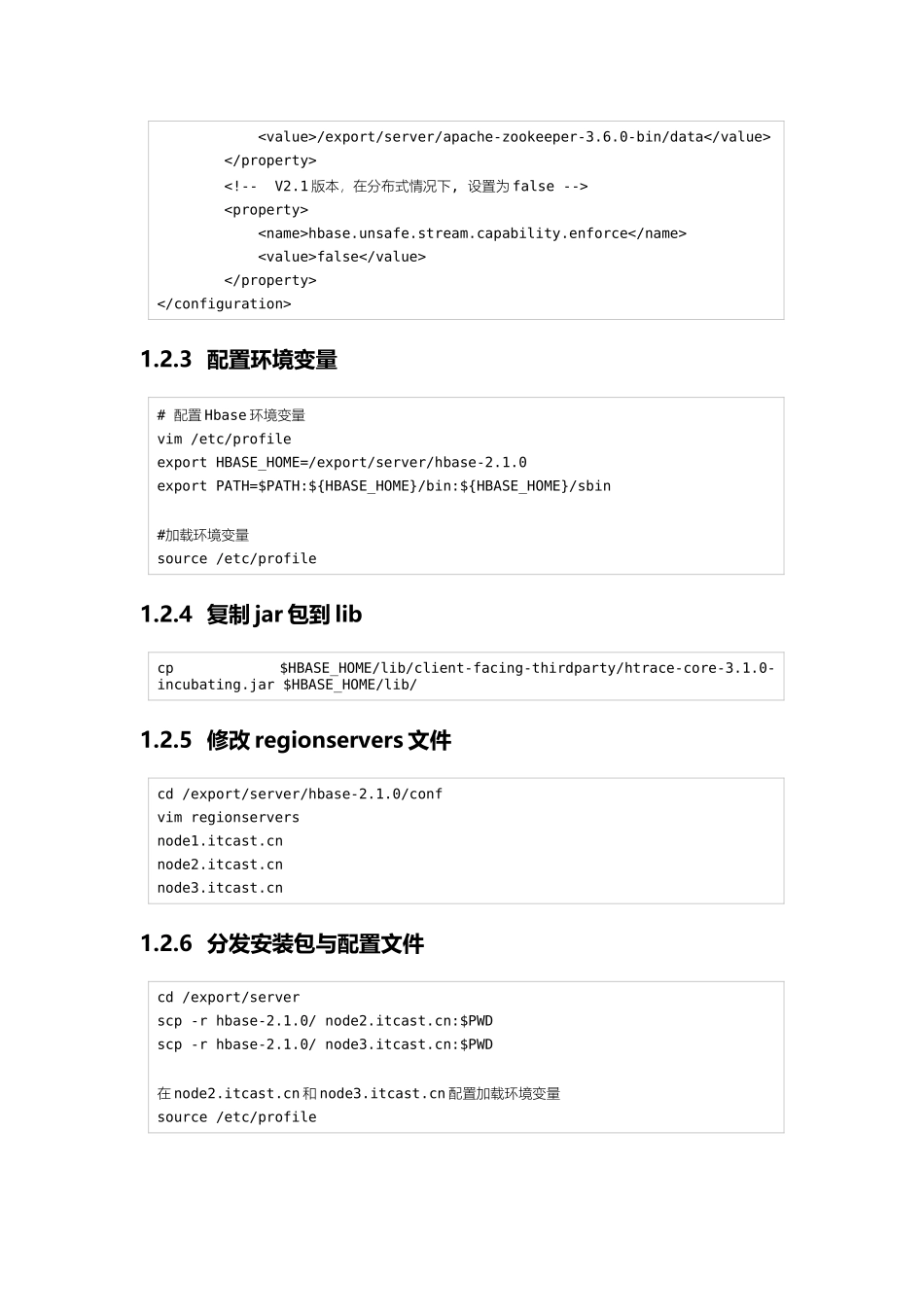

hbase.rootdirhdfs://node1.itcast.cn:8020/hbasehbase.cluster.distributedtruehbase.zookeeper.quorumnode1.itcast.cn,node2.itcast.cn,node3.itcast.cnhbase.zookeeper.property.dataDir/export/server/apache-zookeeper-3.6.0-bin/datahbase.unsafe.stream.capability.enforcefalse1.2.3配置环境变量#配置Hbase环境变量vim/etc/profileexportHBASE_HOME=/export/server/hbase-2.1.0exportPATH=$PATH:${HBASE_HOME}/bin:${HBASE_HOME}/sbin#加载环境变量source/etc/profile1.2.4复制jar包到libcp$HBASE_HOME/lib/client-facing-thirdparty/htrace-core-3.1.0-incubating.jar$HBASE_HOME/lib/1.2.5修改regionservers文件cd/export/server/hbase-2.1.0/confvimregionserversnode1.itcast.cnnode2.itcast.cnnode3.itcast.cn1.2.6分发安装包与配置文件cd/export/serverscp-rhbase-2.1.0/node2.itcast.cn:$PWDscp-rhbase-2.1.0/node3.itcast.cn:$PWD在node2.itcast.cn和node3.itcast.cn配置加载环境变量source/etc/profile1.2.7启动HBasecd/export/server#启动ZK./start-zk.sh#启动hadoopstart-dfs.sh#启动hbasestart-hbase.sh1.2.8验证Hbase是否启动成功#启动hbaseshell客户端hbaseshell#输入status[root@node1onekey]#hbaseshellSLF4J:ClasspathcontainsmultipleSLF4Jbindings.SLF4J:Foundbindingin[jar:file:/export/server/hadoop-2.7.5/share/hadoop/common/lib/slf...