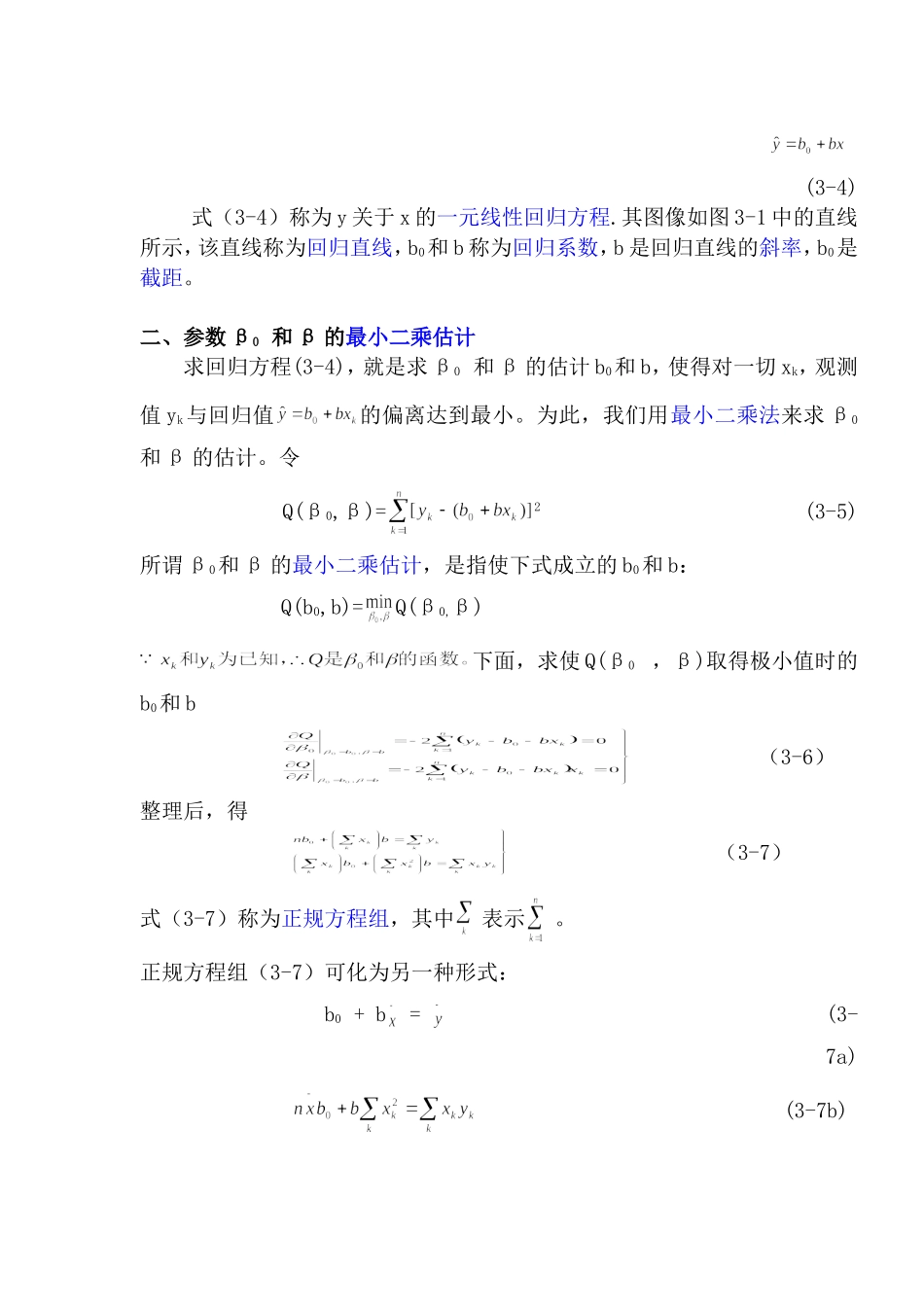

第3章回归分析3.1什么叫回归分析一、问题的提出回归分析是数理统计中的一种常用方法,是处理变量之间的相关关系的一种数学方法。通常将变量之间的关系分为以下两类:1.确定性关系——函数关系例如,在研究自由落体的运动规律中,我们知道物体下落的高度h与所需时间t之间,就有确定的关系h=0.5gt2(0≤t<T)又如正方形的面积S与边长a之间,当边长a确定时,面积S=a2,也就确定了,这类变量间关系的特点是,当自变量的值确定之后,因变量的值也随之确定,我们称变量间的这种关系为函数关系。2.非确定性关系——相关关系例如,人的身高与体重这两个变量间的关系,一般来说,身高者体也重,但是,体重却难以由身高确定。这说明这两个变量之间的不确定性。我们称变量间的这种关系为相关关系。相关关系虽然不能用精确的函数关系表达,但通过对大量观测数据的分析,可以发现它们之间存在着一定的统计规律。二、回归分析的内容——研究相关关系回归分析是研究变量间相关关系的一种数理统计方法,它主要解决以下几个问题:(1)从一组数据出发,确定相互间是否存在相互关系,如果存在,那么就确定他们之间的数学表达式——经验公式,并对所建立公式的可信程度作统计检验;(2)从许多变量中找出主要变量,判断哪些变量的影响是显著的,哪些变量的影响是不显著的。(3)利用所找到的数学表达式(即经验公式)对变量进行预测或控制3.2一元线性回归分析一、一元线性回归分析的数学模型研究两个变量之间的相关关系的回归分析,称为一元回归。若其相关关系的统计规律性呈线性关系,则称为一元线性回归分析。在一元线性回归中,我们要考察随机变量y与普通变量x之间的相互关系,称y为因变量,x为自变量。例3-1用银盐法测定食品中的砷时,吸光度y与砷含量x之间有一定的相关关系,了解其相关关系的步骤如下:1.通过试验收集n组y与对应的x值,如表3-1所示。表3-1银盐法测定食品中砷的试验数据试验号x(砷含量,mg)y(吸光度)100.000210.041330.145450.211570.306690.3992.画散点图。这是表示两个变量间相关关系的一种直观办法。以x为横坐标,以y为纵坐标,每一对数据(xk,yk)作为一个点在坐标纸上以“⊙”表示出来,k=1,2,……,n。3.观察散点图。从图中可以看出,6个点分布在一条直线附件。因此可认为y~x基本上服从线性关系,而这些点与直线的偏离是由于其它随机因素造成的。因此,可以假定表3-1中的数据有如下关系:(3-1)ε~N(0,σ2)其中(β0+βx)表示y随...