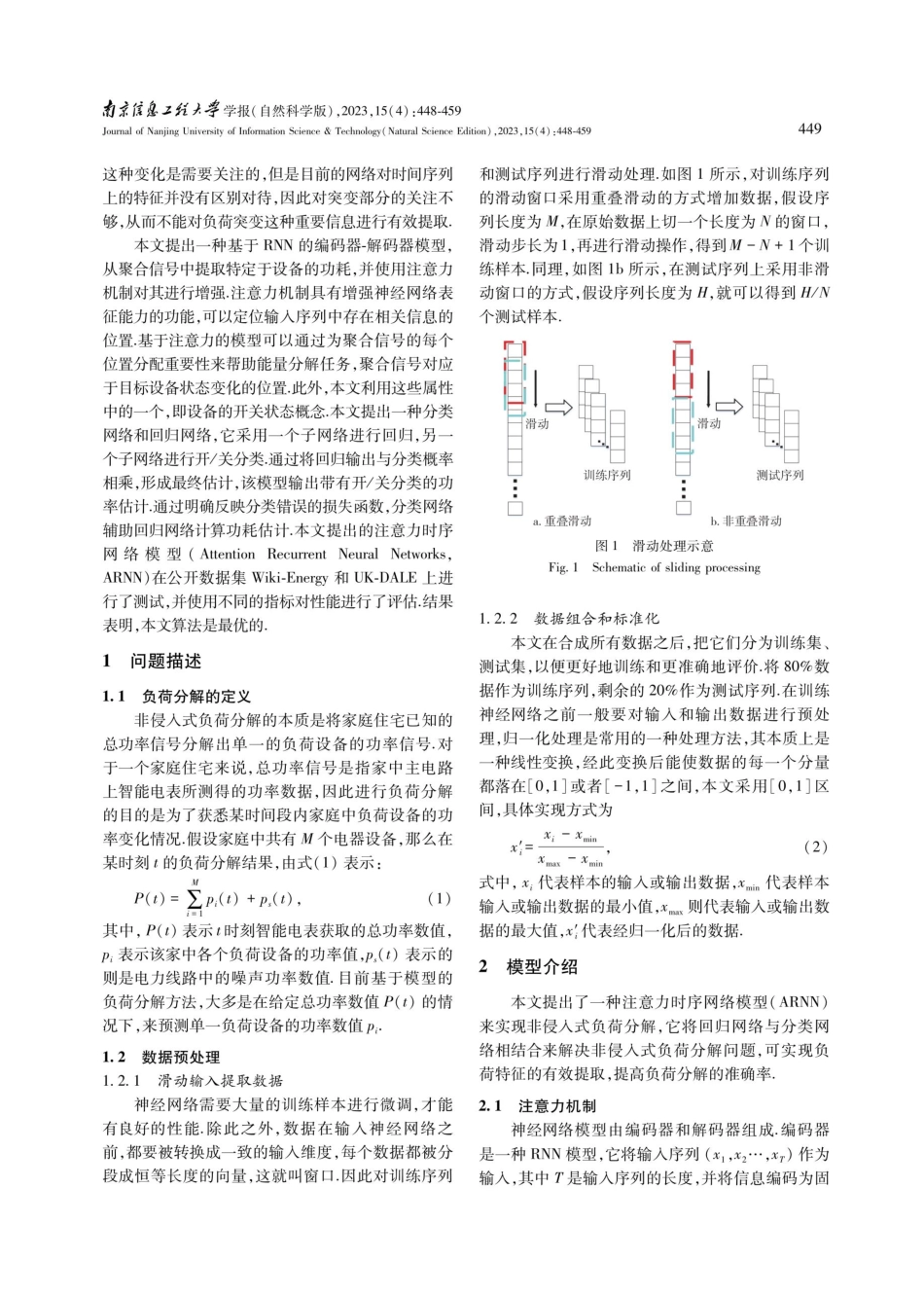

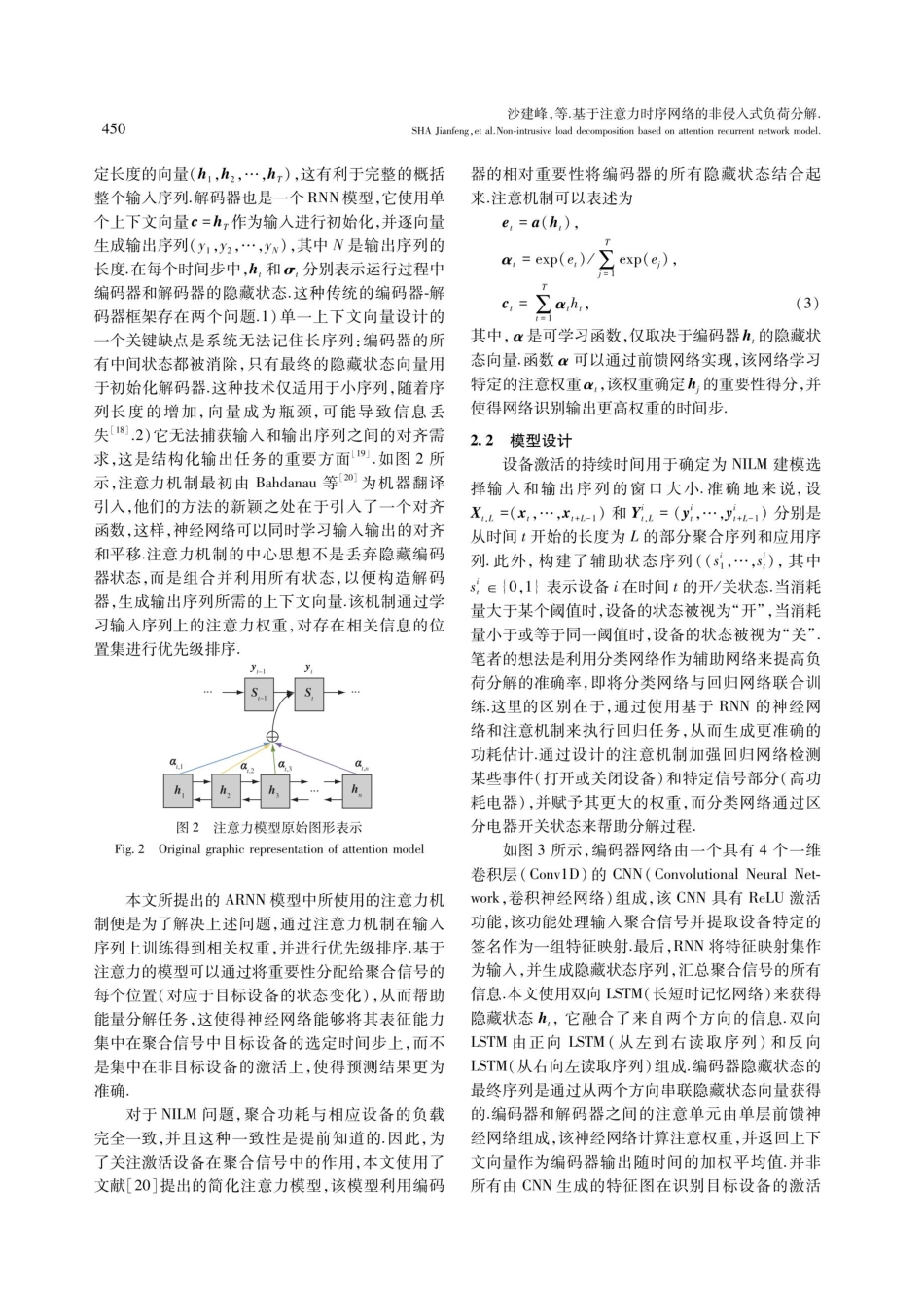

D0I:10.13878/j.cnki.jnuist.20220703002沙建峰席乐冯亚杰庄伟?基于注意力时序网络的非侵人式负荷分解摘要非侵入式负荷分解的本质是根据已知的总功率信号分解出单一的负荷设备的功率信号.目前基于深度学习模型大多存在网络模型负荷特征提取不充分、分解精度低、对使用频率较低的负荷设备分解误差大等问题.本文提出一种注意力时序网络模型(AttentionRecurrentNeuralNetwork,ARNN)实现非侵入式负荷分解,它将回归网络与分类网络相结合来解决非侵入式负荷分解问题.该模型通过RNN网络实现对序列信号特征的提取,同时利用注意力机制定位输入序列中重要信息的位置,提高神经网络的表征能力.在公开数据集Wiki-Energy以及UK-DALE上进行的对比实验结果表明,本文提出的深度神经网络在所有考虑的实验条件下都是最优的.另外,通过注意力机制和辅助分类网络能够正确检测设备的开启或关闭,并定位高功耗的信号部分,提高了负荷分解的准确性.关键词负荷分解;时序网络;注意力机制;辅助分类中图分类号TP714文献标志码A收稿日期2022-07-03资助项目国家自然科学基金(61773219)作者简介沙建峰,男,高级工程师,研究方向为电力通信网分析、电力大数据分析.18103913399@163.com庄伟(通信作者),男,博士,副教授,主要研究方向为大数据分析理论及应用.zWw@nuist.edu.cn1国网河南电动汽车服务有限公司,郑州,4500522南京信息工程大学计算机学院,南京,2100440引言负荷监测方法有助于用户了解用电现状,减少能源消耗,也有助于电网公司实现科学的电力调度,从而达到节能减耗的目的.目前负荷监测有两种方法,即侵人式负荷监控(IntrusiveLoadMonitoring,ILM)和非侵人式负荷监控(Non-IntrusiveLoadMonitoring,NILM).ILM需要在每个设备上安装至少一个传感器来分别监控负荷,而NILM只需要在每个家庭的总线上安装一个传感器.NILM在物理上很简单,但方法更为复杂,因此基于NILM的方法得到了更广泛的研究.为了提高能源效率和加快智能电网的发展[-],特别是在可再生能源日益普及[4的情况下,非侵入式负荷分解的问题受到广泛关注.NILM的分解方法可分为基于事件和非基于事件(无事件)两种类型.基于事件的方法捕获切换事件期间设备状态的变化[5】,这种方法通常需要高频采样以便提取丰富的特征以获得辨识高精度.一些相关工作在kHz的采样频率下提取了这些瞬态特征[6-8].非基于事件的方法不会特别检测任何设备的状态变化,相反会考虑所有设备电源状态.非基于事件的方法...