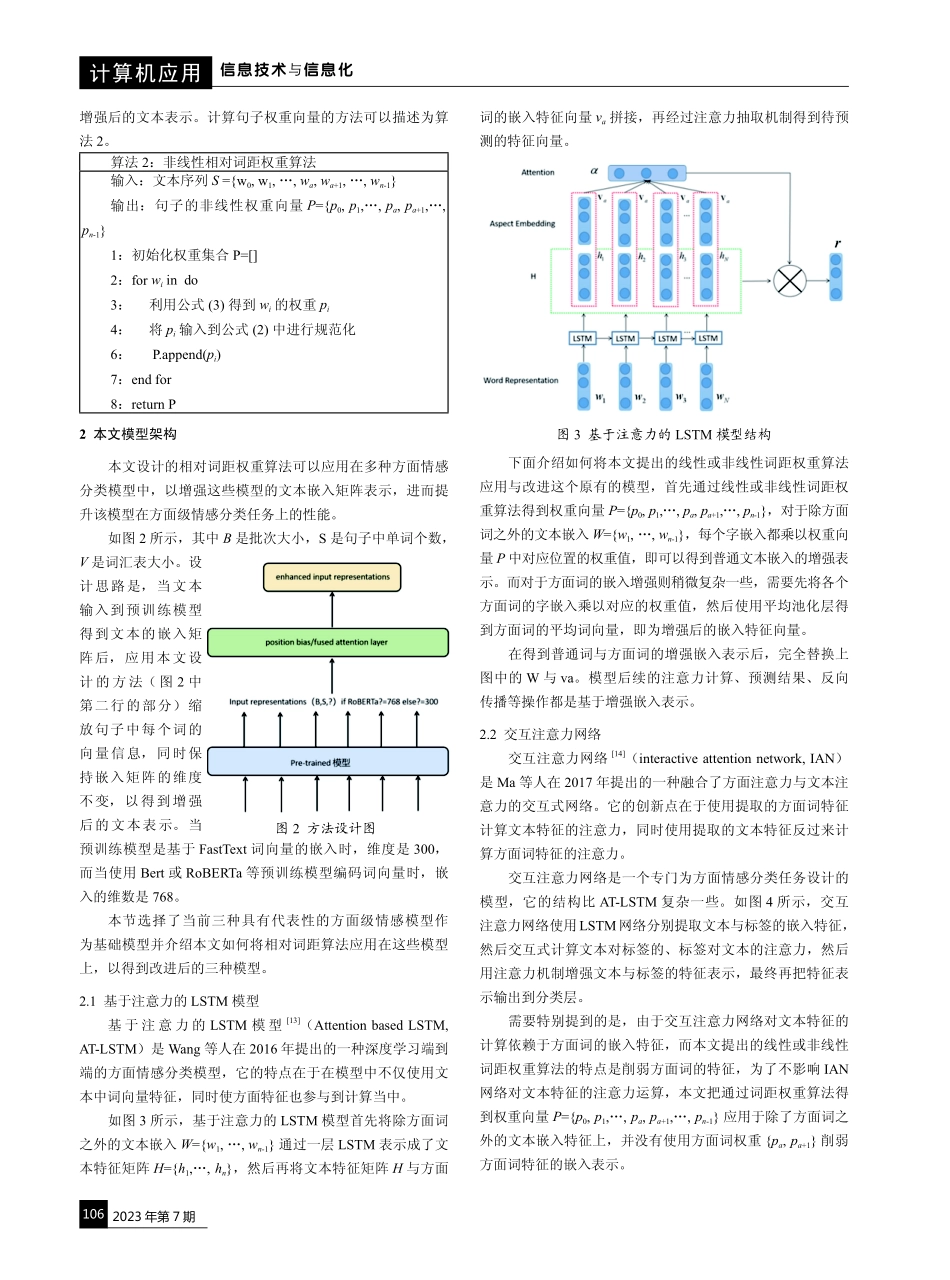

2023年第7期104计算机应用信息技术与信息化基于相对词距权重的方面情感分类模型徐明1仇丽青1张晶2XUMingQiuLiqingZhangJing摘要针对方面情感分类模型易受与目标方面无关的描述性词汇干扰的问题,本文提出了相对词距权重算法(relativeworddistanceweight,RWDW)。首先,RWDW将每个词语与方面词之间的相对距离转化为注意力权重,然后刻画每个词汇对于方面词的关键程度,使模型优先关注靠近方面词的上下文信息;最后,本研究将表征词间距离的权重关系作为先验知识,成功地将其融入了Aspect-LSTM和IAN模型之中,设计了两种基于相对词距权重的方面情感分类模型:RWDW-LSTM和RWDW-IAN。实验结果表明,使用RWDW算法优化后的RWDW-LSTM和RWDW-IAN模型在准确率和鲁棒性方面均实现了显著提升。关键词情感分析;先验注意力机制;词相对距离;深度学习doi:10.3969/j.issn.1672-9528.2023.07.0261.山东科技大学山东青岛2665902.青岛尤尼科信息科技有限公司山东青岛266000[基金项目]山东省社会科学规划数字山东研究专项(项目号:21CSDJ48)0引言情感分析的主要任务是提取分析和归纳人们生活中带有情感色彩的主观文本。根据处理的文本粗细度,情感分析可以分为文本级、句子级和方面级三个层次[1]。其中,文本级和句子级的文本或句子中通常只包含一种情感,情感分析相对粗粒度。传统的情感分析通常只分析个人观点,即个人对某个人或事的看法是积极、中立还是消极的。新型社交媒体的出现使得人们可以把互联网当做发表观点和交流意见的大数据平台,当下的情感分析任务正是分析这种大规模的线上非要对语言表达过程中的语法规则、方面抽取以及情感捕捉等问题进行更深入的研究,因此方面级情感分析是一项更具挑战性的任务。作为情感分析领域中重要的研究方向之一[2],方面情感分析旨在识别特定文本的特定方面的情感极性。例如,在“这个餐厅的食物味道很好但价格太贵了”这句话中,在同一个句子中出现了两个方面:“味道”和“价格”,同时也有两个不同方面极性:正面和负面。传统的解决方案是结合情感词典的自定义规则方法[3-4],但这种方法泛化性较弱,严重依赖领域专家。近年来,随着深度学习技术的发展,基于神经网络的方面级情感分析研究取得了重大进展[5]。Dong等人[6]提出一种基于依存树的自适应递归神经网络,针对给定的情感文本生成依存树,并根据文本中不同的目标词来变换依存树,从而使目标词处于树根位置。并且在计算父节点的向量矩阵时,通过多种不同的组...