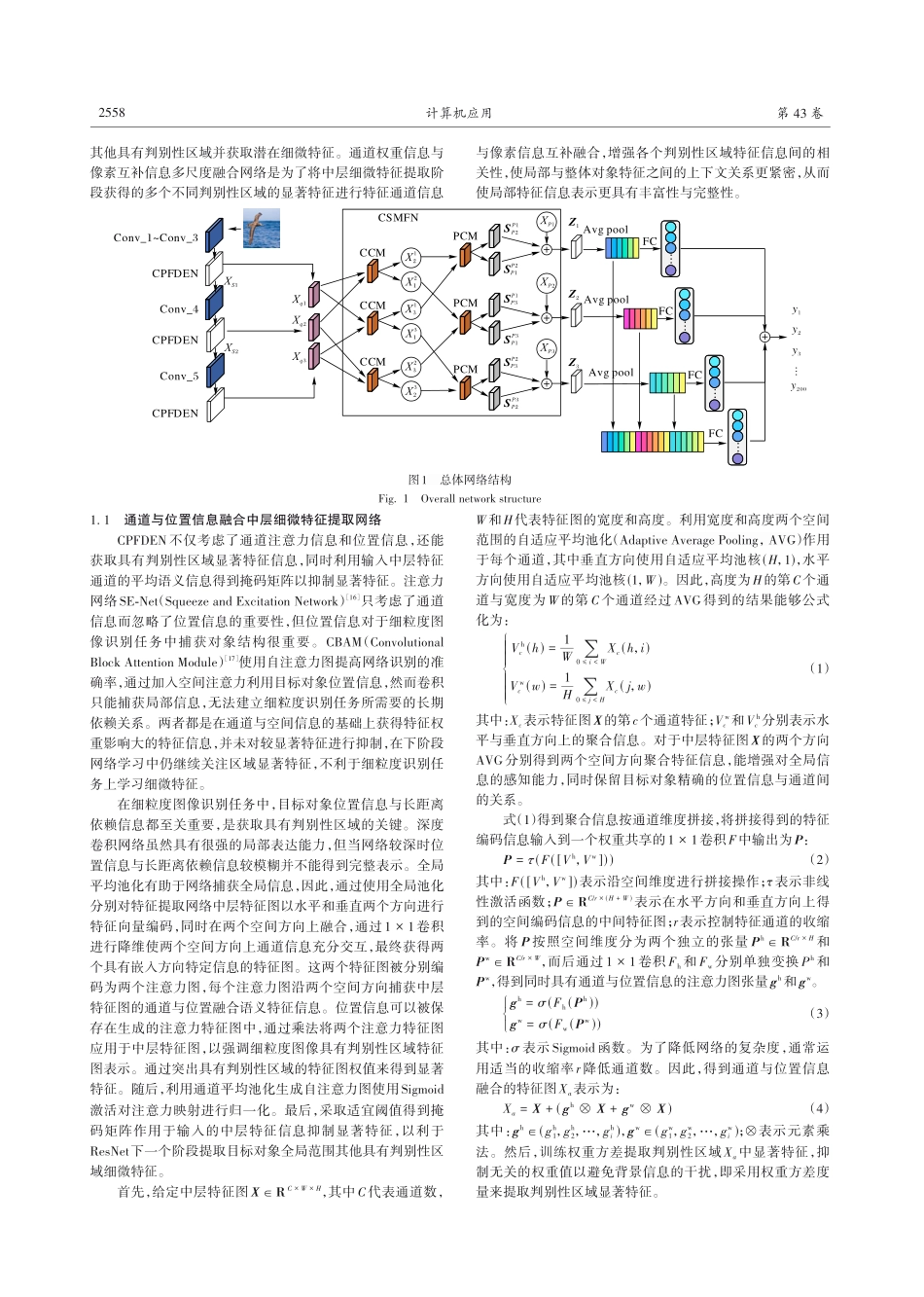

2023⁃08⁃10计算机应用,JournalofComputerApplications2023,43(8):2556-2563ISSN1001⁃9081CODENJYIIDUhttp://www.joca.cn基于中层细微特征提取与多尺度特征融合细粒度图像识别齐爱玲,王宣淋*(西安科技大学计算机科学与技术学院,西安710600)(∗通信作者电子邮箱2283816644@qq.com)摘要:在细粒度视觉识别领域,由于高度近似的类别之间差异细微,图像细微特征的精确提取对识别的准确率有着至关重要的影响。现有的相关热点研究算法中使用注意力机制提取类别特征已经成为一种趋势,然而这些算法忽略了不明显但可区分的细微部分特征,并且孤立了对象不同判别性区域之间的特征关系。针对这些问题,提出了基于中层细微特征提取与多尺度特征融合的图像细粒度识别算法。首先,利用通道与位置信息融合中层特征的权重方差度量提取图像显著特征,之后通过通道平均池化获得掩码矩阵抑制显著特征,并增强其他判别性区域细微特征的提取;然后,通过通道权重信息与像素互补信息获得通道与像素多尺度融合特征,以增强不同判别性区域特征的多样性与丰富性。实验结果表明,所提算法在数据集CUB-200-2011上达到89.52%的Top-1准确率、98.46%的Top-5准确率;在StanfordCars数据集上达到94.64%的Top-1准确率、98.62%的Top-5准确率;在飞行器细粒度分类(FGVC-Aircraft)数据集上达到93.20%的Top-1准确率、97.98%的Top-5准确率。与循环协同注意力特征学习网络PCA-Net(ProgressiveCo-AttentionNetwork)算法相比,所提算法的Top-1准确率分别提升了1.22、0.34和0.80个百分点,Top-5准确率分别提升了1.03、0.88和1.12个百分点。关键词:细粒度图像识别;注意力机制;权重方差;掩码矩阵;多尺度融合;中层特征中图分类号:TP391.4文献标志码:AFine-grainedimagerecognitionbasedonmid-levelsubtlefeatureextractionandmulti-scalefeaturefusionQIAiling,WANGXuanlin*(CollegeofComputerScienceandTechnology,Xi’anUniversityofScienceandTechnology,Xi’anShaanxi710600,China)Abstract:Inthefieldoffine-grainedvisualrecognition,duetosubtledifferencesbetweenhighlysimilarcategories,preciseextractionofsubtleimagefeatureshasacrucialimpactonrecognitionaccuracy.Ithasbecomeatrendfortheexistingrelatedhotresearchalgorithmstouseattentionmechanismtoextractcategoricalfeatures,however,thesealgorithmsignorethesubtlebutdistinguishablefe...