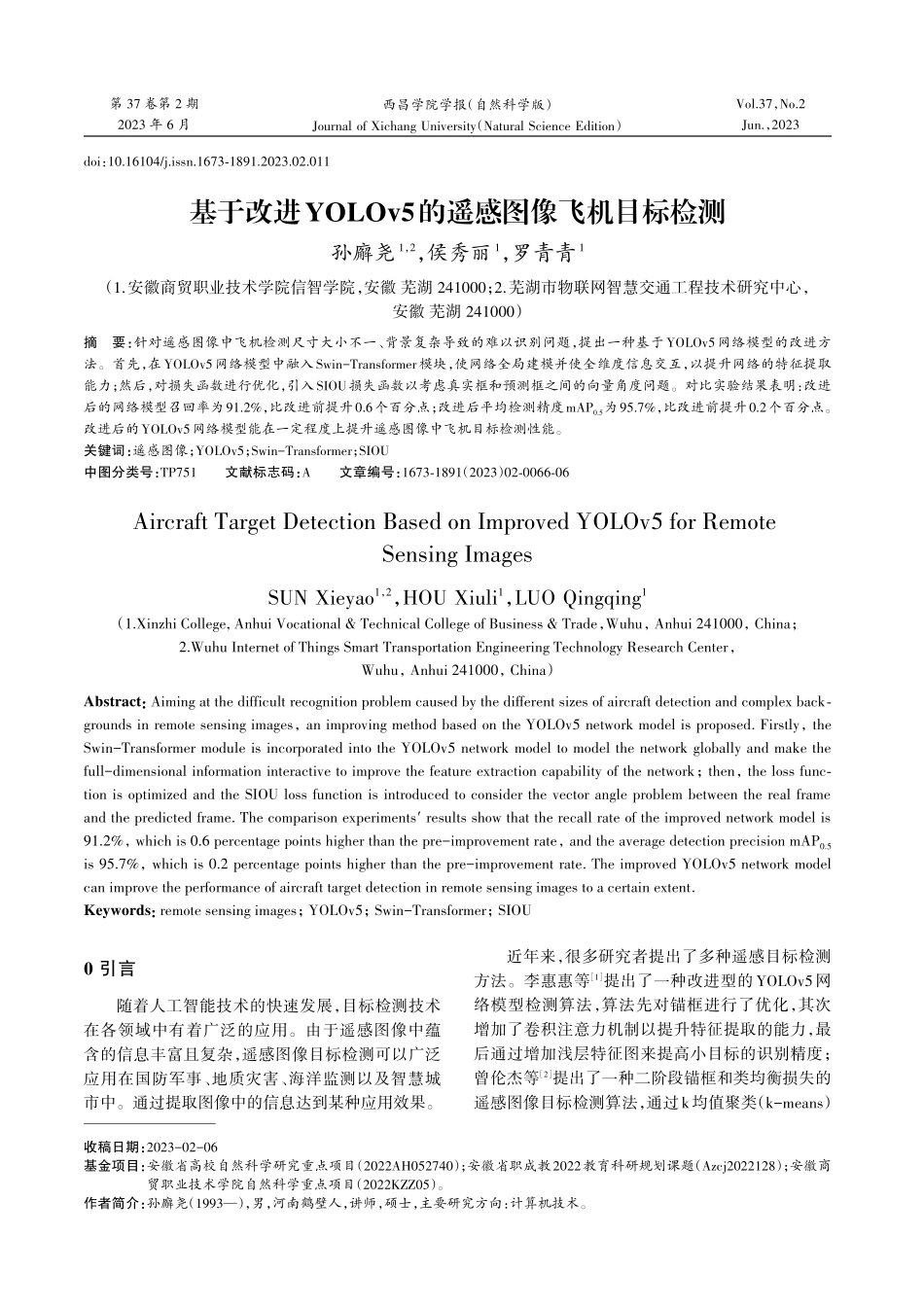

第37卷第2期2023年6月西昌学院学报(自然科学版)JournalofXichangUniversity(NaturalScienceEdition)Vol.37,No.2Jun.,2023基于改进YOLOv5的遥感图像飞机目标检测孙廨尧1,2,侯秀丽1,罗青青1(1.安徽商贸职业技术学院信智学院,安徽芜湖241000;2.芜湖市物联网智慧交通工程技术研究中心,安徽芜湖241000)摘要:针对遥感图像中飞机检测尺寸大小不一、背景复杂导致的难以识别问题,提出一种基于YOLOv5网络模型的改进方法。首先,在YOLOv5网络模型中融入Swin-Transformer模块,使网络全局建模并使全维度信息交互,以提升网络的特征提取能力;然后,对损失函数进行优化,引入SIOU损失函数以考虑真实框和预测框之间的向量角度问题。对比实验结果表明:改进后的网络模型召回率为91.2%,比改进前提升0.6个百分点;改进后平均检测精度mAP0.5为95.7%,比改进前提升0.2个百分点。改进后的YOLOv5网络模型能在一定程度上提升遥感图像中飞机目标检测性能。关键词:遥感图像;YOLOv5;Swin-Transformer;SIOU中图分类号:TP751文献标志码:A文章编号:1673⁃1891(2023)02⁃0066⁃06AircraftTargetDetectionBasedonImprovedYOLOv5forRemoteSensingImagesSUNXieyao1,2,HOUXiuli1,LUOQingqing1(1.XinzhiCollege,AnhuiVocational&TechnicalCollegeofBusiness&Trade,Wuhu,Anhui241000,China;2.WuhuInternetofThingsSmartTransportationEngineeringTechnologyResearchCenter,Wuhu,Anhui241000,China)Abstract:Aimingatthedifficultrecognitionproblemcausedbythedifferentsizesofaircraftdetectionandcomplexback⁃groundsinremotesensingimages,animprovingmethodbasedontheYOLOv5networkmodelisproposed.Firstly,theSwin-TransformermoduleisincorporatedintotheYOLOv5networkmodeltomodelthenetworkgloballyandmakethefull-dimensionalinformationinteractivetoimprovethefeatureextractioncapabilityofthenetwork;then,thelossfunc⁃tionisoptimizedandtheSIOUlossfunctionisintroducedtoconsiderthevectorangleproblembetweentherealframeandthepredictedframe.Thecomparisonexperiments'resultsshowthattherecallrateoftheimprovednetworkmodelis91.2%,whichis0.6percentagepointshigherthanthepre-improvementrate,andtheaveragedetectionprecisionmAP0.5is95.7%,whichis0.2percentagepointshigherthanthepre-improvementrate.Theim...