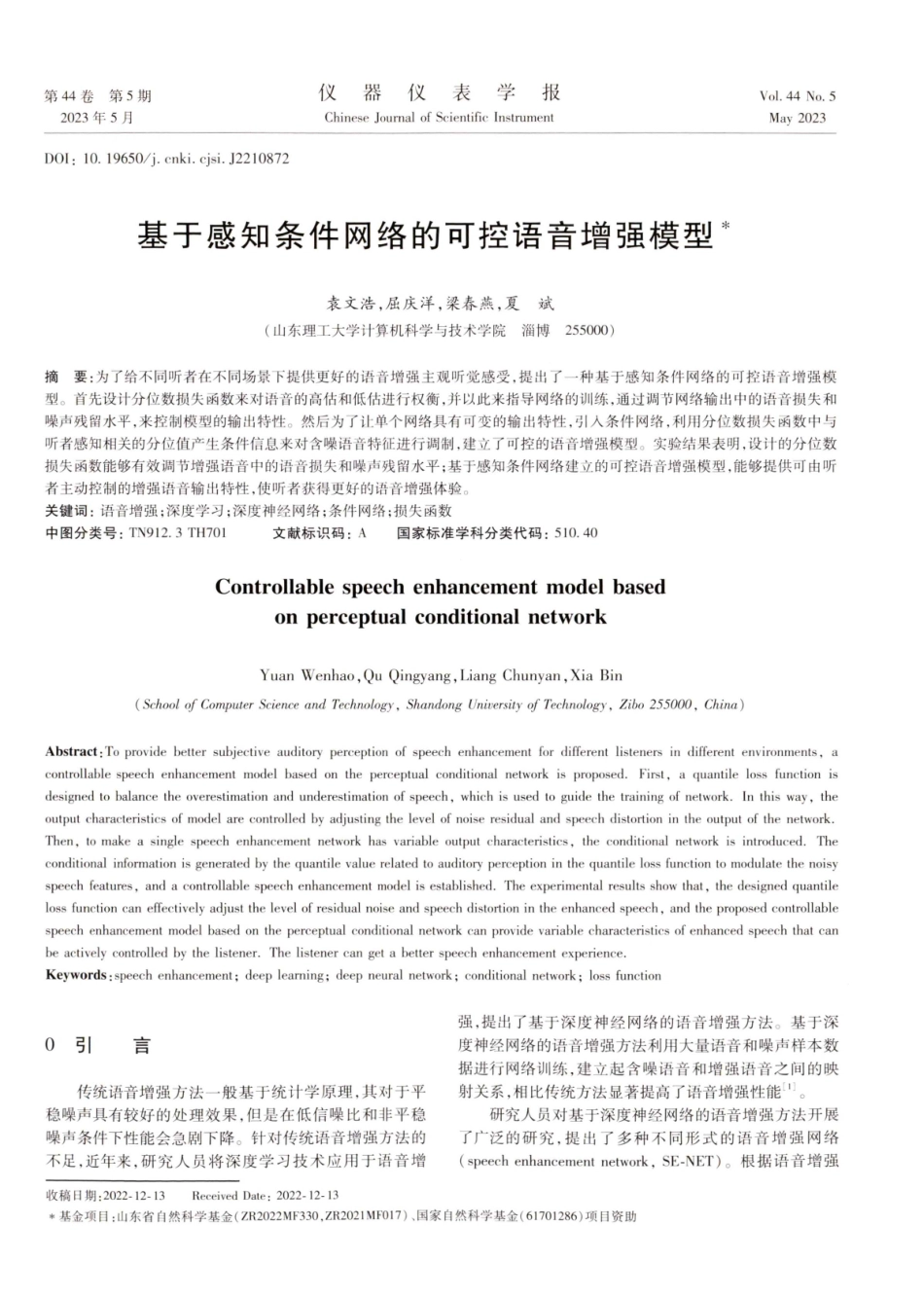

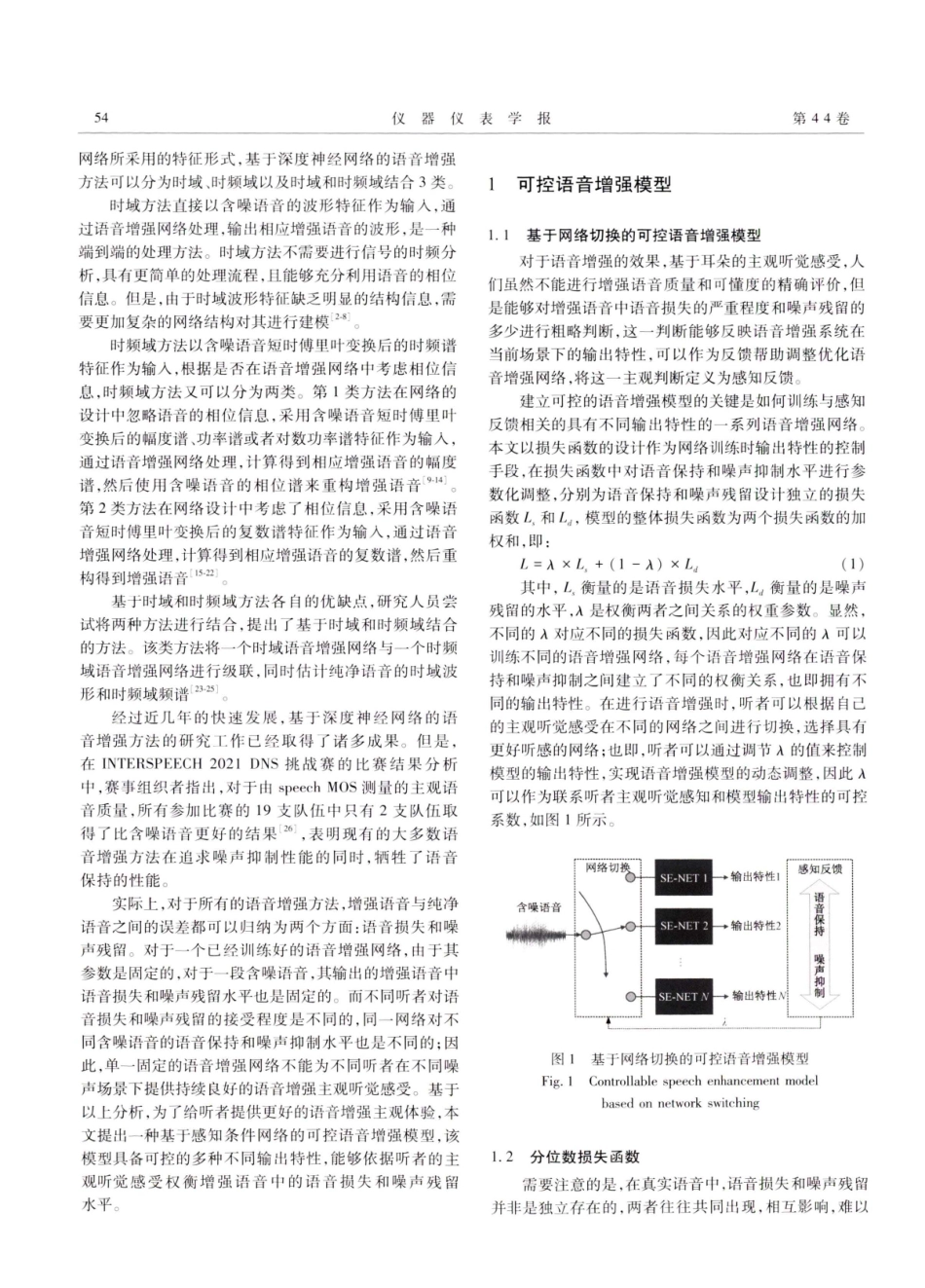

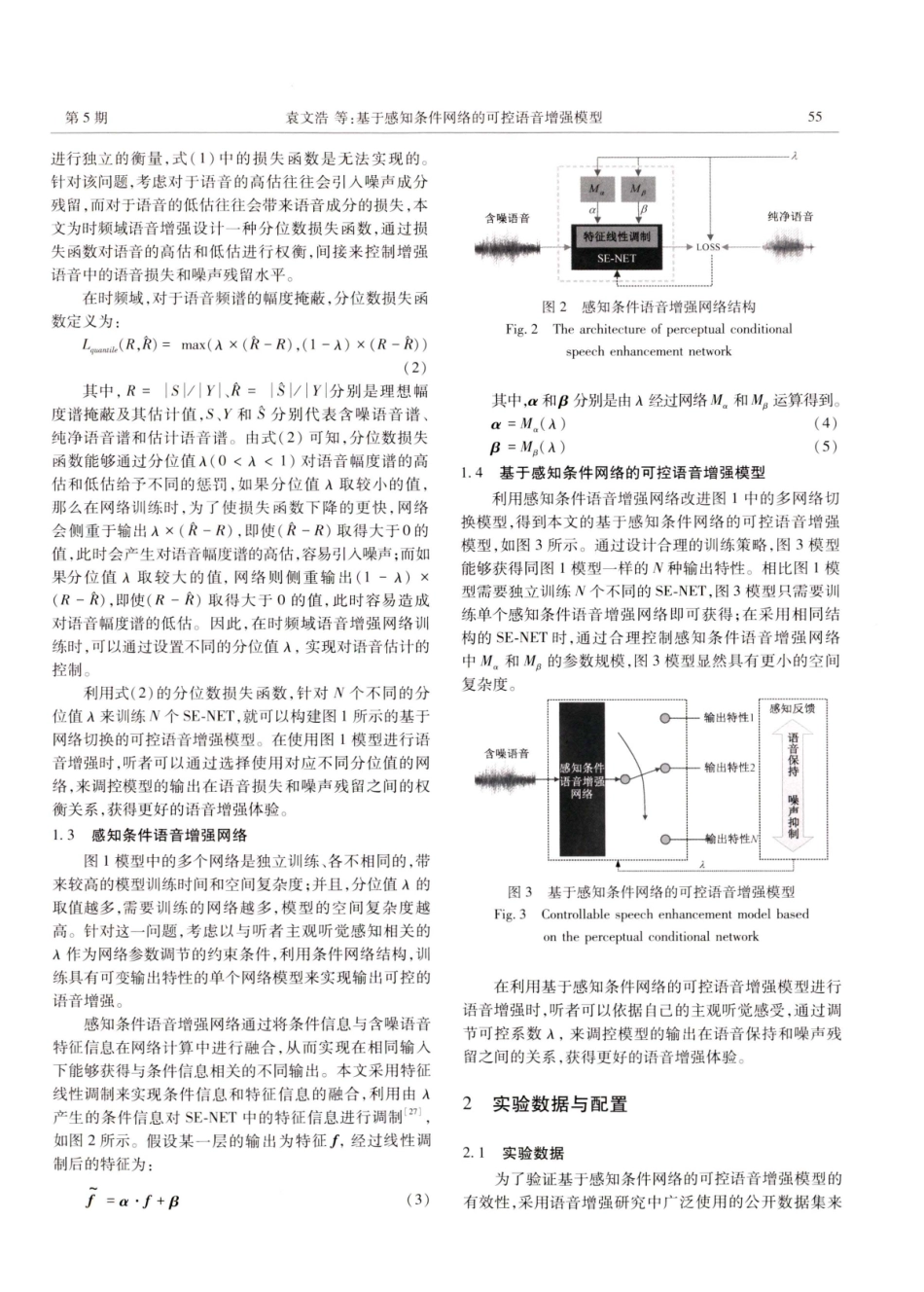

DOI:10.J2210872May2023ChineseJournalofScientificIInstrument2023年5月Vol.44No.5第44卷第5期表仪报器仪学基于感知条件网络的可控语音增强模型袁文浩,屈庆洋,梁春燕,夏斌(山东理工大学计算机科学与技术学院淄博255000)摘要:为了给不同听者在不同场景下提供更好的语音增强主观听觉感受,提出了一种基于感知条件网络的可控语音增强模型。首先设计分位数损失函数来对语音的高估和低估进行权衡,并以此来指导网络的训练,通过调节网络输出中的语音损失和噪声残留水平,来控制模型的输出特性。然后为了让单个网络具有可变的输出特性,引人条件网络,利用分位数损失函数中与听者感知相关的分位值产生条件信息来对含噪语音特征进行调制,建立了可控的语音增强模型。实验结果表明,设计的分位数损失函数能够有效调节增强语音中的语音损失和噪声残留水平;基于感知条件网络建立的可控语音增强模型,能够提供可由听者主动控制的增强语音输出特性,使听者获得更好的语音增强体验关键词:语音增强;深度学习;深度神经网络;条件网络;损失函数中图分类号:TN912.3TH701文献标识码:A国家标准学科分类代码:510.40ControllablespeechenhancementmodelbasedonperceptualconditionalnetworkYuanWenhao,QuQingyang,LiangChunyan,XiaBin(SchoolofComputerScienceandTechnology,ShandongUniversityofTechnology,Zibo255000,China)Abstract:Toprovidebettersubjectiveauditoryperceptionofspeechenhancementfordifferentlistenersindifferentenvironments,acontrollablespeechenhancementmodelbasedontheperceptualconditionalnetworkisproposed.First,aquantilelossfunctionisdesignedtobalancetheoverestimationandunderestimationofspeech,whichisusedtoguidethetrainingofnetwork.Inthisway,theoutputcharacteristicsofmodelarecontrolledbyadjustingthelevelofnoiseresidualandspeechdistortionintheoutputofthenetwork.Then,tomakeasinglespeechenhancementnetworkhasvariableoutputcharacteristics,theconditionalnetworkisintroduced.Theconditionalinformationisgeneratedbythequantilevaluerelatedtoauditoryperceptioninthequantilelossfunctiontomodulatethenoisyspeechfeatures,andacontrollablespeechenhancementmodelisestablished.Theexperimentalresultsshowthat,thedesignedquantilelossfunctioncaneffectivelyadjustthelevelofresidualnois...