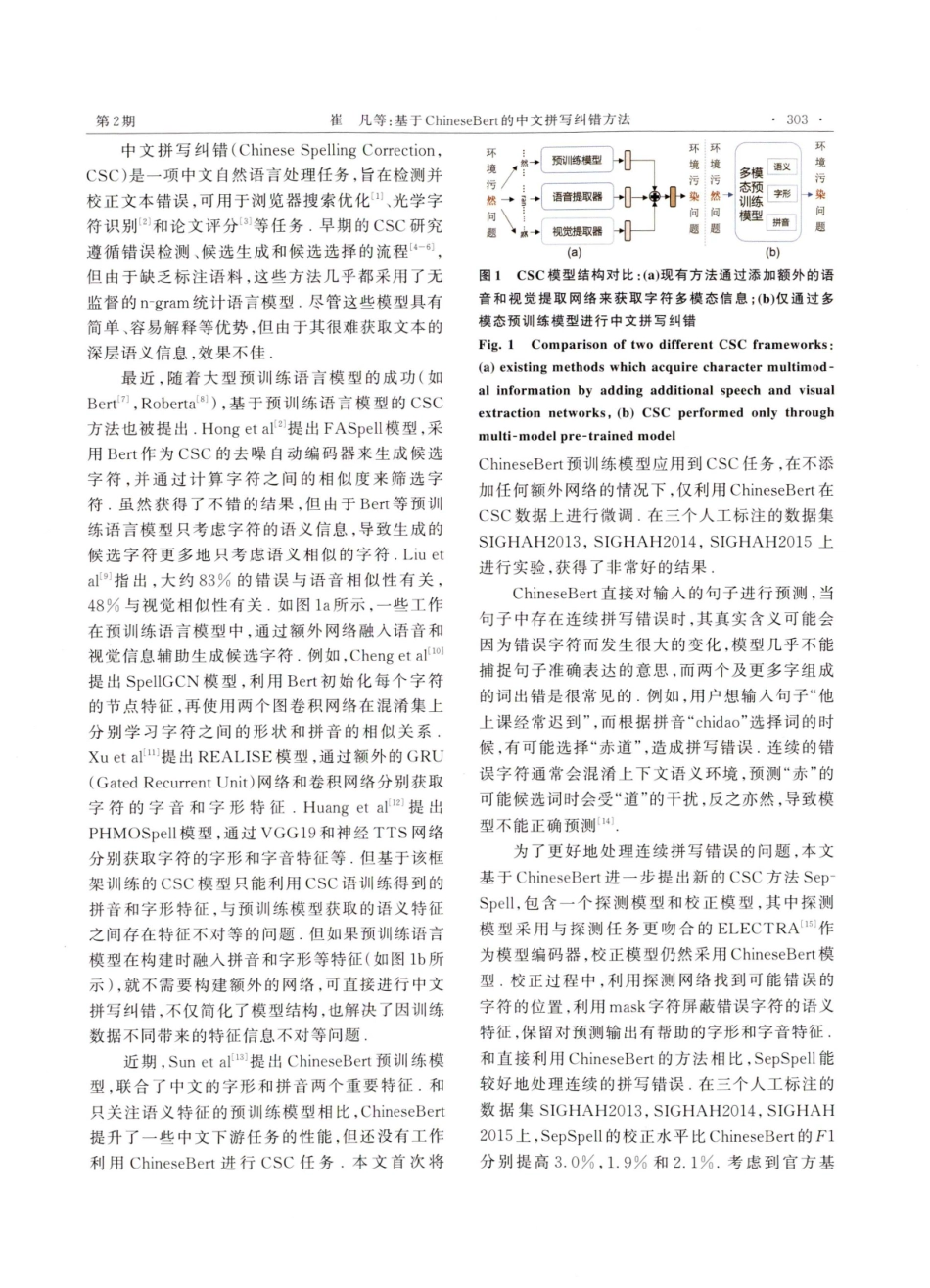

DOI:10.13232u.2023.02.013CNATURASCIENCEMar.,20232023年3月JOURNALUNIVERSITYVol.59,No.2第59卷第2期南京大学学报(自然科学)基于ChineseBert的中文拼写纠错方法崔凡,强继朋*,朱毅,李云(扬州大学信息工程学院,扬州,225127)摘要:中文拼写错误主要集中在拼音相似和字形相似两个方面,而通用的预训练语言模型只考虑文本的语义信息,忽略了中文的拼音和字形特征,最新的中文拼写纠错(ChineseSpellingCorrection,CSC)方法在预训练模型的基础上利用额外的网络来融人拼音和字形特征,但和直接微调预训练模型相比,改进的模型没有显著提高模型的性能,因为由小规模拼写任务语料训练的拼音和字形特征,和预训练模型获取的丰富语义特征相比,存在严重的信息不对等现象。将多模态预训练语言模型ChineseBert应用到CSC问题上,由于ChineseBert已将拼音和字形信息放到预训练模型构建阶段,基于ChineseBert的CSC方法不仅无须构建额外的网络,还解决了信息不对等的问题,由于基于预训练模型的CSC方法普遍不能很好地处理连续错误的问题,进一步提出SepSpell方法.首先利用探测网络检测可能错误的字符,再对可能错误的字符保留拼音特征和字形特征,掩码对应的语义信息进行预测,这样能降低预测过程中错误字符带来的干扰,更好地处理连续错误问题.在三个官方评测数据集上进行评估,提出的两个方法都取得了非常不错的结果关键词:中文拼写纠错,Bert,ChineseBert,多模态语言模型中图分类号:TP391.1文献标志码:AChinesespellingcorrectionmethodbasedonChineseBertCuiFan,QiangJipeng,ZhuYi,LiYun(SchoolofInformationEngineering,YangzhouUniversity,Yangzhou,225127,China)Abstract:Chinesespellingerrorsmainlyfocuseonbothphoneticandglyphsimilar.Generalpretrainedlanguagemodelsonlyconsiderthesemanticinformationofthetext,ignoringtheChinesephoneticandglyphfeatures.ThelatestChineseSpellingCorrection(CSC)methodsincorporatepinyinandglyphfeaturesviaadditionalnetworksonthebasisofthepretrainedlanguagemodels.Comparedwithfine-tuningpretrainedmodeldirectly,theimprovedmodeldoesnotsignificantlyimprovetheperformanceofCSCtask.Becauseofthephoneticandglyphicfeaturestrainedbythesmall-scalespellingtaskcorpus,thereisaseriousinformationasymmetrycomparedwiththerichsemanticfeaturesobtainedbythepre-trainingmodel.Tobett...