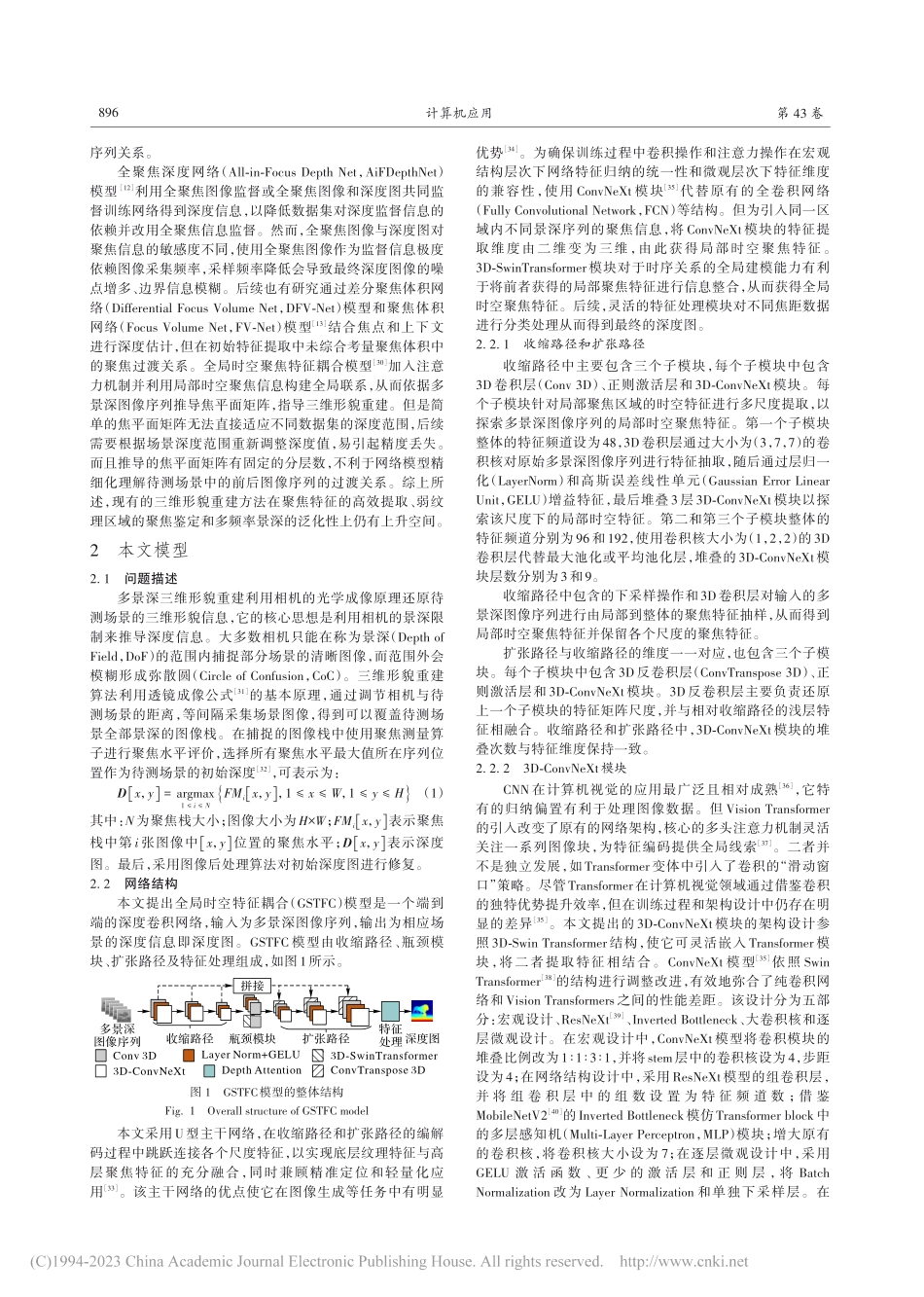

2023⁃03⁃10计算机应用,JournalofComputerApplications2023,43(3):894-902ISSN1001⁃9081CODENJYIIDUhttp://www.joca.cn全局时空特征耦合的多景深三维形貌重建张江峰1,2,闫涛1,2,3,4*,陈斌4,5,钱宇华2,3,宋艳涛1,2,3(1.山西大学计算机与信息技术学院,太原030006;2.山西大学大数据科学与产业研究院,太原030006;3.山西省机器视觉与数据挖掘工程研究中心(山西大学),太原030006;4.哈尔滨工业大学重庆研究院,重庆401151;5.哈尔滨工业大学(深圳)国际人工智能研究院,广东深圳518055)(∗通信作者电子邮箱hongyanyutian@sxu.edu.cn)摘要:针对现有三维形貌重建模型无法有效融合全局时空信息的问题,设计深度聚焦体积(DFV)模块保留聚焦和离焦的过渡信息,并在此基础上提出全局时空特征耦合(GSTFC)模型提取多景深图像序列的局部与全局的时空特征信息。首先,在收缩路径中穿插3D-ConvNeXt模块和3D卷积层,捕捉多尺度局部时空特征,同时,在瓶颈模块中添加3D-SwinTransformer模块捕捉多景深图像序列局部时序特征的全局关联关系;然后,通过自适应参数层将局部时空特征和全局关联关系融合为全局时空特征,并输入扩张路径引导生成聚焦体积;最后,聚焦体积通过DFV提取序列权重信息,并保留聚焦与离焦的过渡信息,得到最终深度图。实验结果表明,GSTFC在FoD500数据集上的均方根误差(RMSE)相较于最先进的全聚焦深度网络(AiFDepthNet)下降了12.5%,并且比传统的鲁棒聚焦体积正则化的聚焦形貌恢复(RFVR-SFF)模型保留了更多的景深过渡关系。关键词:三维形貌重建;深度学习;有监督学习;时空特征耦合;深度图中图分类号:TP391.41文献标志码:AMulti-depth-of-field3Dshapereconstructionwithglobalspatio-temporalfeaturecouplingZHANGJiangfeng1,2,YANTao1,2,3,4*,CHENBin4,5,QIANYuhua2,3,SONGYantao1,2,3(1.SchoolofComputerandInformationTechnology,ShanxiUniversity,TaiyuanShanxi030006,China;2.InstituteofBigDataScienceandIndustry,ShanxiUniversity,TaiyuanShanxi030006,China;3.EngineeringResearchCenterforMachineVisionandDataMiningofShanxiProvince(ShanxiUniversity),TaiyuanShanxi030006,China;4.ChongqingResearchInstituteofHarbinInstituteofTechnology,Chongqing401151,China;5.InternationalResearchInstituteforArtificialIntelligence,HarbinInstituteofTechnolog...