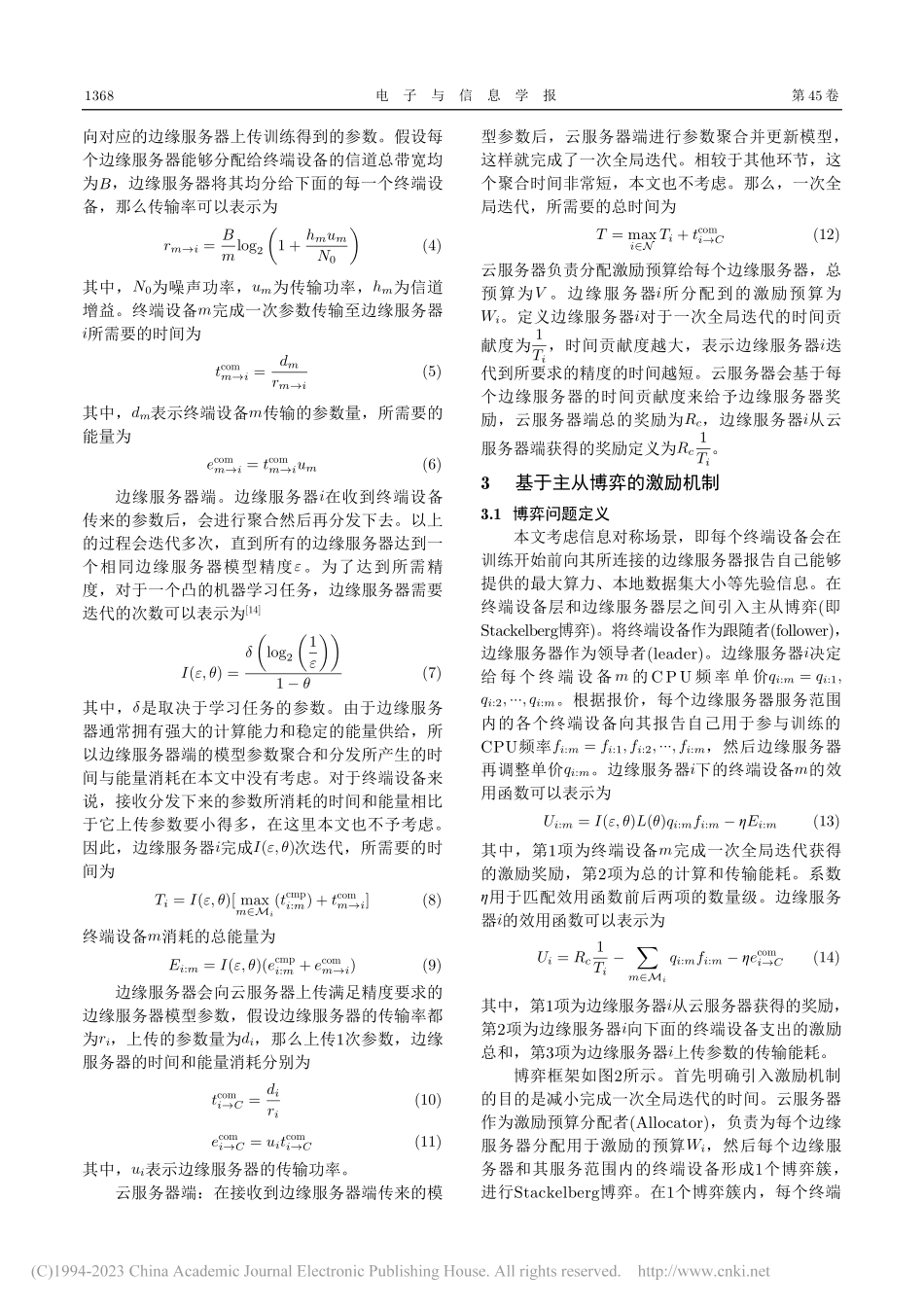

基于主从博弈的分层联邦学习激励机制研究贾云健①黄宇①梁靓*①万杨亮②周继华③①(重庆大学微电子与通信工程学院重庆400044)②(95696部队重庆400030)③(重庆金美通信有限责任公司复杂环境通信重庆市重点实验室重庆400030)摘要:为了优化分层联邦学习(FL)全局模型的训练时延,针对实际场景中终端设备存在自私性的问题,该文提出一种基于博弈论的激励机制。在激励预算有限的条件下,得到了终端设备和边缘服务器之间的均衡解和最小的边缘模型训练时延。考虑终端设备数量不同,设计了基于主从博弈的可变激励训练加速算法,使得一次全局模型训练时延达到最小。仿真结果显示,所提出的算法能够有效降低终端设备自私性带来的影响,提高分层联邦学习全局模型的训练速度。关键词:分层联邦学习;博弈论;激励机制中图分类号:TN92文献标识码:A文章编号:1009-5896(2023)04-1366-08DOI:10.11999/JEIT220175ResearchonHierarchicalFederatedLearningIncentiveMechanismBasedonMaster-SlaveGameJIAYunjian①HUANGYu①LIANGLiang①WANYangliang②ZHOUJihua③①(SchoolofMicroelectronicsandCommunicationEngineering,ChongqingUniversity,Chongqing400044,China)②(95696Troops,Chongqing400030,China)③(ChongqingKeyLaboratoryofComplexEnvironmentCommunication,ChongqingJinmeiCommunicationCo.Ltd.Chongqing400030,China)Abstract:InordertooptimizethetrainingdelayofthehierarchicalFederatedLearning(FL)globalmodel,focusingontheselfishnessoftheterminaldevicesintheactualscene,anincentivemechanismbasedongametheoryisproposed.Undertheconditionoflimitedincentivebudget,theequilibriumsolutionbetweenterminaldevicesandedgeserversandtheminimumedgemodeltrainingdelayareobtained.Consideringthedifferentnumberofterminaldevices,avariableincentivetrainingaccelerationalgorithmbasedonStackelberggameisdesignedtominimizethetrainingdelayofaglobalmodel.Simulationresultsdemonstratethattheproposedalgorithmcaneffectivelyreducetheimpactofterminaldevicesselfishnessandimprovethetrainingspeedofhierarchicalfederatedlearningglobalmodel.Keywords:HierarchicalFederatedLearning(FL);Gametheory;Incentivemechanism1引言随着各种智能设备的不断普及,依赖数据和计算能力的机器学习技术得到了迅速发展。为了解决机器学习模型训...