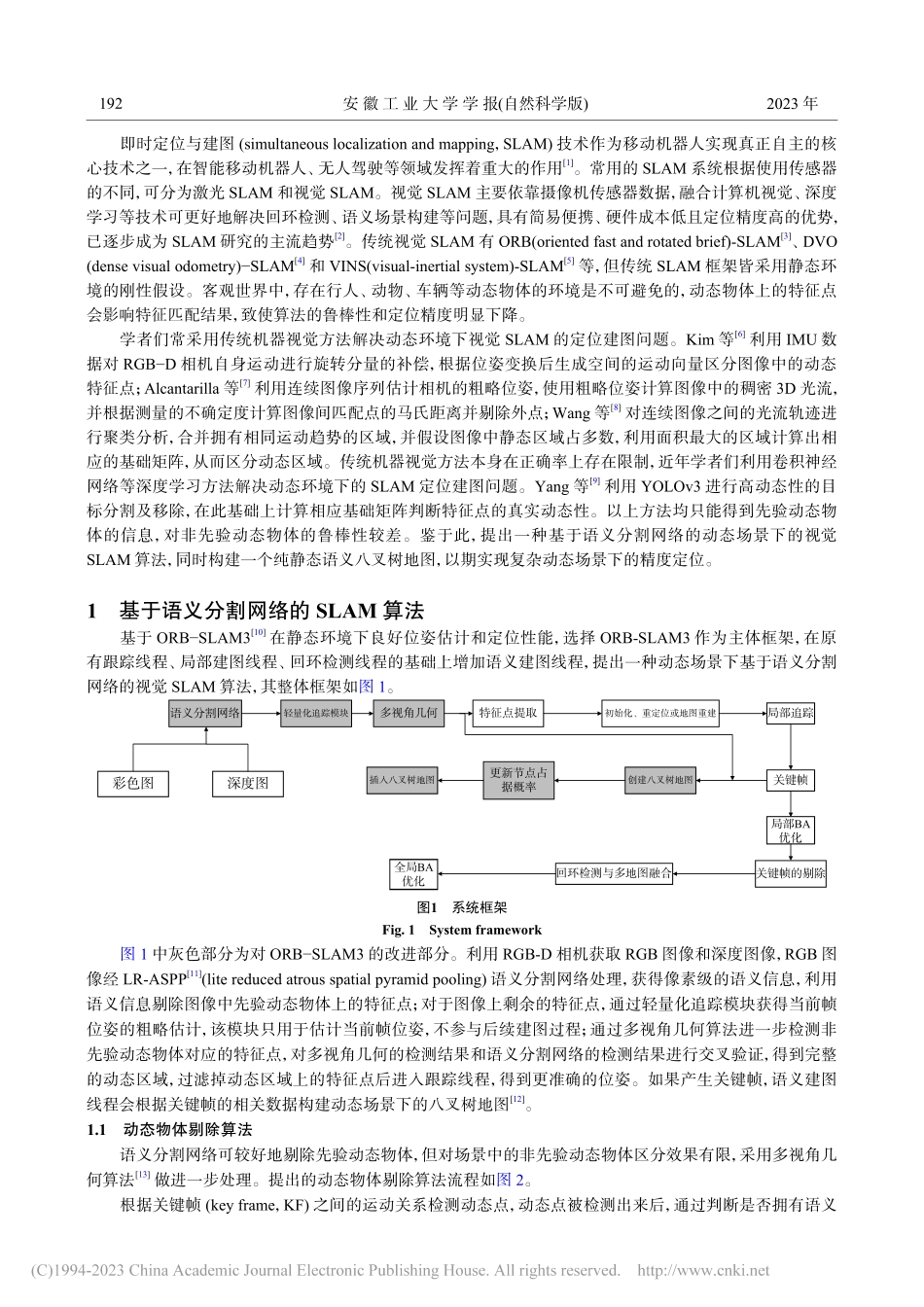

文章编号:1671-7872(2023)02-0191-07基于语义分割网络的动态场景视觉SLAM算法赵凯,李丹,程星,管玲,葛仕全(安徽工业大学电气与信息工程学院,安徽马鞍山243032)摘要:针对传统即时定位与建图(SLAM)算法在动态场景中位姿估计精度不高的问题,提出一种动态场景下基于语义分割网络的视觉SLAM算法。通过RGB-D相机采集彩色图与深度图,将彩色图输入轻量级语义分割网络LR−ASPP,剔除先验动态物体,同时获得语义图;采用多视角几何算法剔除非先验动态物体,分离动静态特征点后得到优化后的位姿,并结合语义图和深度图构建纯静态语义八叉树地图,提高对动态场景的适应能力并直接用于导航系统。公开数据集TUM的实验测试结果表明:本文算法的最小绝对定位误差仅0.0076m,相比于ORB−SLAM3算法,在高动态场景中定位精度提升了80%以上,并能获取精确的动态区域及准确的语义地图,本文算法在复杂动态场景中具有良好的定位精度和鲁棒性。关键词:即时定位与建图;语义分割;多视角几何中图分类号:TP242.6文献标志码:Adoi:10.12415/j.issn.1671−7872.22273DynamicSceneVisionSLAMOptimizationBasedonSemanticSegmentationNetworkZHAOKai,LIDan,CHENGXing,GUANLing,GEShiquan(SchoolofElectrical&InformationEngineering,AnhuiUniversityofTechnology,Maanshan243032,China)Abstract:Aimingattheproblemthatthetraditionalreal-timelocationandmapping(SLAM)algorithmdoesnothavehighaccuracyinposeestimationindynamicscenes,avisualSLAMalgorithmbasedonsemanticsegmentationnetworkindynamicsceneswasproposed.Firstly,thecolormapanddepthmapwerecollectedbyRGB-Dcamera,andthecolormapwasinputtothelightweightsemanticsegmentationnetworkLR-ASPPtoeliminatetheaprioridynamicobjectsandobtainthesemanticmapatthesametime.Then,themulti-viewgeometryalgorithmwasusedtorejectthenon-priordynamicobjects,afterseparatingthedynamicandstaticfeaturepoints,theoptimizedpositionandposewasobtained,andthepurestaticsemanticoctreemapwasconstructedbycombiningthesemanticmapanddepthmaptoimprovetheadaptabilitytodynamicscenesanddirectlyusedinthenavigationsystem.ThetestresultsofthepublicdatasetTUMshowthattheminimumabsolutelocalizationerrorofthealgorithminthispaperisonly0.0076m.ComparedwithORB-SLAM3,thelocalizationaccuracyinhi...