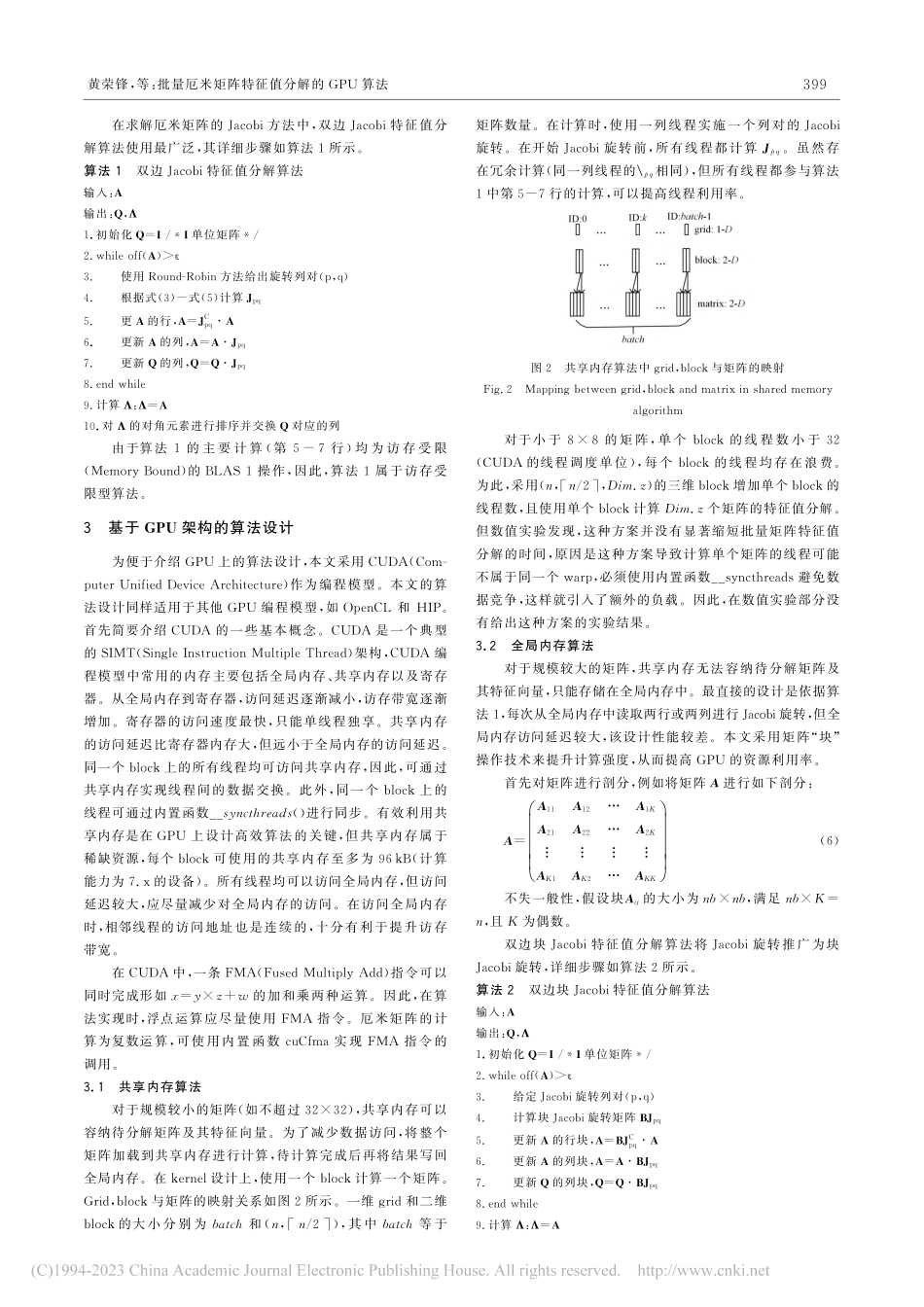

http://www.jsjkx.comDOI:10.11896/jsjkx.2201002321)https://docs.nvidia.com/cuda/pdf/cublas\_Library.pdf2)https://github.com/ROCmSoftwarePlatform/rocBLAS3)http://icl.cs.utk.edu/magma/4)https://github.com/ecrc/kblas-gpu到稿日期:2022-01-25返修日期:2022-08-24基金项目:国家重点研发计划(2017YFB0202202);中国科学院战略性先导科技专项(XDC05000000)ThisworkwassupportedbytheNationalKeyResearchandDevelopmentProgramofChina(2017YFB0202202)andStrategicPriorityResearchProgramofChineseAcademyofSciences(XDC05000000).通信作者:赵永华(yhzhao@sccas.cn)批量厄米矩阵特征值分解的GPU算法黄荣锋1,2刘世芳1,2赵永华11中国科学院计算机网络信息中心北京1000802中国科学院大学北京100080(hrf@sccas.cn)摘要批量矩阵计算问题广泛存在于科学计算与工程应用领域。随着性能的快速提升,GPU已成为解决这类问题的重要工具之一。矩阵特征值分解属于双边分解,需要使用迭代算法进行求解,不同矩阵的迭代次数可能不同,因此,在GPU上设计批量矩阵的特征值分解算法比设计LU分解等单边分解算法更具挑战性。文中针对不同规模的矩阵,基于Jacobi算法设计了相应的批量厄米矩阵特征值分解GPU算法。对于共享内存无法存储的矩阵,采用矩阵“块”操作技术提升计算强度,从而提高GPU的资源利用率。所提算法完全在GPU上运行,避免了CPU与GPU之间的通信。在算法实现上,通过kernel融合减少了kernel启动负载和全局内存访问。在V100GPU上的实验结果表明,所提算法优于已有工作。Roofline性能分析模型表明,文中给出的实现已接近理论上限,达到了4.11TFLOPS。关键词:厄米矩阵;特征值分解;批量计算;Roofline模型;性能分析中图法分类号TP301BatchedEigenvalueDecompositionAlgorithmsforHermitianMatricesonGPUHUANGRongfeng1,2,LIUShifang1,2andZHAOYonghua11ComputerNetworkInformationCenter,ChineseAcademyofSciences,Beijing100080,China2UniversityofChineseAcademyofSciences,Beijing100080,ChinaAbstractBatchedmatrixcomputingproblemsarewidelyexistedinscientificcomputingandengineeringapplications.Withrapidperformanceimprovements,GPUhasbecomeanimportanttooltosolvesuchproblems.Theeigenvaluedecompositionbelongstothetwo-sideddecompositionandmustbesolvedbytheiterativealgorithm.Iterativenumbersfordifferentmatricescanbevaried.Therefore,design...