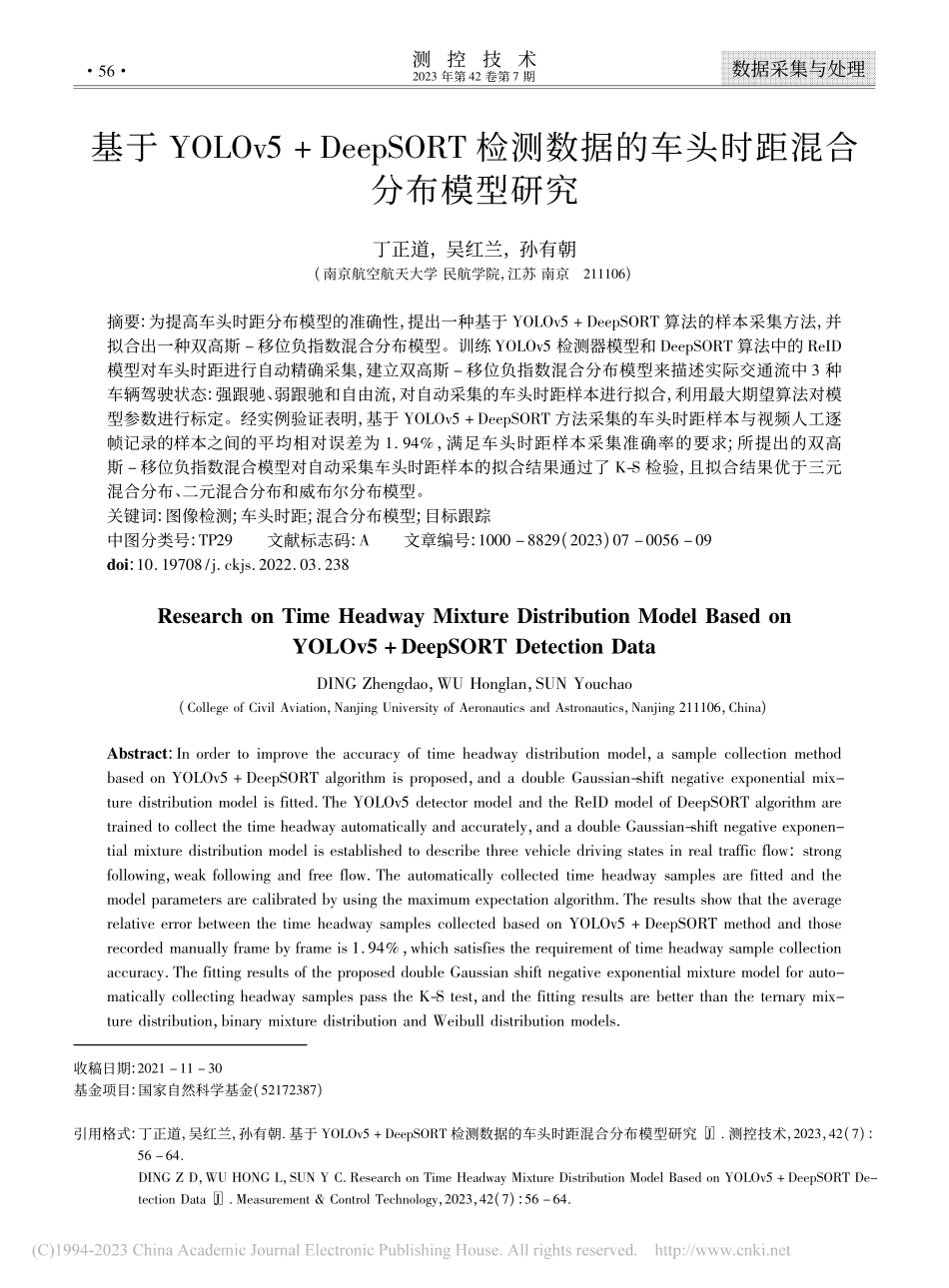

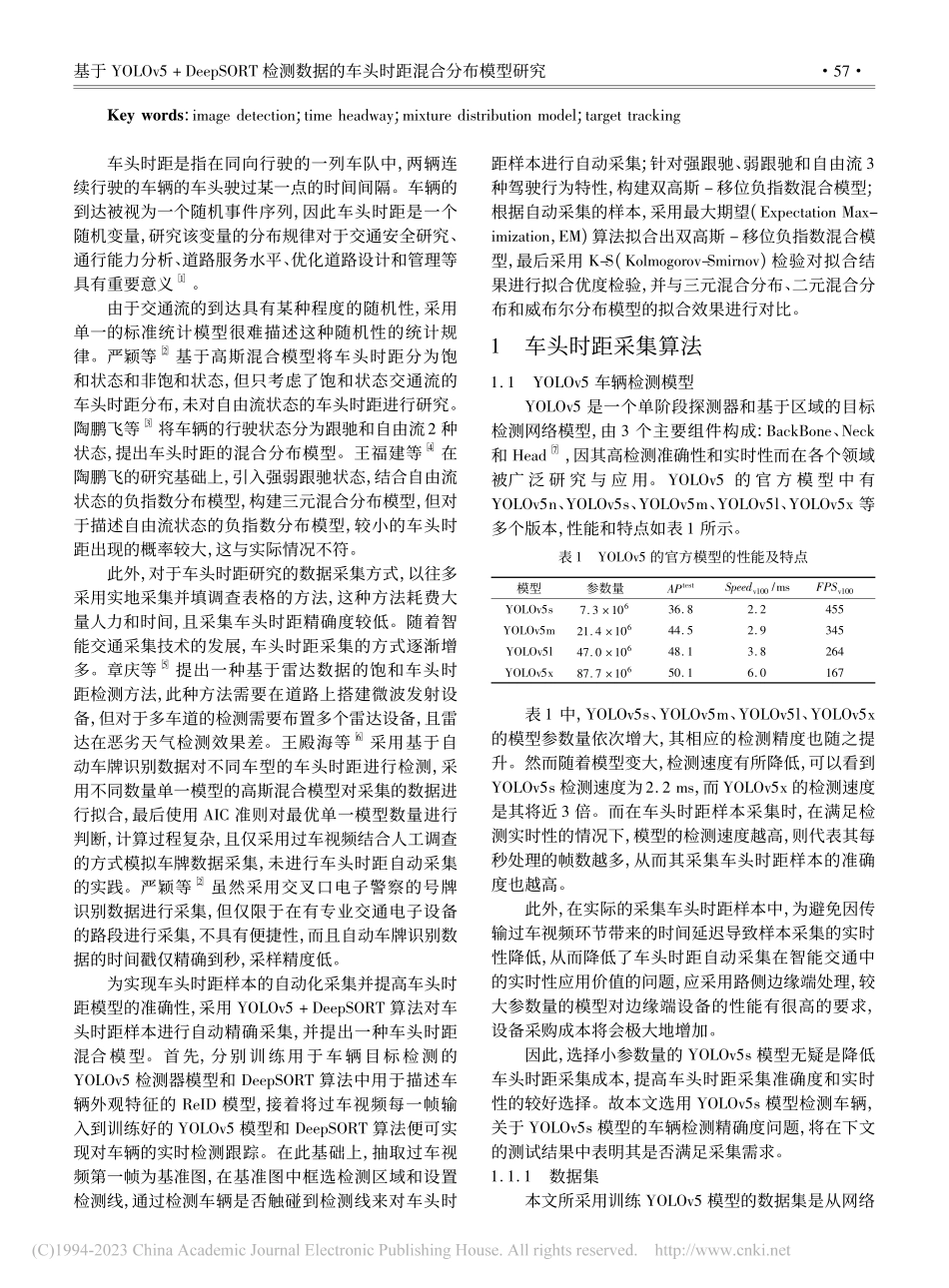

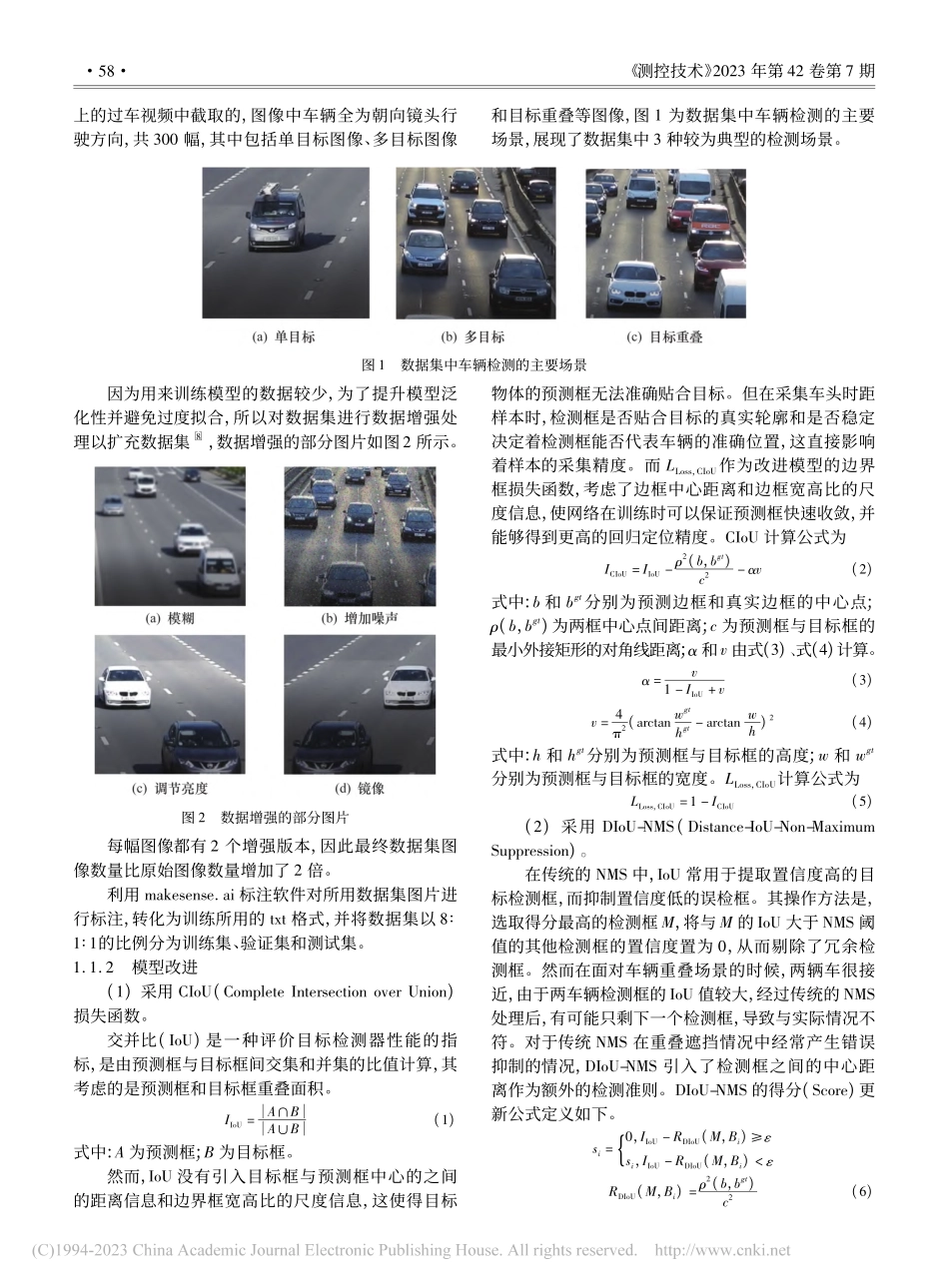

测控技术2023年第42卷第7期数据采集与处理收稿日期:2021-11-30基金项目:国家自然科学基金(52172387)引用格式:丁正道,吴红兰,孙有朝.基于YOLOv5+DeepSORT检测数据的车头时距混合分布模型研究[J].测控技术,2023,42(7):56-64.DINGZD,WUHONGL,SUNYC.ResearchonTimeHeadwayMixtureDistributionModelBasedonYOLOv5+DeepSORTDe-tectionData[J].Measurement&ControlTechnology,2023,42(7):56-64.基于YOLOv5+DeepSORT检测数据的车头时距混合分布模型研究丁正道,吴红兰,孙有朝(南京航空航天大学民航学院,江苏南京211106)摘要:为提高车头时距分布模型的准确性,提出一种基于YOLOv5+DeepSORT算法的样本采集方法,并拟合出一种双高斯-移位负指数混合分布模型。训练YOLOv5检测器模型和DeepSORT算法中的ReID模型对车头时距进行自动精确采集,建立双高斯-移位负指数混合分布模型来描述实际交通流中3种车辆驾驶状态:强跟驰、弱跟驰和自由流,对自动采集的车头时距样本进行拟合,利用最大期望算法对模型参数进行标定。经实例验证表明,基于YOLOv5+DeepSORT方法采集的车头时距样本与视频人工逐帧记录的样本之间的平均相对误差为1.94%,满足车头时距样本采集准确率的要求;所提出的双高斯-移位负指数混合模型对自动采集车头时距样本的拟合结果通过了K-S检验,且拟合结果优于三元混合分布、二元混合分布和威布尔分布模型。关键词:图像检测;车头时距;混合分布模型;目标跟踪中图分类号:TP29文献标志码:A文章编号:1000-8829(2023)07-0056-09doi:10.19708/j.ckjs.2022.03.238ResearchonTimeHeadwayMixtureDistributionModelBasedonYOLOv5+DeepSORTDetectionDataDINGZhengdao,WUHonglan,SUNYouchao(CollegeofCivilAviation,NanjingUniversityofAeronauticsandAstronautics,Nanjing211106,China)Abstract:Inordertoimprovetheaccuracyoftimeheadwaydistributionmodel,asamplecollectionmethodbasedonYOLOv5+DeepSORTalgorithmisproposed,andadoubleGaussian-shiftnegativeexponentialmix-turedistributionmodelisfitted.TheYOLOv5detectormodelandtheReIDmodelofDeepSORTalgorithmaretrainedtocollectthetimeheadwayautomaticallyandaccurately,andadoubleGaussian-shiftnegativeexponen-tialmixturedistributionmodelisestablishedtodescribethreevehicledrivingstatesinrealtrafficflow:strongfollowing,weakfo...