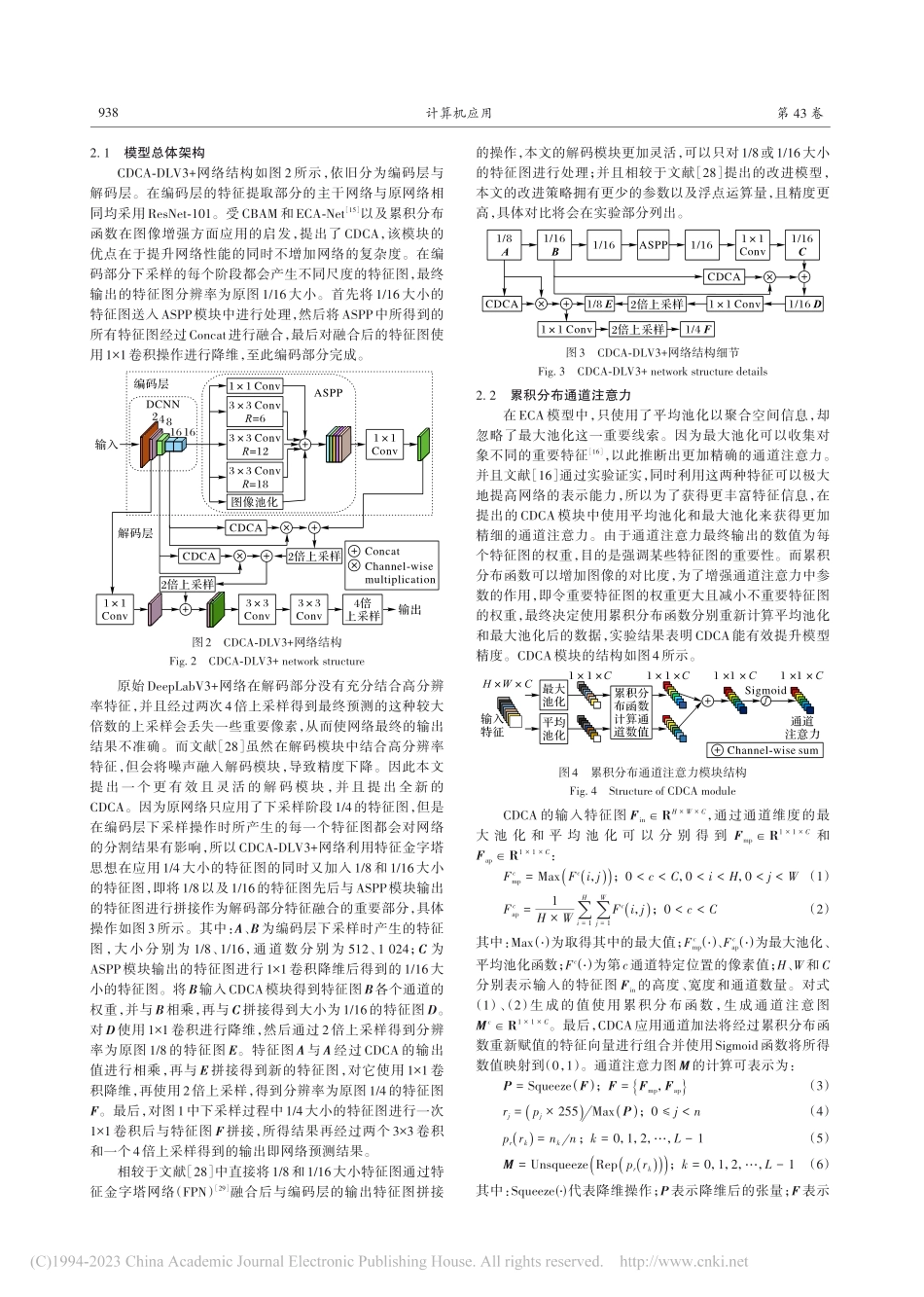

2023⁃03⁃10计算机应用,JournalofComputerApplications2023,43(3):936-942ISSN1001⁃9081CODENJYIIDUhttp://www.joca.cn融合累积分布函数和通道注意力机制的DeepLabV3+图像分割算法何雪东1,宣士斌1,2*,王款1,陈梦楠1(1.广西民族大学人工智能学院,南宁530006;2.广西混杂计算与集成电路设计分析重点实验室(广西民族大学),南宁530006)(∗通信作者电子邮箱xuanshibin@gxmzu.edu.cn)摘要:为了解决DeepLabV3+在语义分割时未充分利用主干的低级特征,以及大倍数上采样造成有效特征缺失的问题,提出一种累积分布通道注意力DeepLabV3+(CDCA-DLV3+)模型。首先,基于累积分布函数和通道注意力提出了累积分布通道注意力(CDCA);然后,利用CDCA获取主干部分有效的低级特征;最后,采用特征金字塔网络(FPN)进行特征融合和逐步上采样,从而避免大倍数上采样所造成的特征损失。CDCA-DLV3+模型在PascalVOC2012验证集与Cityscapes数据集上的平均交并比(mIoU)分别为80.09%和80.11%,相较于DeepLabV3+模型分别提升1.24和1.02个百分点。实验结果表明,所提模型分割结果更加精确。关键词:深度学习;图像语义分割;通道注意力机制;DeepLabV3+;累积分布函数中图分类号:TP183文献标志码:ADeepLabV3+imagesegmentationalgorithmfusingcumulativedistributionfunctionandchannelattentionmechanismHEXuedong1,XUANShibin1,2*,WANGKuan1,CHENMengnan1(1.SchoolofArtificialIntelligence,GuangxiMinzuUniversity,NanningGuangxi530006,China;2.GuangxiKeyLaboratoryofHybridComputationandICDesignandAnalysis(GuangxiMinzuUniversity),NanningGuangxi530006,China)Abstract:Inordertosolvetheproblemsthatthelow-levelfeaturesofthebackbonearenotfullyutilized,andtheeffectivefeaturesarelostduetolarge-timesupsamplinginDeepLabV3+semanticsegmentation,aCumulativeDistributionChannelAttentionDeepLabV3+(CDCA-DLV3+)modelwasproposed.Firstly,aCumulativeDistributionChannelAttention(CDCA)wasproposedbasedonthecumulativedistributionfunctionandchannelattention.Then,thecumulativedistributionchannelattentionwasusedtoobtaintheeffectivelow-levelfeaturesofthebackbonepart.Finally,theFeaturePyramidNetwork(FPN)wasadoptedforfeaturefusionandgradualupsamplingtoavoidthefeaturelosscausedbylarge-ti...