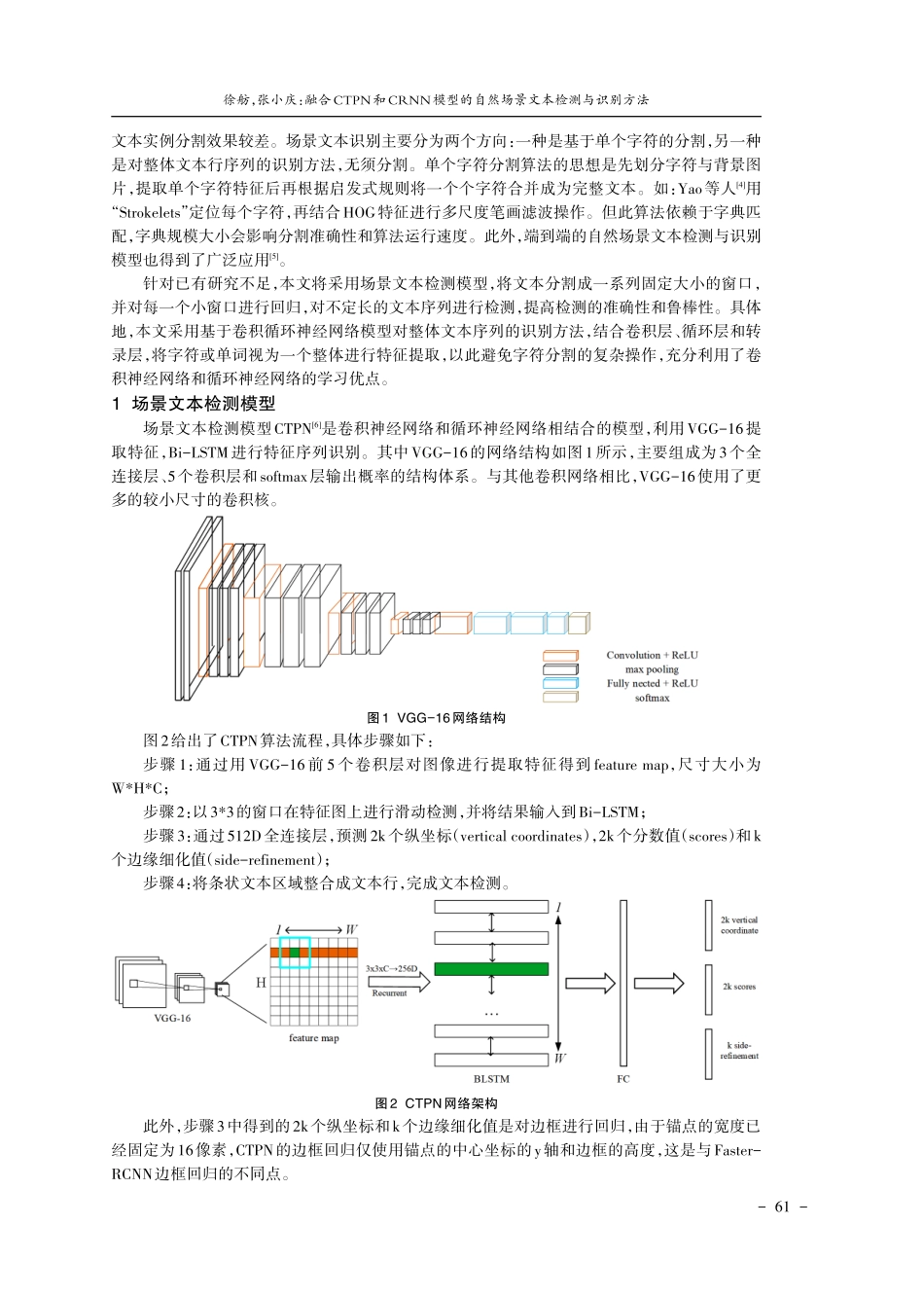

丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌丌保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报保山学院学报融合CTPN和CRNN模型的自然场景文本检测与识别方法徐舫张小庆(武汉轻工大学数学与计算机学院,湖北武汉430023)[摘要]针对自然场景中文本检测与识别存在准确率不高和效率不佳的问题,提出了一种融合场景文本检测CTPN和卷积循环神经网络CRNN模型的自然场景文字检测与识别方法。首先利用CTPN模型对文本行进行预测,再利用卷积神经网络进行特征序列提取和识别并基于Bi-LSTM学习序列特征,最后将文本分数高的窗口连接作为文本区域,从而实现文本检测。实验结果表明,在ICADR-2013数据集中改进模型的准确率可达78%;基于CRNN的文本识别模型在提取特征序列后,经过转录层预测的文本序列结果,在测试集上的准确率可达到86.7%;以上结果表明融合CTPN和CRNN模型的自然场景文字检测与识别方法能够获得更好的检测与识别效果。[关键词]文本检测;文本识别;卷积循环神经网络;场景文本检测算法[中图分类号]TP3[文献标识码]Adoi:10.3969/j.issn.1674-9340.2023.02.010[文章编号]1674-9340(2023)0...