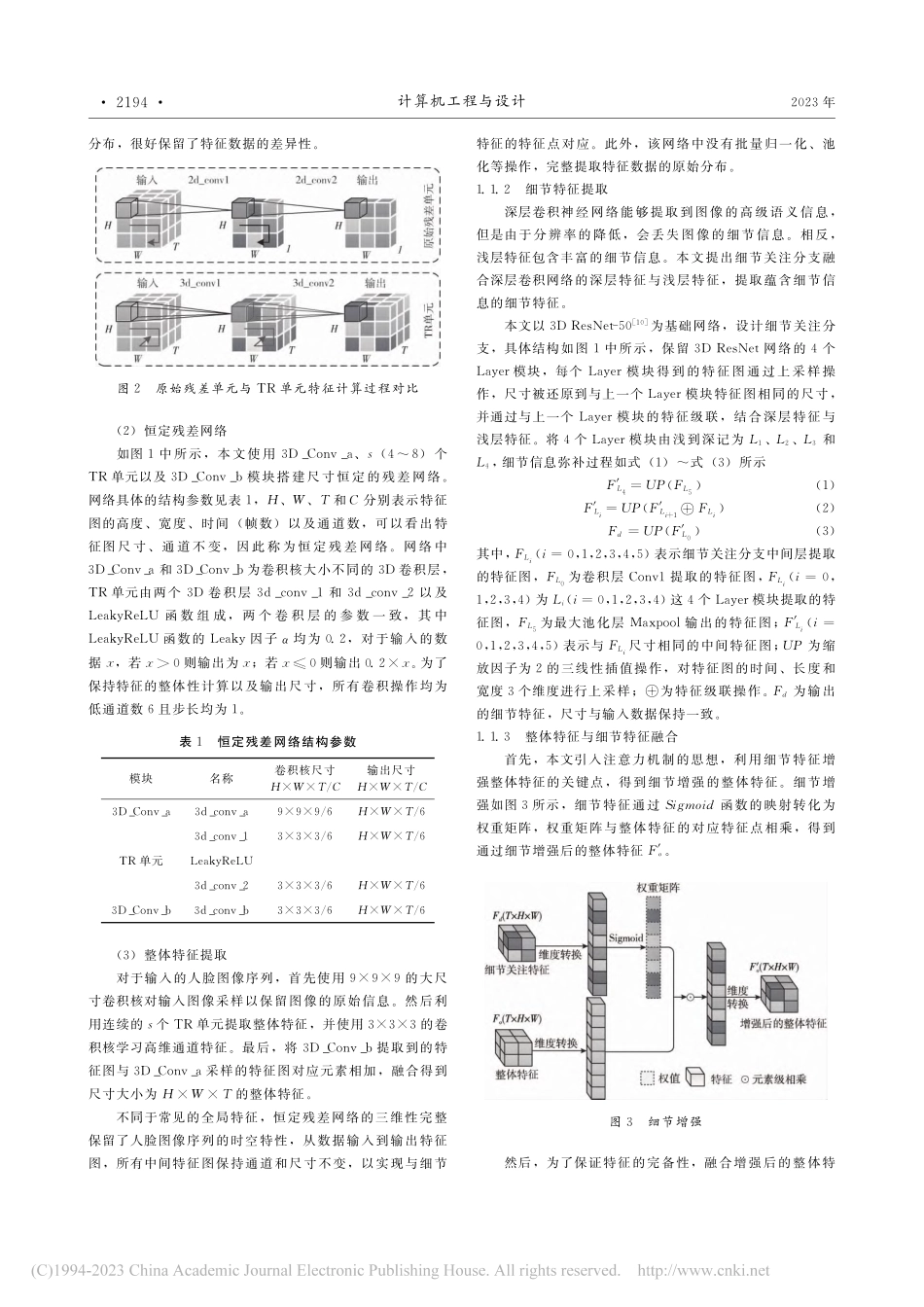

2023年7月第44卷第7期计算机工程与设计COMPUTERENGINEERINGANDDESIGNJuly2023Vol.44■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■No.7基于残差网络和粗细粒度的音视频情感识别于明,刘子微,师硕+,吕华(河北工业大学人工智能与数据科学学院,天津300401)摘要:针对情感特征表征性不足以及离散型和连续型情感描述间关联缺失的问题,提出一种基于残差网络和粗细粒度的音视频情感识别方法。基于残差网络构建双子网络提取特征,视频子网设计恒定残差网络和细节关注分支,弥补深层特征的细节信息;音频子网利用分段注意力机制提升特征判别力。使用比例决策融合策略得到最终情感分类结果。设计粗细粒度损失函数,优化整个网络的性能。实验结果表明,所提方法有效提升了识别精度,验证了不同情感描述间的关联对情感识别的辅助作用。关键词:音视频模态;情感识别;残差网络;比例决策融合;细节信息;分段注意力机制;粗细粒度损失中图法分类号:TP183;TN912.34文献标识号:A文章编号:1000-7024(2023)07-2192-08doi:10.16208/j.issn1000-7024.2023.07.036收稿日期:2022-01-19;修订日期:2023-07-05基金项目:国家自然科学青年基金项目(61806071);河北省自然科学基金面上基金项目(F2019202464、F2019202381);河北省高等学校科学技术研究基金项目(QN2019207);中国科学院自动化研究所模式识别国家重点实验室开放课题基金项目(201900043);天津科技发展战略研究计划基金项目(18ZLZXZF00660)作者简介:于明(1964),男,河北秦皇岛人,博士,教授,CCF会员,研究方向为图像处理与模式识别、智能感知与优化算法;刘子微(1995),女,河北邢台人,硕士研究生,研究方向为情感计算;+通讯作者:师硕(1981),女,河北保定人,博士,副教授,CCF会员,研究方向为情感计算、人脸表情识别、行人再识别;吕华(1980),女,河北沧州人,硕士,讲师,研究方向为智能信息处理。E-mail:shishuo@scse.hebut.edu.cnAudio-videoemotionrecognitionbasedo...