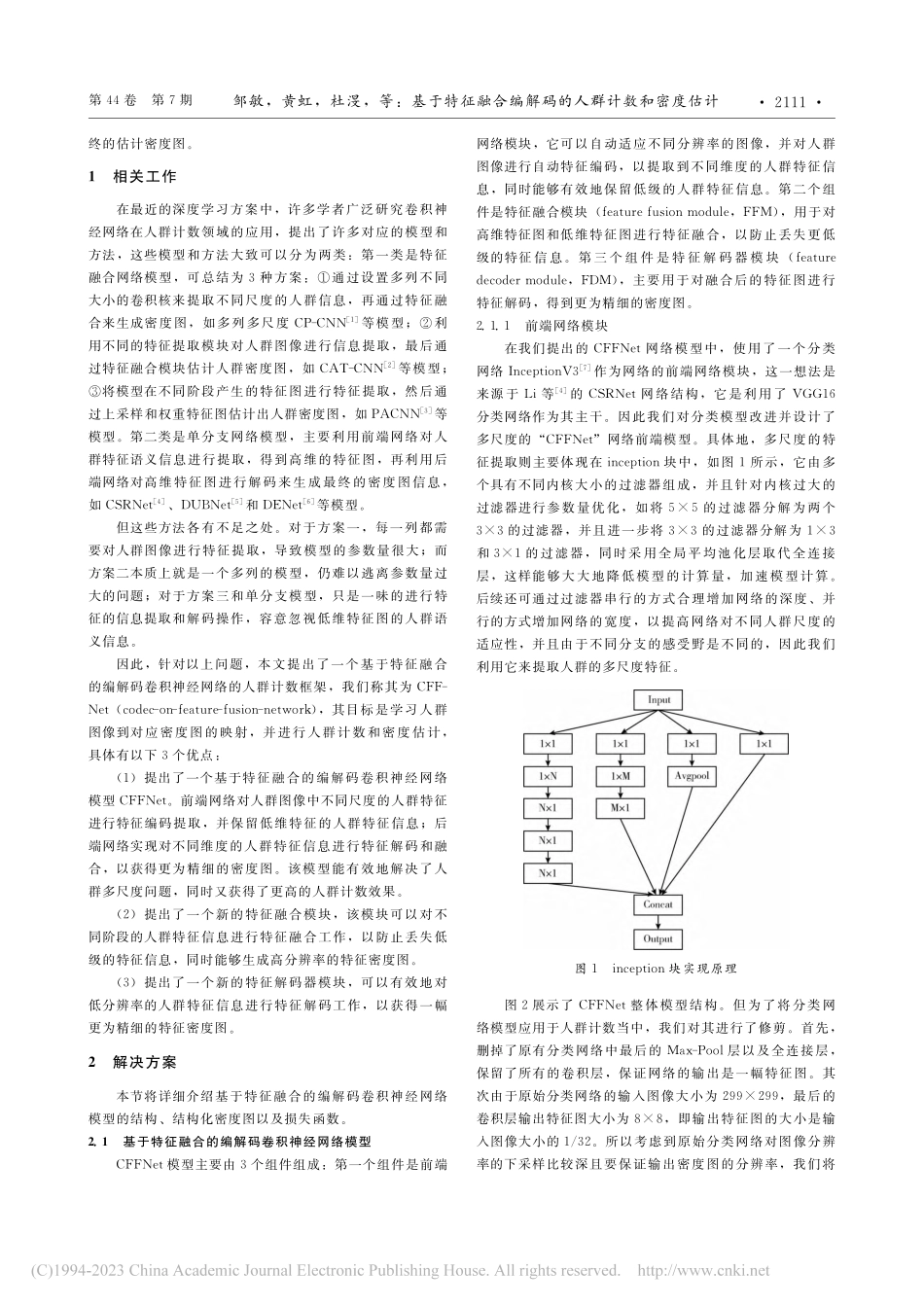

2023年7月第44卷第7期计算机工程与设计COMPUTERENGINEERINGANDDESIGNJuly2023Vol.44■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■■No.7基于特征融合编解码的人群计数和密度估计邹敏1,黄虹2+,杜渂3,黄继风1(1.上海师范大学信息与机电工程学院,上海200234;2.上海师范大学商学院,上海200234;3.上海迪爱斯信息技术股份有限公司,上海200032)摘要:为解决人群计数任务中因人群大小不一导致的计数偏差问题,提出一种基于特征融合的编解码卷积神经网络模型(CFFNet)。前端网络模块对输入的人群图像自动编码,提取不同尺度的人群特征语义信息;后端网络模块对编码后的人群特征信息进行融合和解码,得到最终的估计密度图。将该模型在4个公开数据集上进行实验,并与历年的主要方法进行对比,实验结果表明,该模型在ShanghaiTechPartA、UCSD和Mall数据集上取得了更好的MAE指标,优于目前的这些算法,验证了模型对不同的人群尺度具有很好的适应性。关键词:人群计数;卷积神经网络;编码器;人群尺度;解码器;特征融合;密度图中图法分类号:TP391.4文献标识号:A文章编号:1000-7024(2023)07-2110-08doi:10.16208/j.issn1000-7024.2023.07.025收稿日期:2021-12-20;修订日期:2023-06-19基金项目:上海市地方能力建设基金项目(19070502900)作者简介:邹敏(1997),男,江西上饶人,硕士,研究方向为计算机视觉;+通讯作者:黄虹(1967),女,上海人,博士,教授,研究方向为金融科技和智能会计;杜渂(1975),男,上海人,硕士,教授级高级工程师,研究方向为人工智能、大数据、云计算和物联网;黄继风(1963),男,上海人,博士,教授,研究方向为深度学习与数字图像处理。E-mail:zoumin97@qq.comCrowdcountinganddensityestimationbasedonfeaturefusioncodecZOUMin1,HUANGHong2+,DUWen3,HUANGJi-feng1(1.CollegeofInformationandMechanicalandEle...