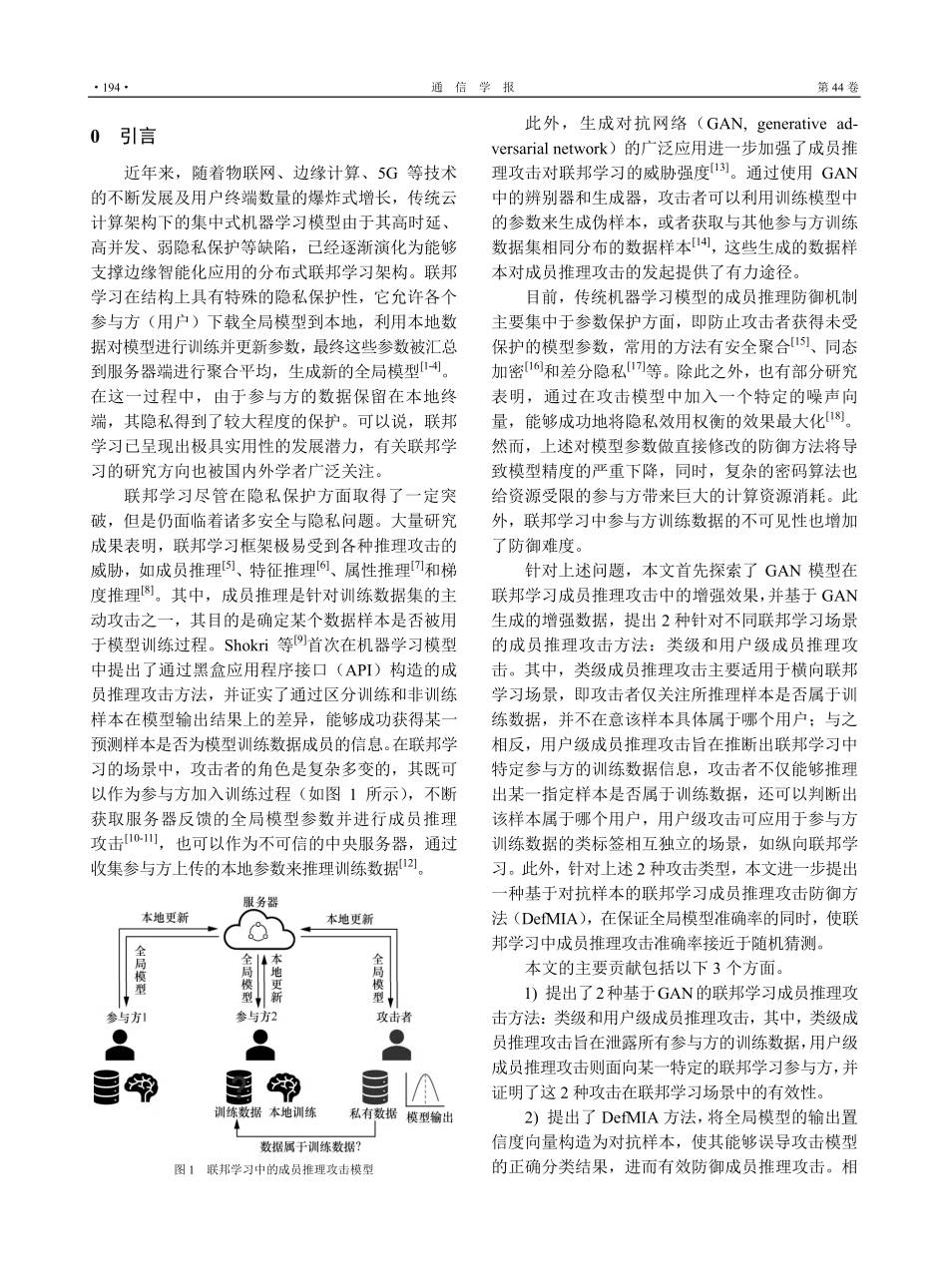

2023年5月JournalonCommunicationsMay2023第44卷第5期通信学报Vol.44No.5基于GAN的联邦学习成员推理攻击与防御方法张佳乐1,2,朱诚诚1,2,孙小兵1,2,陈兵3(1.扬州大学信息工程学院,江苏扬州225127;2.江苏省知识管理与智能服务工程研究中心,江苏扬州225127;3.南京航空航天大学计算机科学与技术学院,江苏南京211106)摘要:针对联邦学习系统极易遭受由恶意参与方在预测阶段发起的成员推理攻击行为,以及现有的防御方法在隐私保护和模型损失之间难以达到平衡的问题,探索了联邦学习中的成员推理攻击及其防御方法。首先提出2种基于生成对抗网络(GAN)的成员推理攻击方法:类级和用户级成员推理攻击,其中,类级成员推理攻击旨在泄露所有参与方的训练数据隐私,用户级成员推理攻击可以指定某一个特定的参与方;此外,进一步提出一种基于对抗样本的联邦学习成员推理防御方法(DefMIA),通过设计针对全局模型参数的对抗样本噪声添加方法,能够在保证联邦学习准确率的同时,有效防御成员推理攻击。实验结果表明,类级和用户级成员推理攻击可以在联邦学习中获得超过90%的攻击精度,而在使用DefMIA方法后,其攻击精度明显降低,接近于随机猜测(50%)。关键词:联邦学习;成员推理攻击;生成对抗网络;对抗样本;隐私泄露中图分类号:TP391文献标志码:ADOI:10.11959/j.issn.1000−436x.2023094MembershipinferenceattackanddefensemethodinfederatedlearningbasedonGANZHANGJiale1,2,ZHUChengcheng1,2,SUNXiaobing1,2,CHENBing31.SchoolofInformationEngineering,YangzhouUniversity,Yangzhou225127,China2.JiangsuEngineeringResearchCenterKnowledgeManagementandIntelligentService,Yangzhou225127,China3.CollegeofComputerScienceandTechnology,NanjingUniversityofAeronauticsandAstronautics,Nanjing211106,ChinaAbstract:Aimingattheproblemthatthefederatedlearningsystemwasextremelyvulnerabletomembershipinferenceattacksinitiatedbymaliciouspartiesinthepredictionstage,andtheexistingdefensemethodsweredifficulttoachieveabalancebetweenprivacyprotectionandmodelloss.Membershipinferenceattacksandtheirdefensemethodswereex-ploredinthecontextoffederatedlearning.Firstly,twomembershipinferenceattackmethodscalledclass-levelattackanduser-levelattackbasedongenerativeadversarialnetwork(GAN)wereproposed,wherethefo...