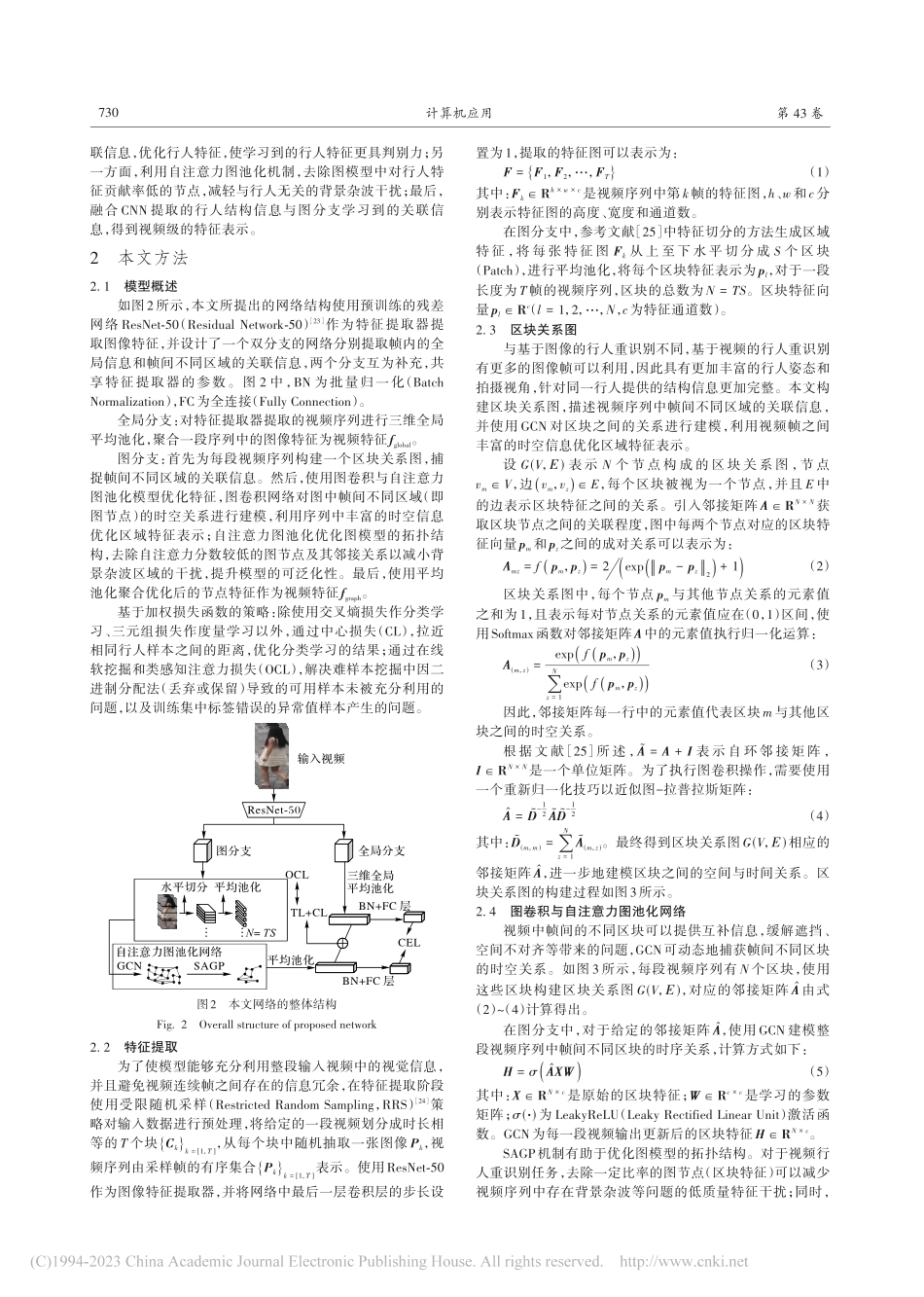

2023⁃03⁃10计算机应用,JournalofComputerApplications2023,43(3):728-735ISSN1001⁃9081CODENJYIIDUhttp://www.joca.cn基于图卷积网络与自注意力图池化的视频行人重识别方法姚英茂,姜晓燕*(上海工程技术大学电子电气工程学院,上海201620)(∗通信作者电子邮箱xiaoyan.jiang@sues.edu.cn)摘要:针对跨相机网络视频中存在的遮挡、空间不对齐、背景杂波等因素导致视频行人重识别效果较差的问题,提出一种基于图卷积网络(GCN)与自注意力图池化(SAGP)的视频行人重识别方法。首先,通过区块关系图建模挖掘视频中帧间不同区域的关联信息,并利用GCN优化逐帧图像中的区域特征,缓解遮挡和不对齐等问题;然后,通过SAGP机制去除对行人特征贡献较低的区域,避免背景杂波区域的干扰;最后,提出一种加权损失函数策略,使用中心损失优化分类学习结果,并使用在线软挖掘和类感知注意力(OCL)损失解决难样本挖掘过程中可用样本未被充分利用的问题。实验结果表明,在MARS数据集上,相较于次优的AITL方法,所提方法的平均精度均值(mAP)与Rank-1分别提高1.3和2.0个百点。所提方法能够较好地利用视频中的时空信息,提取更具判别力的行人特征,提高行人重识别任务的效果。关键词:视频行人重识别;图卷积网络;自注意力图池化;加权损失函数策略;中心损失中图分类号:TP391.4文献标志码:AVideo-basedpersonre-identificationmethodbasedongraphconvolutionnetworkandself-attentiongraphpoolingYAOYingmao,JIANGXiaoyan*(SchoolofElectronicandElectricalEngineering,ShanghaiUniversityofEngineeringScience,Shanghai201620,China)Abstract:Aimingatthebadeffectofvideopersonre-identificationcausedbyfactorssuchasocclusion,spatialmisalignmentandbackgroundclutterincross-cameranetworkvideos,avideo-basedpersonre-identificationmethodbasedonGraphConvolutionalNetwork(GCN)andSelf-AttentionGraphPooling(SAGP)wasproposed.Firstly,thecorrelationinformationofdifferentregionsbetweenframesinthevideowasminedthroughthepatchrelationgraphmodeling.Inordertoalleviatetheproblemssuchasocclusionandmisalignment,theregionfeaturesintheframe-by-frameimageswereoptimizedbyusingGCN.Then,theregionswithlowcontributiontopersonfeatureswereremovedbySAGPmechanismtoavoidtheinterferenceofbackgroundclutterregions.F...