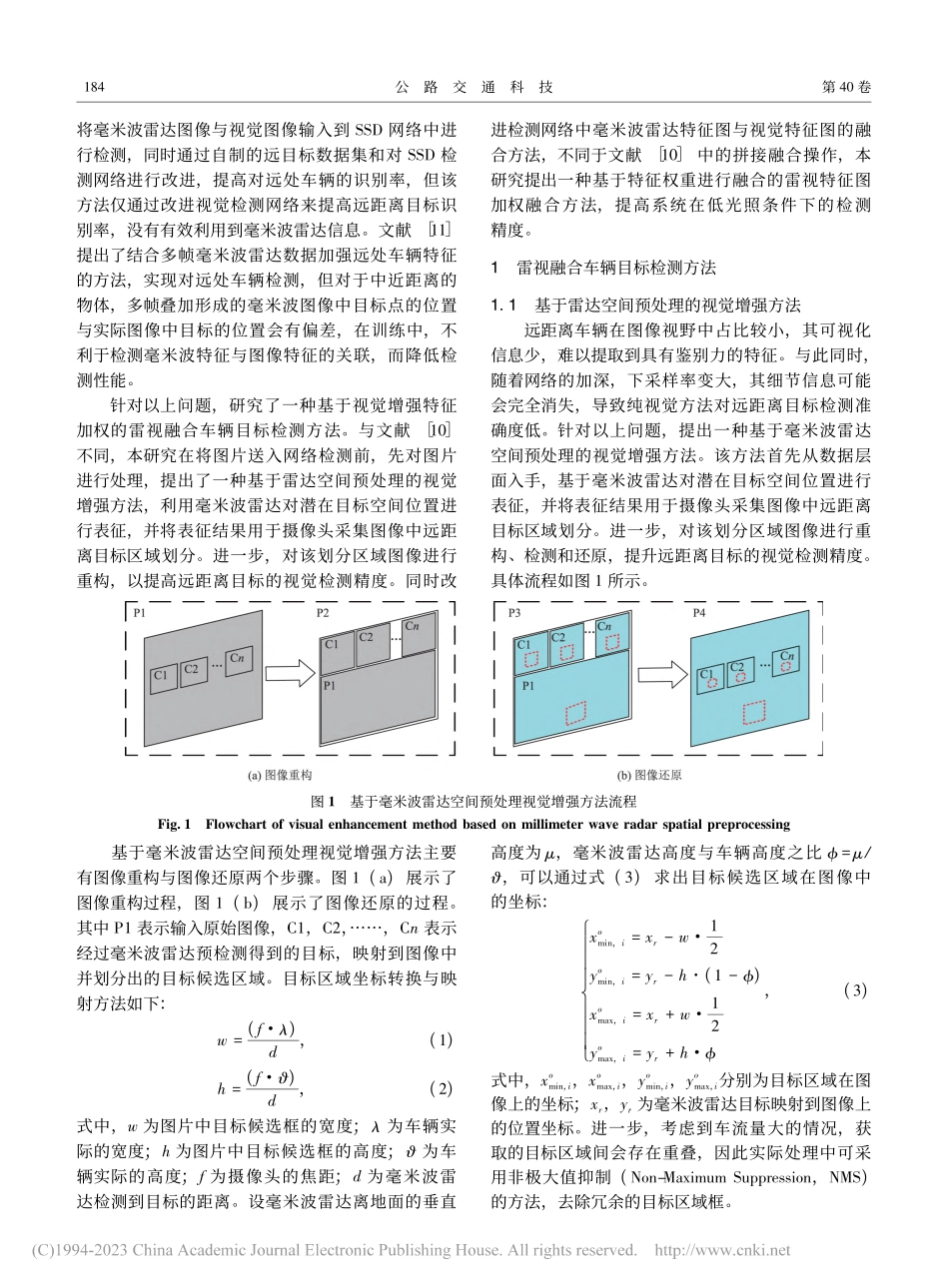

第40卷第2期2023年2月公路交通科技JournalofHighwayandTransportationResearchandDevelopmentVol.40No.2Feb.2023收稿日期:2022-04-01基金项目:国家自然科学基金项目(61762030);广西重点研发计划项目(AB21196021,AB21196032);广西杰出青年基金项目(2019GXNSFFA245007)作者简介:李晓欢(1984-),男,重庆人,教授.(lxhguet@guet.edu.cn)doi:10.3969/j.issn.1002-0268.2023.02.022基于特征加权视觉增强的雷视融合车辆检测方法李晓欢1,2,霍科辛1,颜晓凤3,唐欣1,2,徐韶华4(1.桂林电子科技大学,广西桂林541004;2.广西综合交通大数据研究院,广西南宁530000;3.广西交通科技集团有限公司,广西南宁530000;4.广西北投信创科技投资集团有限公司,广西南宁530000)摘要:为了有效提升高速公路低光照、远距离检测需求条件下的车辆检测准确度,提出了一种基于视觉增强和特征加权的雷视融合车辆目标检测方法。首先从雷视数据层融合入手,基于毫米波雷达对潜在目标空间位置进行表征,并将表征结果用于视觉图像中远距离目标区域划分。其次对该划分区域图像进行重构、检测和还原,以提升远距离目标的视觉检测精度。再次对雷视检测特征层融合进行建模。考虑不同层对特征检测贡献度差异,通过模型训练获取不同特征图的权重参数,并按照权重将不同层特征进行融合计算,以增强目标的特征信息。其次,增加分支网络,利用不同尺寸的卷积层提取特征图中不同的感受野信息,分支输出结果融合获得更强的图像表征能力,达到提高低光照下检测精度的目标。最后,结合特征加权雷视框架和基于毫米波雷达空间预处理的视觉增强思路,基于YOLOv4-tiny框架设计了雷视融合检测网络,完成验证系统搭建。结果表明:在低光照环境下提出的算法与YOLOv4相比,平均精度AP提高了20%,与雷视融合典型算法RVNet相比AP值提高了5%;在针对不同距离下的检测性能测试试验中,本研究算法在检测120m目标时,平均精度值相较YOLOv4算法提高了73%,相较于RVNet提高了63%,提高了智能交通系统车辆检测的覆盖距离和低光照的检测精度。关键词:交通工程;雷视融合;特征加权;视觉增强;深度学习中图分类号:U495文献标识码:A文章编号:1002-0268(2023)02-0182-08AMethodforRadar-cameraFusionVehicleDetectionBasedonFeatureWeightedandVisualEnhancementLIXiao-huan1,2,HUOKe-xin1,YANXiao-feng3,TANGXin1,2,XUShao-hua4(1.GuilinUniversityofElectronicTechnology,GuilinGuangxi541004,China;2.GuangxiComprehensiveTransportationBigDataResearchI...