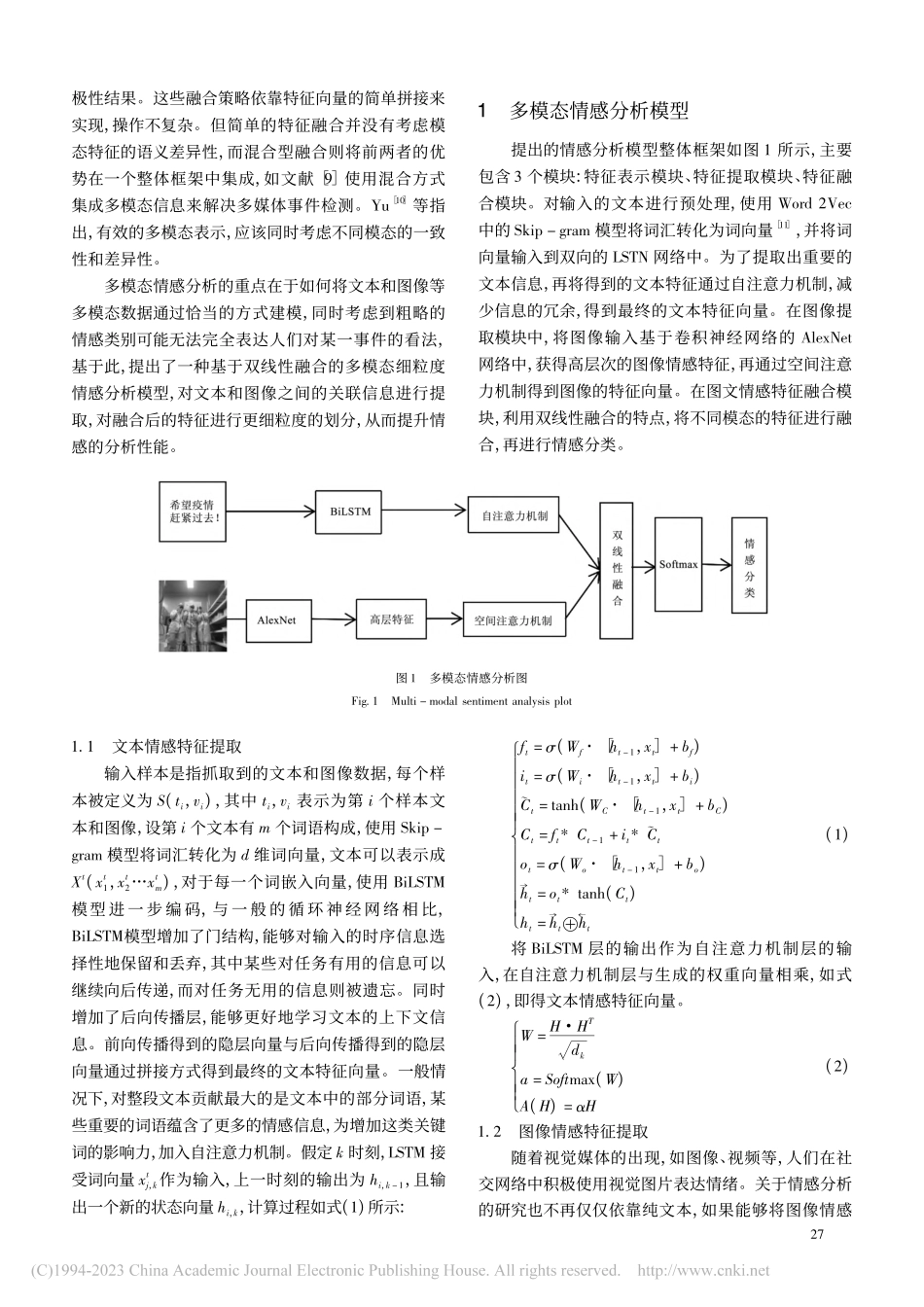

第14卷第4期2023年2月黑龙江科学HEILONGJIANGSCIENCEVol.14Feb.2023基于双线性融合的多模态细粒度情感分析周倩倩(华北水利水电大学,郑州450000)摘要:为充分挖掘多模态情感分析中不同模态内部消息及其复杂的交互关系,消除噪声干扰,最大化发挥数据融合的优势,提出一种基于双线性融合的多模态细粒度情感分析方法,通过两个独立的特征,提取模块对单个模态特征进行编码,充分挖掘模态内部信息,利用双线性融合方法获取模态间的交互信息,得到融合后的特征向量,通过Softmax层进行细粒度的情感分类。与单模态情感分析和一般的多模态情感分析相比,实验取得了很好的结果。关键词:BiLSTM;AlexNet;双线性融合;注意力机制中图分类号:TP391.1文献标志码:A文章编号:1674-8646(2023)04-0026-04MultimodalFine-grainedSentimentAnalysisBasedonBilinearFusionZhouQianqian(NorthChinaUniversityofWaterResourcesandElectricPower,Zhengzhou450000,China)Abstract:Inordertofullyexploretheinternalmessagesofdifferentmodesandthecomplexinteractionrelationshipsbetweentheminmultimodalsentimentanalysis,eliminatenoiseinterference,andmaximizetheadvantagesofdatafusion,thestudyproposesamultimodalfine-grainedsentimentanalysismethodbasedonbilinearfusion.Thismethodfirstcodesasinglemodalfeaturethroughtwoindependentfeatureextractionmodulestofullyexcavatethemodalinternalinformation.Thentheinteractioninformationbetweenthemodesisobtainedbythebilinearfusionmethodtoobtainthefeaturevectorafterfusion.Finally,fine-grainedemotionclassificationisperformedbytheSoftmaxlayer.Comparedwithsinglemodalsentimentanalysisandgeneralmultimodalsentimentanalysis,theexperimenthasachievesgoodresults.Keywords:BiLSTM;AlexNet;Bilinearfusion;Attentionmechanism收稿日期:2022-12-03作者简介:周倩倩(1998-),女,研究生。0引言人们在社交媒体上的表达方式越来越丰富,比如利用图片、文字和视频等多模态方式来表达情绪和观点,这种多模态的情感分析方式已成为情感分析领域的重要手段。与单一模态数据相比,多模态方式包含了更多的信息,多个模态之间可以互相补充,帮助机器更好地识别情感。社交媒体中的多模态数据之间往往具有联系,挖掘其之间的交互性是研究的重要方向之一。目前,主流的多模态融合策略分为特征层融合和...