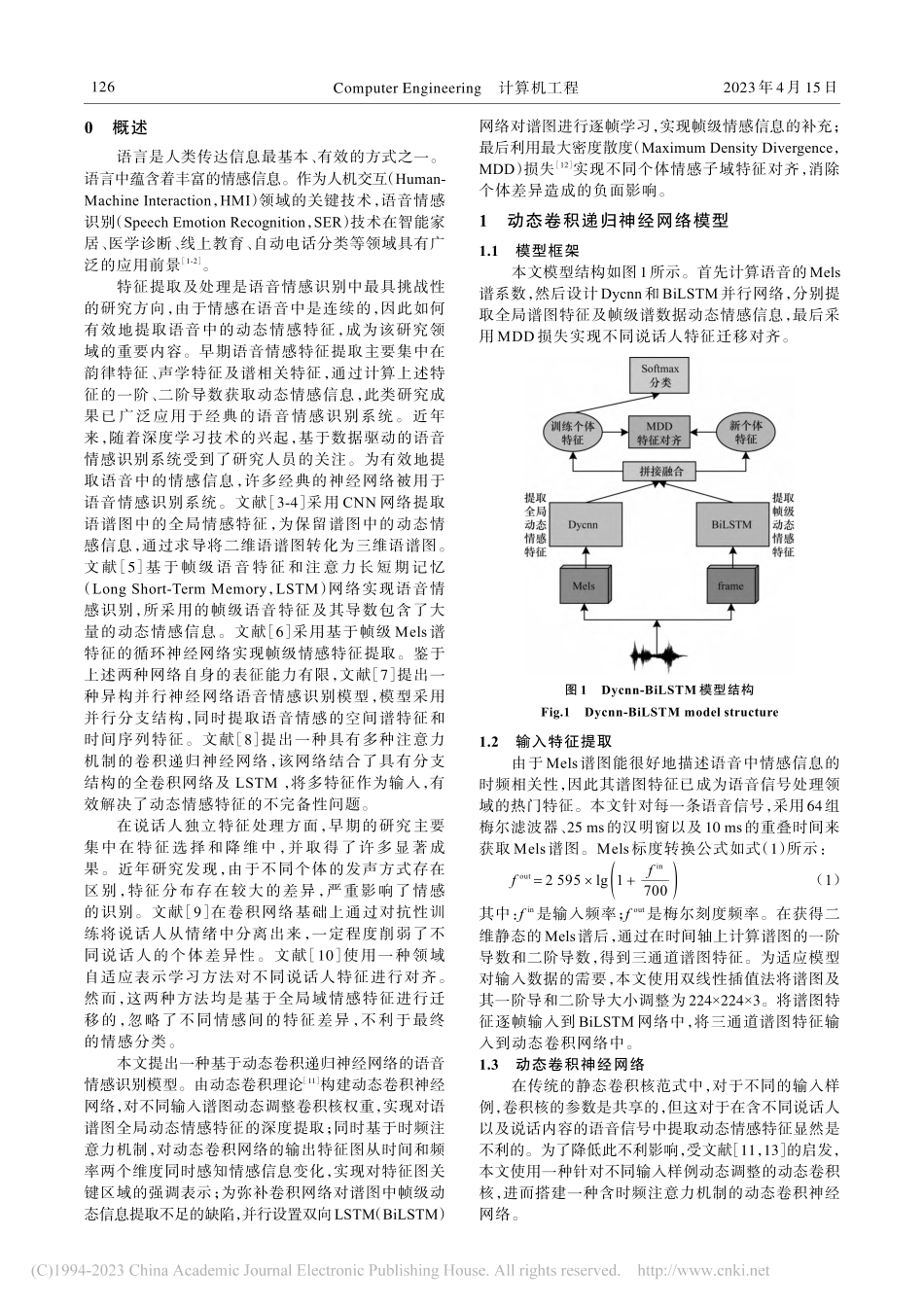

第49卷第4期2023年4月ComputerEngineering计算机工程基于动态卷积递归神经网络的语音情感识别耿磊1,傅洪亮1,陶华伟1,卢远1,郭歆莹1,赵力2(1.河南工业大学粮食信息处理与控制教育部重点实验室,郑州450001;2.东南大学信息科学与工程学院,南京210096)摘要:动态情感特征是说话人独立语音情感识别中的重要特征。由于缺乏对语音中时频信息的充分挖掘,现有动态情感特征表征能力有限。为更好地提取语音中的动态情感特征,提出一种动态卷积递归神经网络语音情感识别模型。基于动态卷积理论构建一种动态卷积神经网络提取语谱图中的全局动态情感信息,使用注意力机制分别从时间和频率维度对特征图关键情感区域进行强化表示,同时利用双向长短期记忆网络对谱图进行逐帧学习,提取动态帧级特征及情感的时序依赖关系。在此基础上,利用最大密度散度损失对齐新个体特征与训练集特征分布,降低个体差异性对特征分布产生的影响,提升模型表征能力。实验结果表明,该模型在CASIA中文情感语料库、Emo-db德文情感语料库及IEMOCAP英文情感语料库上分别取得59.50%、88.01%及66.90%的加权平均精度,相较HuWSF、CB-SER、RNN-Att等其他主流模型识别精度分别提升1.25~16.00、0.71~2.26及2.16~8.10个百分点,验证了所提模型的有效性。关键词:语音情感识别;特征提取;动态特征;注意力机制;神经网络开放科学(资源服务)标志码(OSID):中文引用格式:耿磊,傅洪亮,陶华伟,等.基于动态卷积递归神经网络的语音情感识别[J].计算机工程,2023,49(4):125-130,137.英文引用格式:GENGL,FUHL,TAOHW,etal.Speechemotionrecognitionbasedondynamicconvolutionrecurrentneuralnetwork[J].ComputerEngineering,2023,49(4):125-130,137.SpeechEmotionRecognitionBasedonDynamicConvolutionRecurrentNeuralNetworkGENGLei1,FUHongliang1,TAOHuawei1,LUYuan1,GUOXinying1,ZHAOLi2(1.KeyLaboratoryofFoodInformationProcessingandControl,MinistryofEducation,HenanUniversityofTechnology,Zhengzhou450001,China;2.SchoolofInformationScienceandEngineering,SoutheastUniversity,Nanjing210096,China)【Abstract】Dynamicemotionfeaturesareimportantfeaturesinspeakerindependentspeechemotionrecognition.However,lackofminingonspeechtime-frequencyinformationlimitstherepresentationabilityofexistingdynamicemotionalfeatures.I...