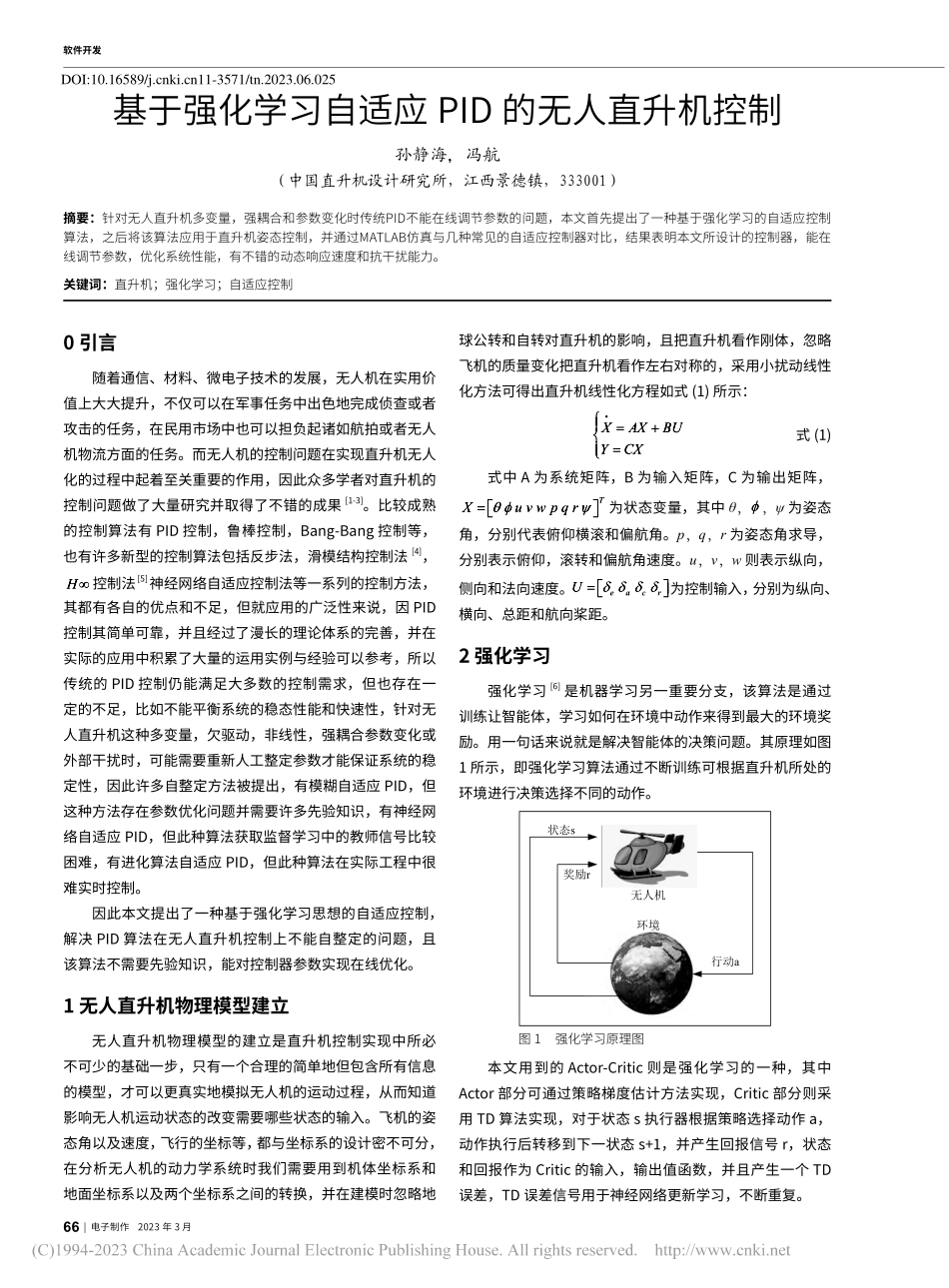

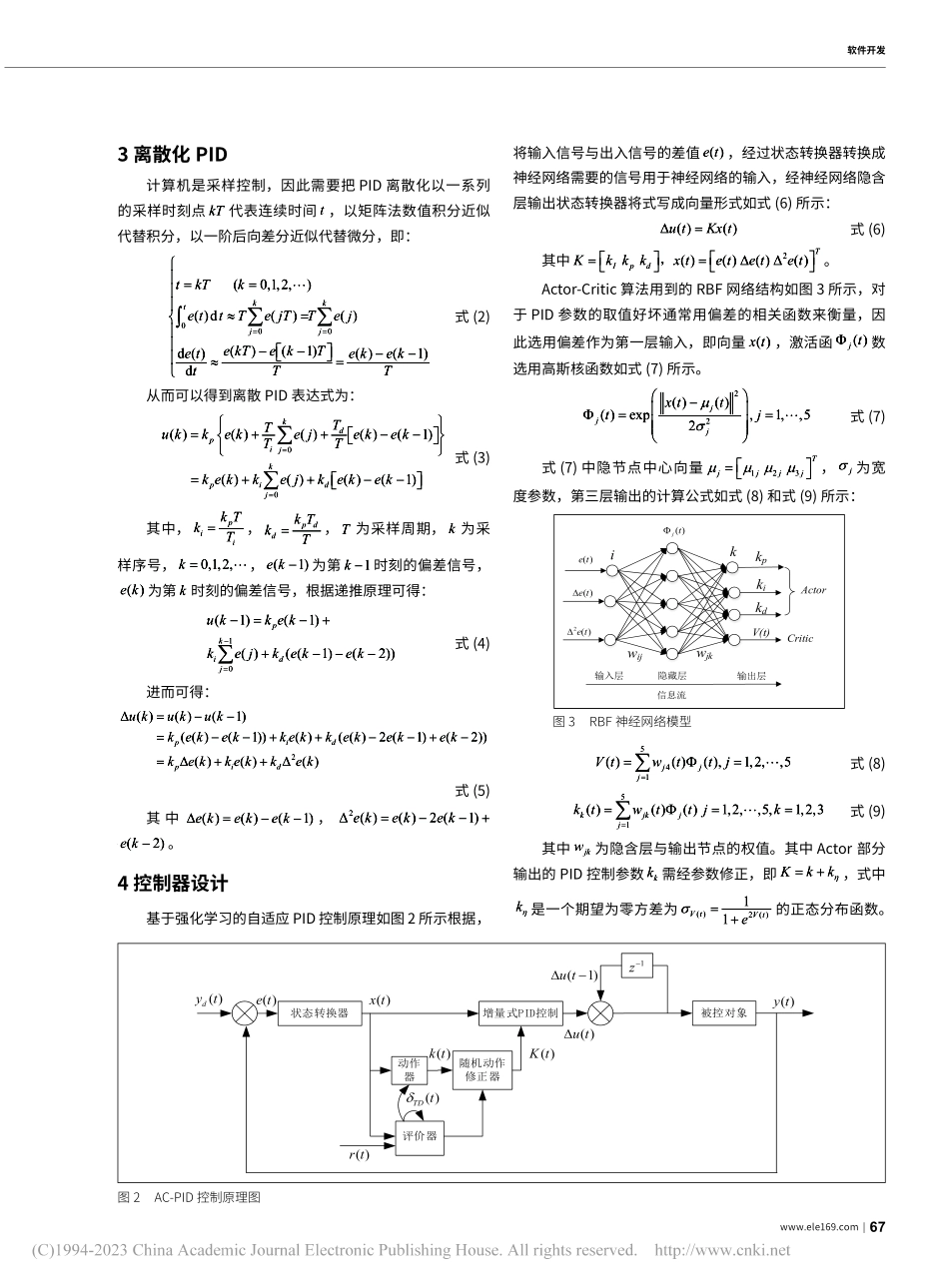

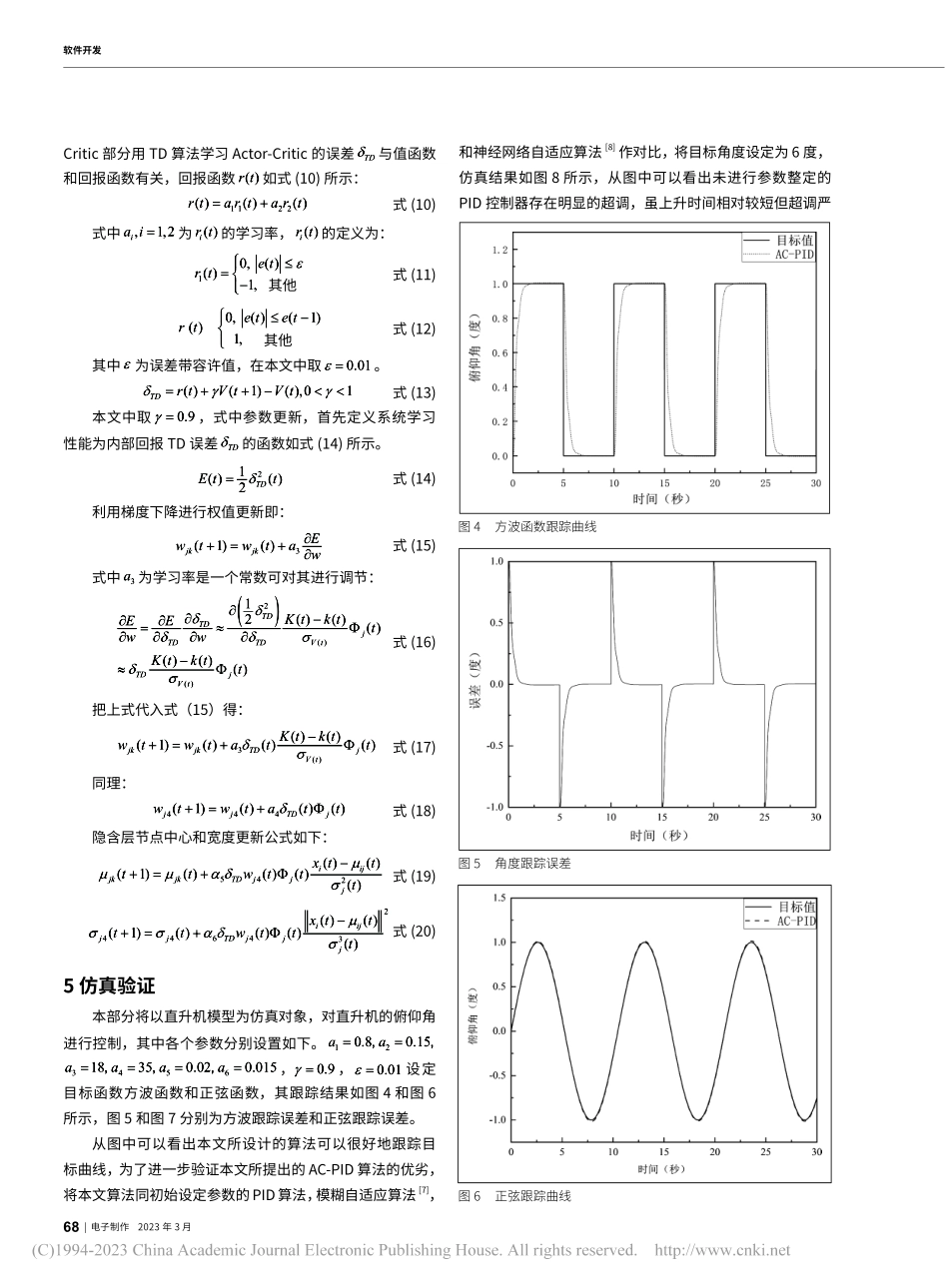

66|电子制作2023年3月软件开发0引言随着通信、材料、微电子技术的发展,无人机在实用价值上大大提升,不仅可以在军事任务中出色地完成侦查或者攻击的任务,在民用市场中也可以担负起诸如航拍或者无人机物流方面的任务。而无人机的控制问题在实现直升机无人化的过程中起着至关重要的作用,因此众多学者对直升机的控制问题做了大量研究并取得了不错的成果[1-3]。比较成熟的控制算法有PID控制,鲁棒控制,Bang-Bang控制等,也有许多新型的控制算法包括反步法,滑模结构控制法[4],H∞控制法[5]神经网络自适应控制法等一系列的控制方法,其都有各自的优点和不足,但就应用的广泛性来说,因PID控制其简单可靠,并且经过了漫长的理论体系的完善,并在实际的应用中积累了大量的运用实例与经验可以参考,所以传统的PID控制仍能满足大多数的控制需求,但也存在一定的不足,比如不能平衡系统的稳态性能和快速性,针对无人直升机这种多变量,欠驱动,非线性,强耦合参数变化或外部干扰时,可能需要重新人工整定参数才能保证系统的稳定性,因此许多自整定方法被提出,有模糊自适应PID,但这种方法存在参数优化问题并需要许多先验知识,有神经网络自适应PID,但此种算法获取监督学习中的教师信号比较困难,有进化算法自适应PID,但此种算法在实际工程中很难实时控制。因此本文提出了一种基于强化学习思想的自适应控制,解决PID算法在无人直升机控制上不能自整定的问题,且该算法不需要先验知识,能对控制器参数实现在线优化。1无人直升机物理模型建立无人直升机物理模型的建立是直升机控制实现中所必不可少的基础一步,只有一个合理的简单地但包含所有信息的模型,才可以更真实地模拟无人机的运动过程,从而知道影响无人机运动状态的改变需要哪些状态的输入。飞机的姿态角以及速度,飞行的坐标等,都与坐标系的设计密不可分,在分析无人机的动力学系统时我们需要用到机体坐标系和地面坐标系以及两个坐标系之间的转换,并在建模时忽略地球公转和自转对直升机的影响,且把直升机看作刚体,忽略飞机的质量变化把直升机看作左右对称的,采用小扰动线性化方法可得出直升机线性化方程如式(1)所示:•XAXBUYCX■|=+■=|■式(1)式中A为系统矩阵,B为输入矩阵,C为输出矩阵,TXuvwpqrθφψ=■■■■为状态变量,其中θ,θφψ,,ψ为姿态角,分别代表俯仰横滚和偏航角。p,q,r为姿态角求导,分别表示俯仰,滚转和偏航角速度。u,v,w则表示纵向,侧向和法向速度。eacr...