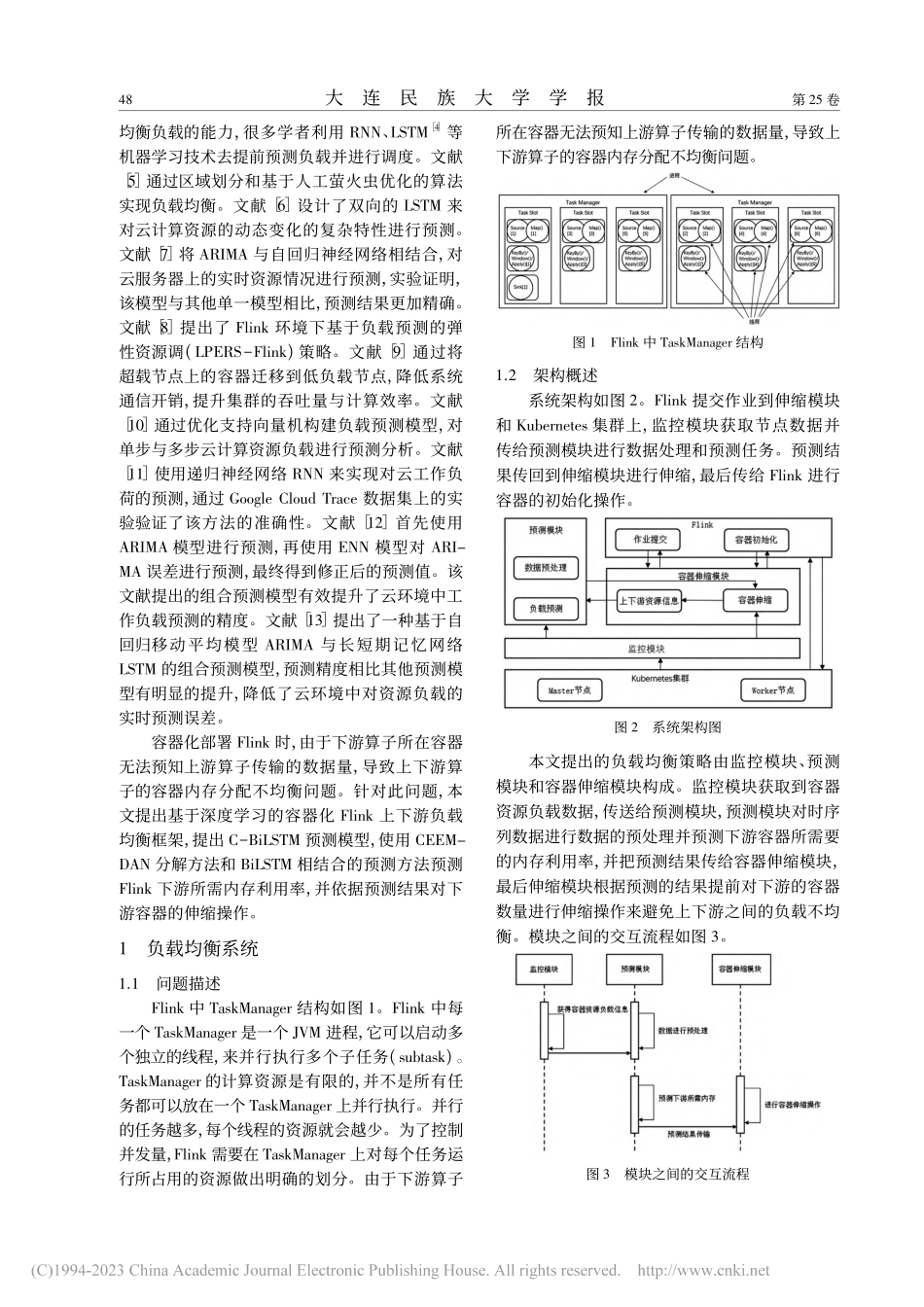

第25卷第1期2023年1月大连民族大学学报JournalofDalianMinzuUniversityVol.25,No.1January2023收稿日期:2022-11-05;最后修回日期:2022-11-30基金项目:国家重点研发计划云计算和大数据重点专项项目(2018YFB1004402)。作者简介:艾力卡木·再比布拉(1997-),男,维吾尔族,新疆吐鲁番人,大连民族大学计算机科学与工程学院硕士研究生,主要从事人工智能与大数据研究。通讯作者:黄山(1986-),男,满族,辽宁锦州人,博士,主要从事大数据和云计算研究,E-mail:huangshan@dlnu.edu.cn。文章编号:2096-1383(2023)01-0047-06基于深度学习的容器化Flink上下游负载均衡策略研究艾力卡木·再比布拉a,b,c,甄妞a,b,c,黄山a,b,c,段晓东a,b,c(大连民族大学a.计算机科学与工程学院;b.大数据应用技术国家民委重点实验室;c.大连市民族文化数字技术重点实验室,辽宁大连116650)摘要:容器化部署Flink时,存在上下游算子的容器内存分配不均衡问题。提出基于深度学习的容器化Flink上下游负载均衡框架,使用CEEMDAN分解方法和BiLSTM相结合的预测方法预测Flink下游容器所需内存,并依据预测结果调整容器内存分配。实验证明:提出的上下游负载均衡策略可有效减少上游容器的等待时间,缓解下游容器的资源,计算效率提高约20%。关键词:Flink;容器负载预测;容器伸缩;深度学习中图分类号:TP311.13文献标志码:AResearchonLoadBalancingStrategyofContainerizedFlinkUpstreamandDownstreamProcessingBasedonDeepLearningAlkamZabibula,b,c,ZHENNiua,b,c,HUANGShana,b,c,DUANXiao-donga,b,c(a.SchoolofComputerScienceandEngineering;b.KeyLaboratoryofBigDataAppliedTechnologyofStateofEthnicAffairsCommission;c.DalianKeyLaboratoryofDigitalTechnologyforNationalCulture,DlianMinzuUniversity,DlianLiaoning116650,China)Abstract:WhendeployingFlinkincontainerenvironment,thecontainerresourcesofupstreamanddownstreamtaskscanhardlybeallocatedbalancedly.AcontainerizedFlinkupstreamanddownstreamloadbalancingframeworkbasedondeeplearningisproposed.ThepredictionmethodcombiningCEEMDANdecompositionmethodandBiLSTMisusedtopredictthememoryre-quiredbyFlinkdownstreamcontainers.Thecontainermemoryallocationisadjustedaccordingtothepredictionresults.Experimentsshowthattheproposedupstreamanddowns...