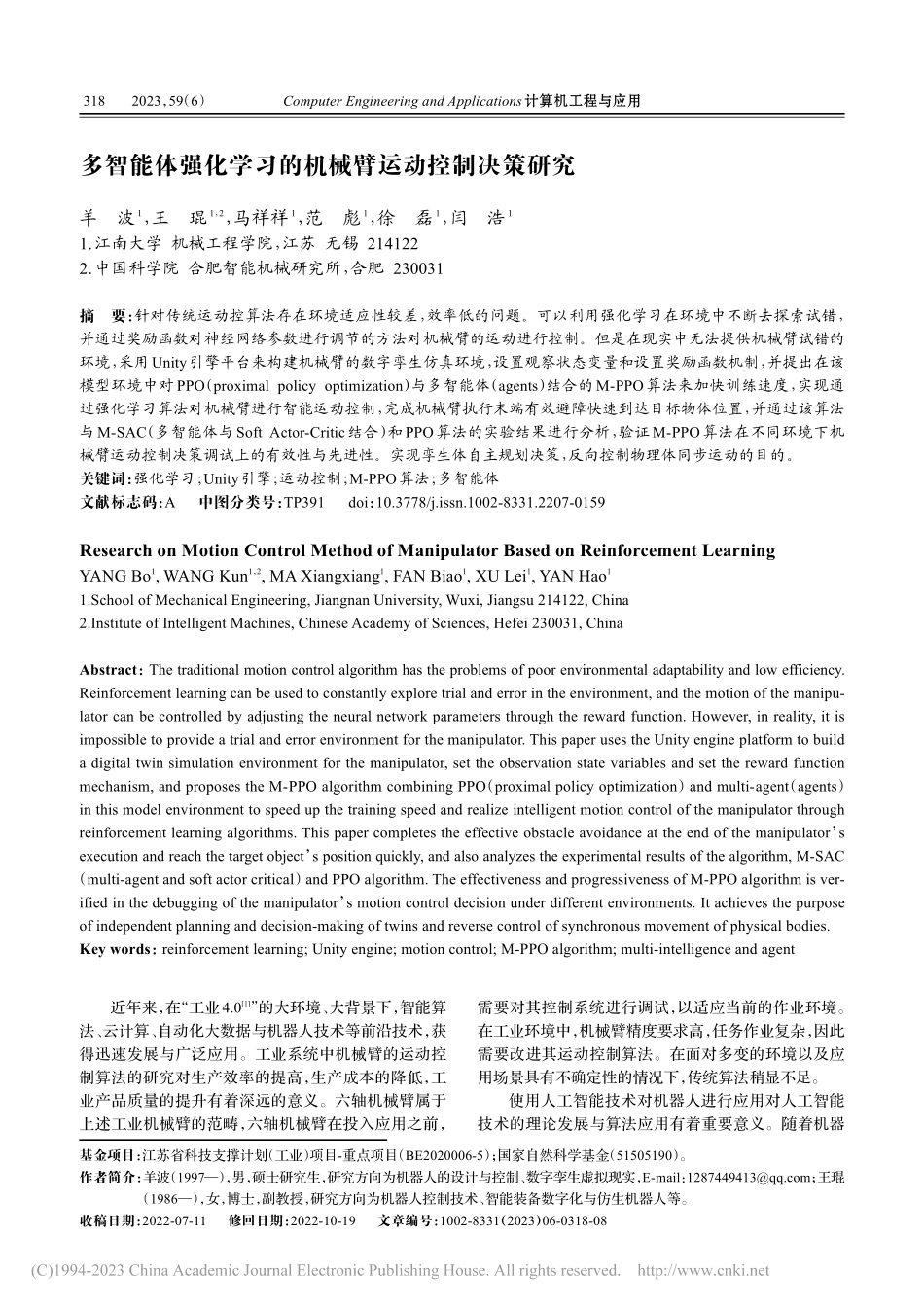

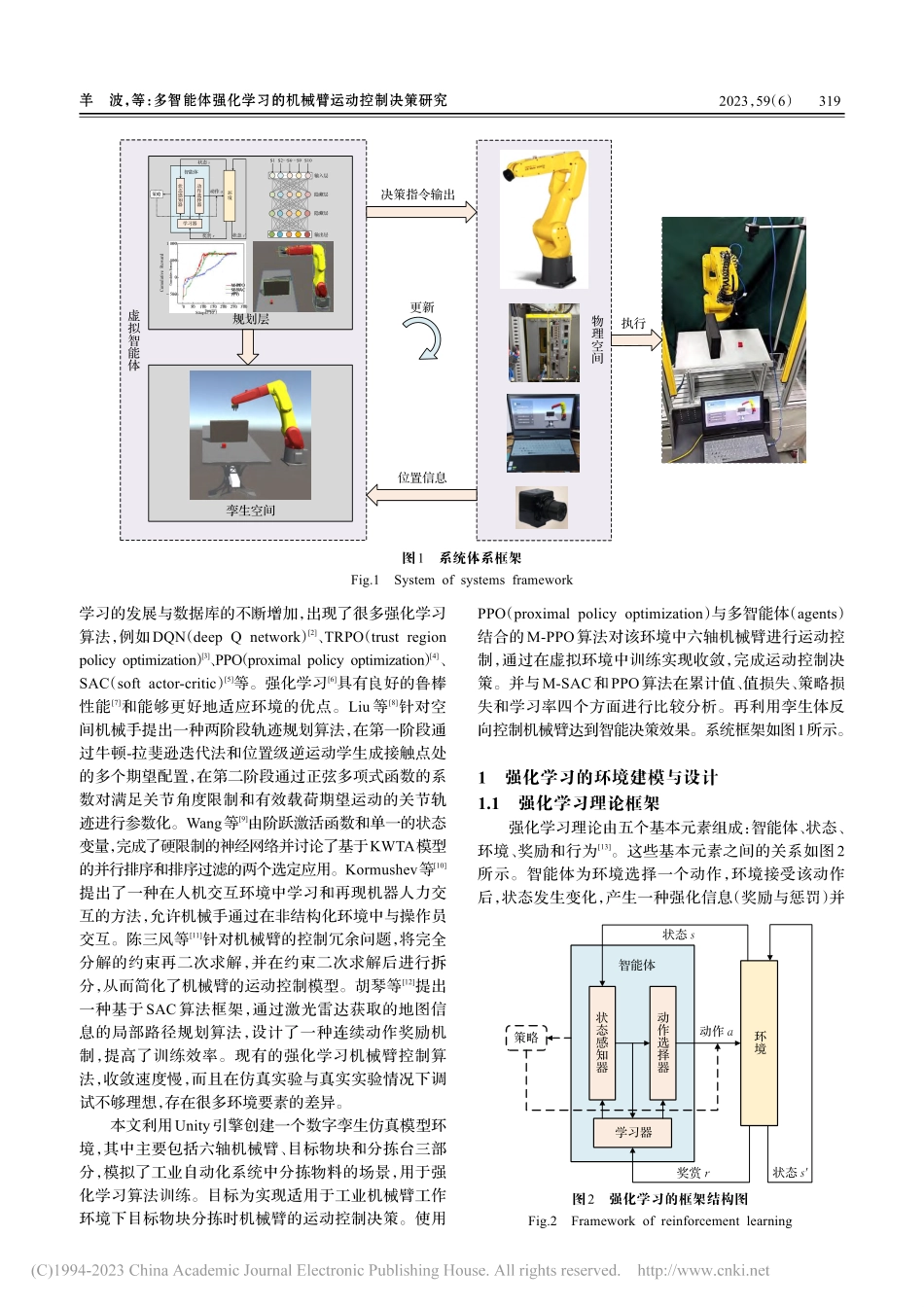

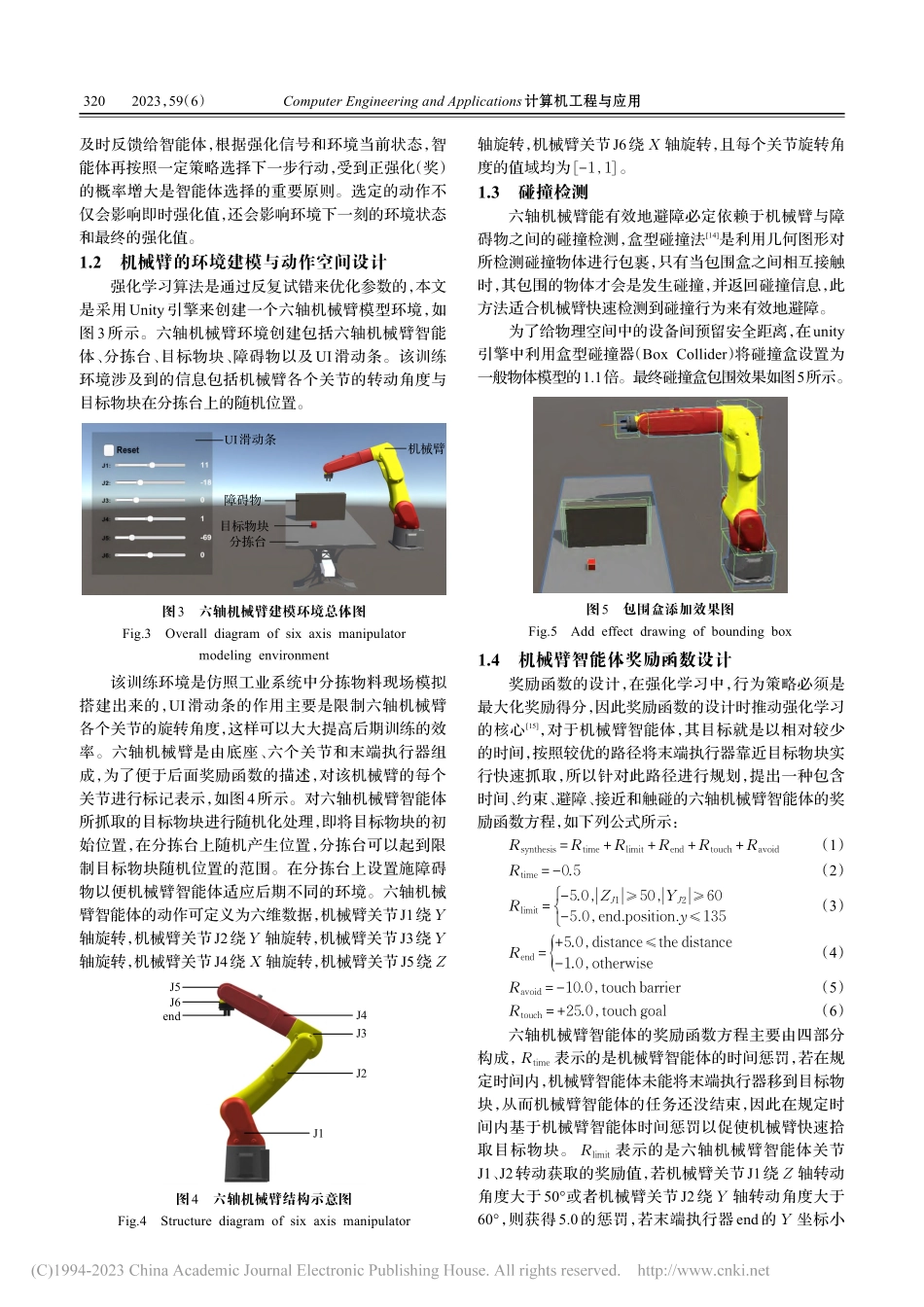

ComputerEngineeringandApplications计算机工程与应用2023,59(6)近年来,在“工业4.0[1]”的大环境、大背景下,智能算法、云计算、自动化大数据与机器人技术等前沿技术,获得迅速发展与广泛应用。工业系统中机械臂的运动控制算法的研究对生产效率的提高,生产成本的降低,工业产品质量的提升有着深远的意义。六轴机械臂属于上述工业机械臂的范畴,六轴机械臂在投入应用之前,需要对其控制系统进行调试,以适应当前的作业环境。在工业环境中,机械臂精度要求高,任务作业复杂,因此需要改进其运动控制算法。在面对多变的环境以及应用场景具有不确定性的情况下,传统算法稍显不足。使用人工智能技术对机器人进行应用对人工智能技术的理论发展与算法应用有着重要意义。随着机器多智能体强化学习的机械臂运动控制决策研究羊波1,王琨1,2,马祥祥1,范彪1,徐磊1,闫浩11.江南大学机械工程学院,江苏无锡2141222.中国科学院合肥智能机械研究所,合肥230031摘要:针对传统运动控算法存在环境适应性较差,效率低的问题。可以利用强化学习在环境中不断去探索试错,并通过奖励函数对神经网络参数进行调节的方法对机械臂的运动进行控制。但是在现实中无法提供机械臂试错的环境,采用Unity引擎平台来构建机械臂的数字孪生仿真环境,设置观察状态变量和设置奖励函数机制,并提出在该模型环境中对PPO(proximalpolicyoptimization)与多智能体(agents)结合的M-PPO算法来加快训练速度,实现通过强化学习算法对机械臂进行智能运动控制,完成机械臂执行末端有效避障快速到达目标物体位置,并通过该算法与M-SAC(多智能体与SoftActor-Critic结合)和PPO算法的实验结果进行分析,验证M-PPO算法在不同环境下机械臂运动控制决策调试上的有效性与先进性。实现孪生体自主规划决策,反向控制物理体同步运动的目的。关键词:强化学习;Unity引擎;运动控制;M-PPO算法;多智能体文献标志码:A中图分类号:TP391doi:10.3778/j.issn.1002-8331.2207-0159ResearchonMotionControlMethodofManipulatorBasedonReinforcementLearningYANGBo1,WANGKun1,2,MAXiangxiang1,FANBiao1,XULei1,YANHao11.SchoolofMechanicalEngineering,JiangnanUniversity,Wuxi,Jiangsu214122,China2.InstituteofIntelligentMachines,ChineseAcademyofSciences,Hefei230031,ChinaAbstract:Thetraditionalmotioncontrolalgorithmhastheproblemsofpoorenvironmentaladaptabilityandlowefficiency.R...