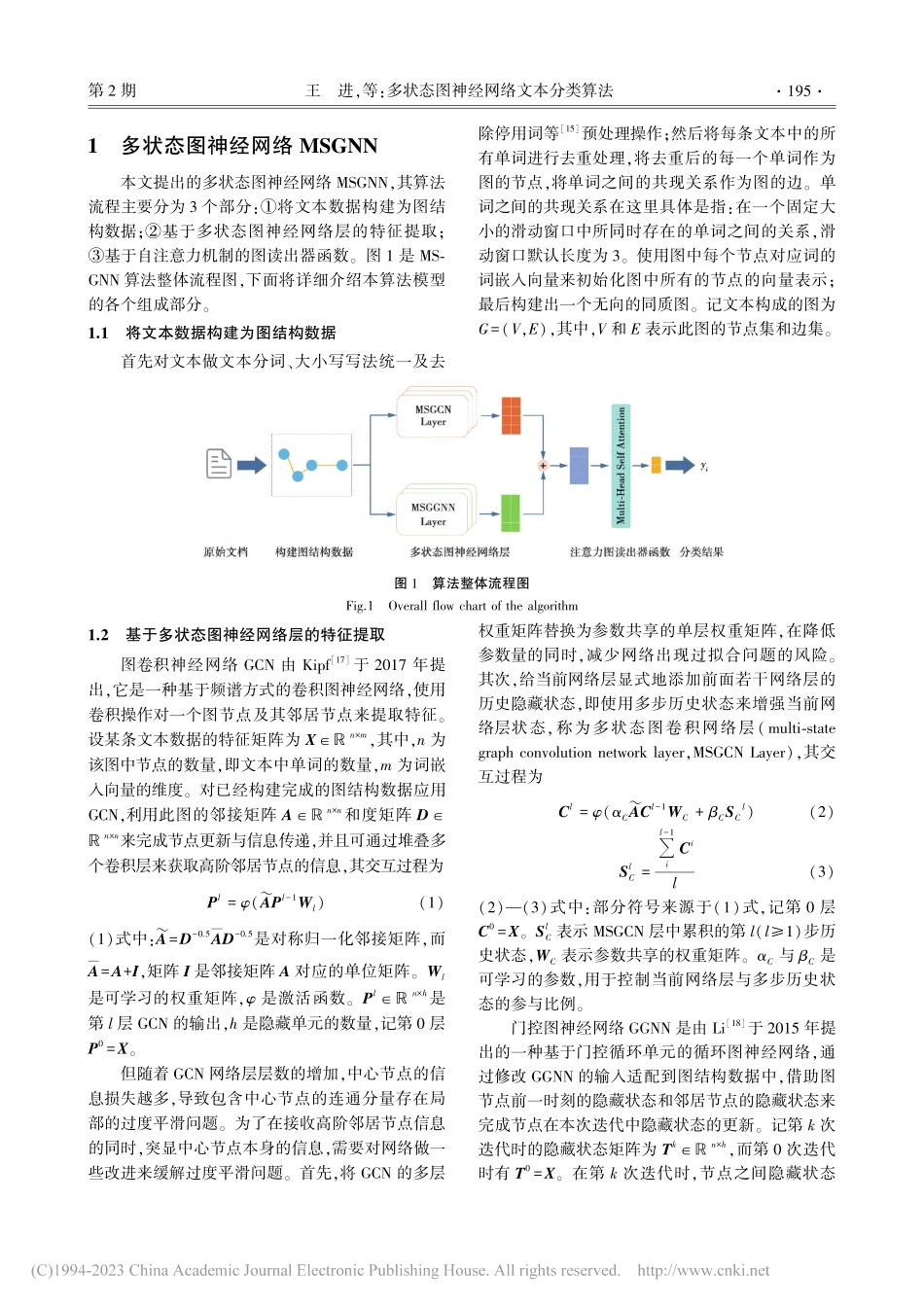

第35卷第2期重庆邮电大学学报(自然科学版)Vol.35No.22023年4月JournalofChongqingUniversityofPostsandTelecommunications(NaturalScienceEdition)Apr.2023DOI:10.3979/j.issn.1673⁃825X.202110200360多状态图神经网络文本分类算法收稿日期:2021⁃10⁃20修订日期:2023⁃02⁃18通讯作者:王进wangjin@cqupt.edu.cn基金项目:国家重点研发计划专项(SQ2021YFE010559)FoundationItem:TheNationalKeyResearchandDevelopmentProgramofChina(SQ2021YFE010559)王进,陈重元,邓欣,孙开伟(重庆邮电大学数据工程与可视计算重点实验室,重庆400065)摘要:为了提高模型在文本分类任务中的分类性能,针对图神经网络中存在的过度平滑问题,同时增强模型在处理文本特征与文本表示方面的能力,提出了一种基于多状态图神经网络的文本分类算法(multi⁃stategraphneuralnetwork,MSGNN)。多状态图神经网络是利用网络层的多个历史状态信息对图神经网络进行强化,构建合理的文本图结构数据作为模型输入。在缓解网络层过度平滑问题的同时,结合2种改进后的不同类型的图神经网络来增强模型的特征提取与特征聚合能力。利用多头自注意力机制对文本关键词的挖掘与利用能力,从多个文本子空间来生成高质量的文本表示,进而完成文本分类。通过在几个公开的文本分类数据集上进行实验分析,相较于其他神经网络的文本分类算法,该方法取得了较好的分类准确率。关键词:自然语言处理;文本分类;图神经网络;注意力机制中图分类号:TP389.1文献标志码:A文章编号:1673⁃825X(2023)02⁃0193⁃09Multi⁃stategraphneuralnetworkfortextclassificationWANGJin,CHENChongyuan,DENGXin,SUNKaiwei(KeyLaboratoryofDataEngineeringandVisualComputing,ChongqingUniversityofPostsandTelecommunications...