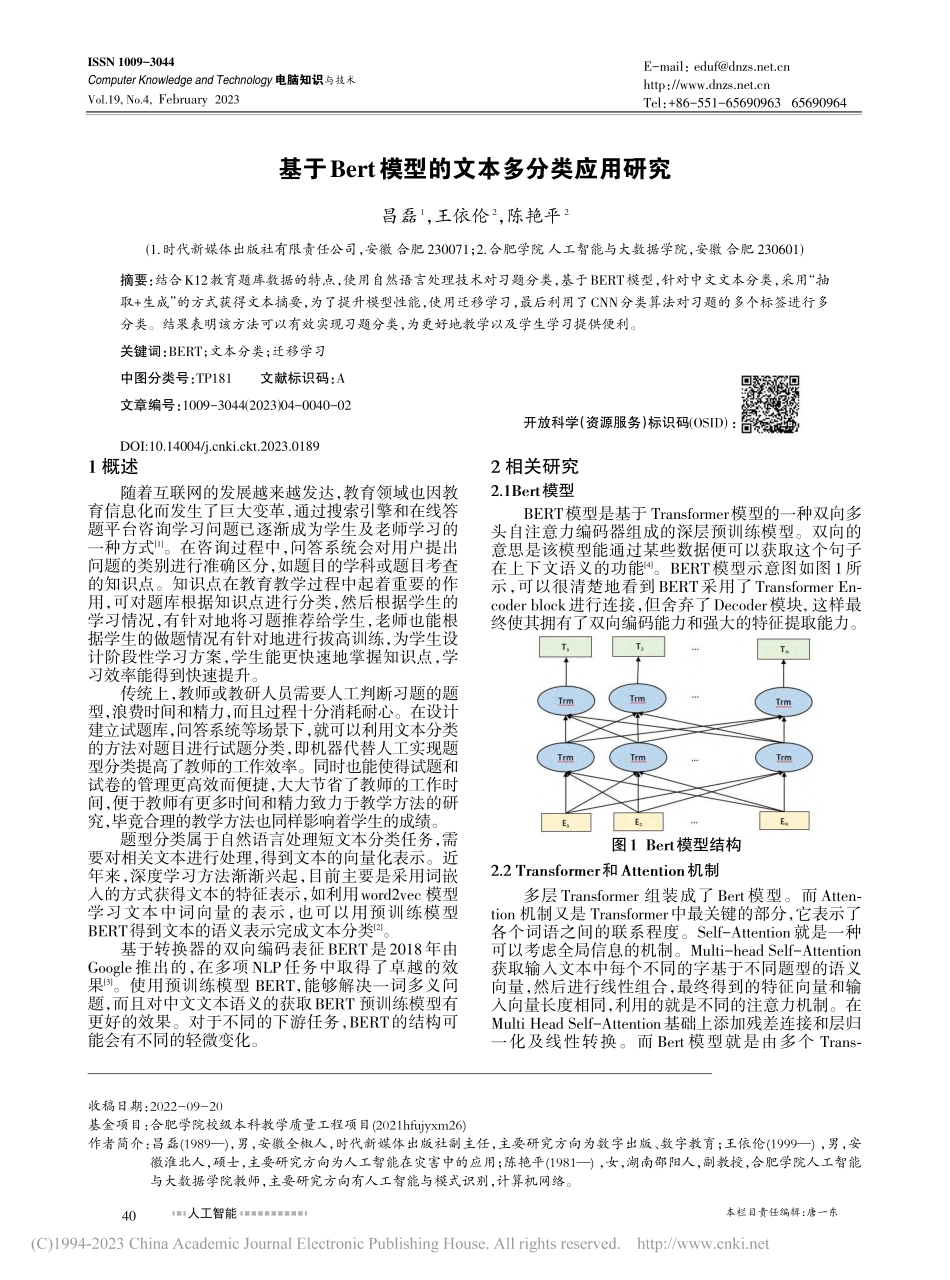

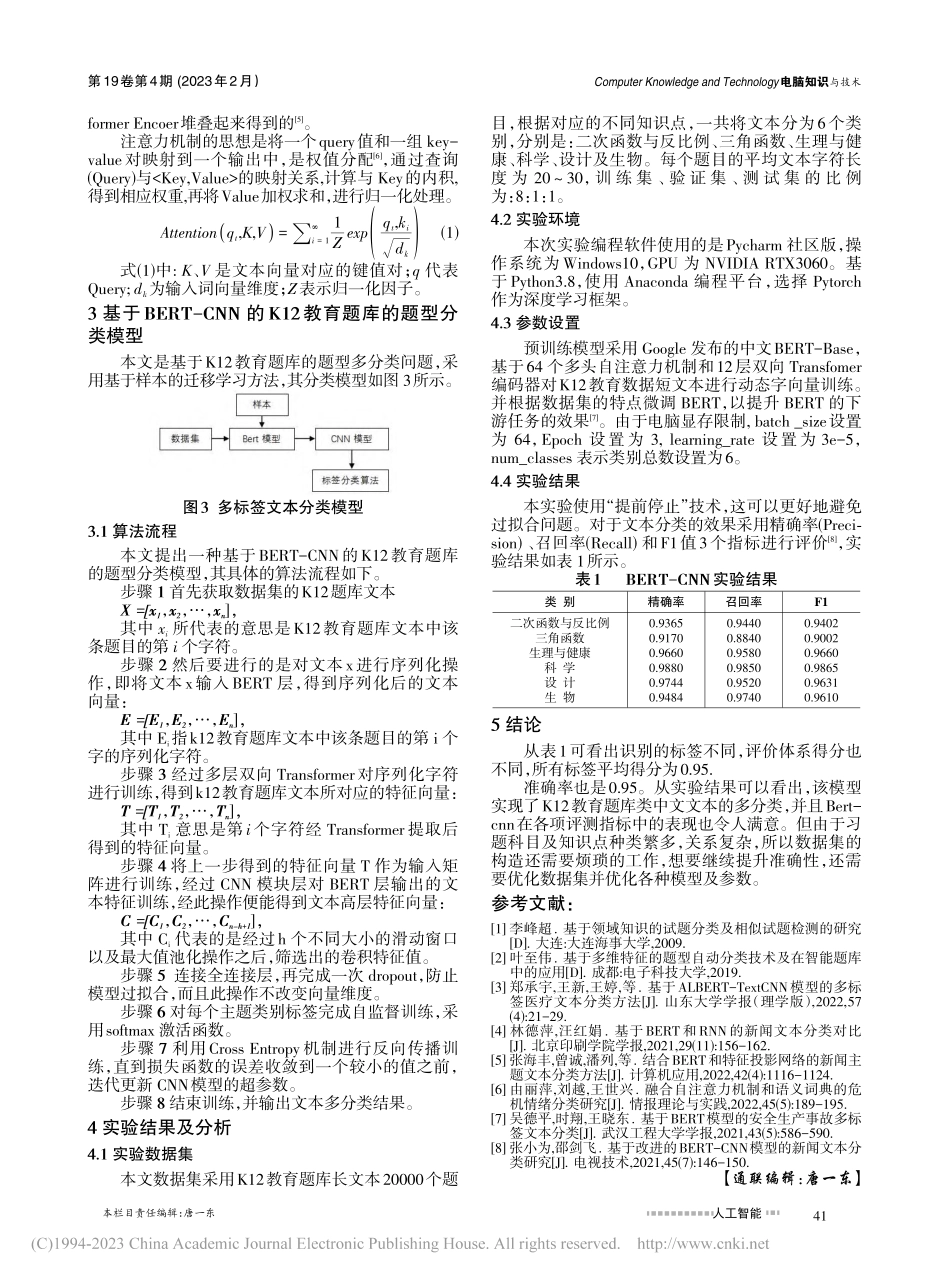

本栏目责任编辑:唐一东人工智能ComputerKnowledgeandTechnology电脑知识与技术第19卷第4期(2023年2月)基于Bert模型的文本多分类应用研究昌磊1,王依伦2,陈艳平2(1.时代新媒体出版社有限责任公司,安徽合肥230071;2.合肥学院人工智能与大数据学院,安徽合肥230601)摘要:结合K12教育题库数据的特点,使用自然语言处理技术对习题分类,基于BERT模型,针对中文文本分类,采用“抽取+生成”的方式获得文本摘要,为了提升模型性能,使用迁移学习,最后利用了CNN分类算法对习题的多个标签进行多分类。结果表明该方法可以有效实现习题分类,为更好地教学以及学生学习提供便利。关键词:BERT;文本分类;迁移学习中图分类号:TP181文献标识码:A文章编号:1009-3044(2023)04-0040-02开放科学(资源服务)标识码(OSID):1概述随着互联网的发展越来越发达,教育领域也因教育信息化而发生了巨大变革,通过搜索引擎和在线答题平台咨询学习问题已逐渐成为学生及老师学习的一种方式[1]。在咨询过程中,问答系统会对用户提出问题的类别进行准确区分,如题目的学科或题目考查的知识点。知识点在教育教学过程中起着重要的作用,可对题库根据知识点进行分类,然后根据学生的学习情况,有针对地将习题推荐给学生,老师也能根据学生的做题情况有针对地进行拔高训练,为学生设计阶段性学习方案,学生能更快速地掌握知识点,学习效率能得到快速提升。传统上,教师或教研人员需要人工判断习题的题型,浪费时间和精力,而且过程十分消耗耐心。在设计建立试题库,问答系统等场景下,就可以利用文本分类的方法对题目进行试题分类,即机器代替人工实现题型分类提高了教师的工作效率。同时也能使得试题和试卷的管理更高效而便捷,大大节省了教师的工作时间,便于教师有更多时间和精力致力于教学方法的研究,毕竟合理的教学方法也同样影响着学生的成绩。题型分类属于自然语言处理短文本分类任务,需要对相关文本进行处理,得到文本的向量化表示。近年来,深度学习方法渐渐兴起,目前主要是采用词嵌入的方式获得文本的特征表示,如利用word2vec模型学习文本中词向量的表示,也可以用预训练模型BERT得到文本的语义表示完成文本分类[2]。基于转换器的双向编码表征BERT是2018年由Google推出的,在多项NLP任务中取得了卓越的效果[3]。使用预训练模型BERT,能够解决一词多义问题,而且对中文文本语义的获取BERT预训练模型有更好的效果。对于不同的下游任务,BERT的结构可能会有不同...