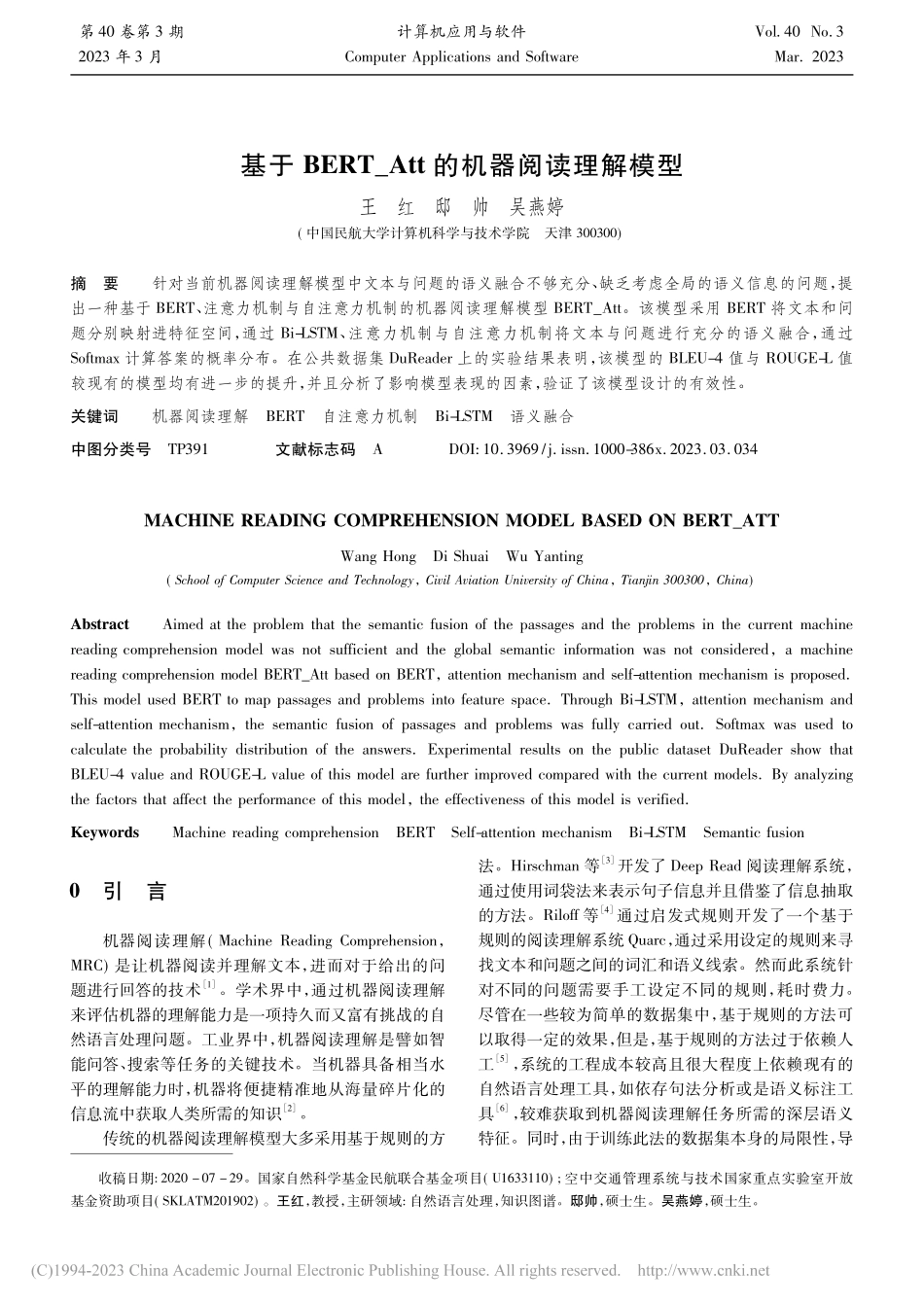

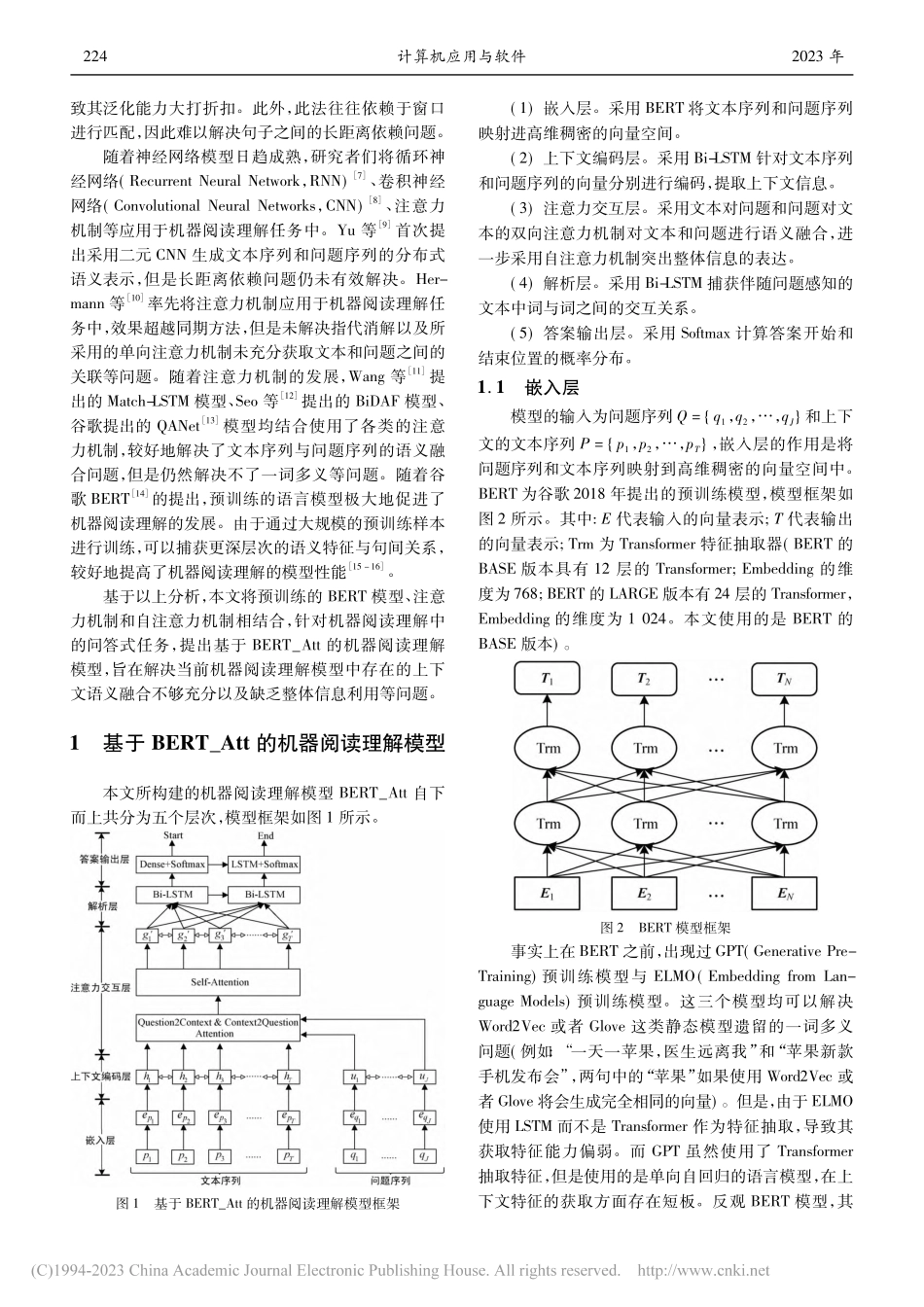

第40卷第3期计算机应用与软件Vol.40No.32023年3月ComputerApplicationsandSoftwareMar.2023基于BERT_Att的机器阅读理解模型王红邸帅吴燕婷(中国民航大学计算机科学与技术学院天津300300)收稿日期:2020-07-29。国家自然科学基金民航联合基金项目(U1633110);空中交通管理系统与技术国家重点实验室开放基金资助项目(SKLATM201902)。王红,教授,主研领域:自然语言处理,知识图谱。邸帅,硕士生。吴燕婷,硕士生。摘要针对当前机器阅读理解模型中文本与问题的语义融合不够充分、缺乏考虑全局的语义信息的问题,提出一种基于BERT、注意力机制与自注意力机制的机器阅读理解模型BERT_Att。该模型采用BERT将文本和问题分别映射进特征空间,通过Bi-LSTM、注意力机制与自注意力机制将文本与问题进行充分的语义融合,通过Softmax计算答案的概率分布。在公共数据集DuReader上的实验结果表明,该模型的BLEU-4值与ROUGE-L值较现有的模型均有进一步的提升,并且分析了影响模型表现的因素,验证了该模型设计的有效性。关键词机器阅读理解BERT自注意力机制Bi-LSTM语义融合中图分类号TP391文献标志码ADOI:10.3969/j.issn.1000-386x.2023.03.034MACHINEREADINGCOMPREHENSIONMODELBASEDONBERT_ATTWangHongDiShuaiWuYanting(SchoolofComputerScienceandTechnology,CivilAviationUniversityofChina,Tianjin300300,China)AbstractAimedattheproblemthatthesemanticfusionofthepassagesandtheproblemsinthecurrentmachinereadingcomprehensionmodelwasnotsufficientandtheglobalsemanticinformationwasnotconsidered,amachinereadingcomprehensionmodelBERT_AttbasedonBERT,attentionmechanismandself-attentionmechanismisproposed.ThismodelusedBERTtomappassagesandproblemsintofeaturespace.ThroughBi-LSTM,attentionmechanismandself-attentionmechanism,thesemanticfusionofpassagesandproblemswasfullycarriedout.Softmaxwasusedtocalculatetheprobabilitydistributionoftheanswers.ExperimentalresultsonthepublicdatasetDuReadershowthatBLEU-4valueandROUGE-Lvalueofthismodelarefurtherimprovedcomparedwiththecurrentmodels.Byanalyzingthefactorsthataffecttheperformanceofthismodel,theeffectivenessofthismodelisverified.KeywordsMachinereadingcomprehensionBERTSelf-attentionmechanismBi-LSTMSemanticfusion0...