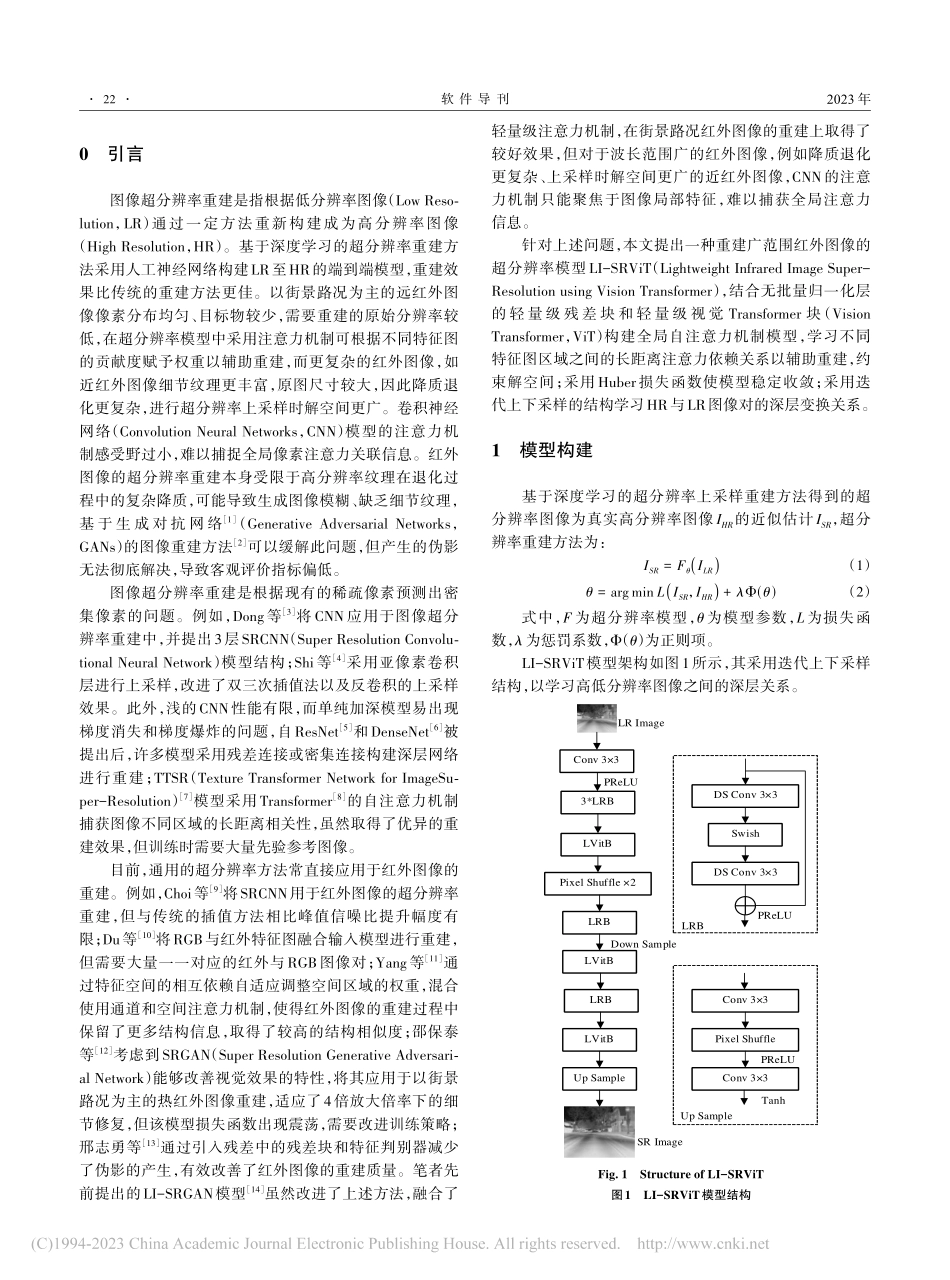

第22卷第2期2023年2月Vol.22No.2Feb.2023软件导刊SoftwareGuide融合轻量级ViT与CNN的广范围红外图像超分辨率重建沈恺涛1,闵天悦2,胡德敏2(1.上海理工大学信息化办公室;2.上海理工大学光电信息与计算机工程学院,上海200093)摘要:卷积神经网络的注意力机制模型重建波长范围广的红外图像时只能聚焦于局部特征、感受野小,为此提出一种适用于重建广范围红外图像的融合轻量级视觉Transformer(ViT)与卷积神经网络的模型。该模型采用改进的轻量级残差块结合轻量级ViT块构建全局自注意力机制模型,学习不同特征图区域之间的长距离注意力依赖关系以辅助重建,约束解空间,采用Huber损失函数使模型稳定收敛,通过迭代上下采样的方式挖掘高低分辨率图像对的深层变换关系。使用近红外图像和远红外图像数据集进行实验,该模型以1031K的参数量在峰值信噪比和结构相似度比较中超越了参数量为1518K的轻量级模型SRResNet和1592K的CARN,接近于参数量为4543K的重量级模型ED⁃SR,表明该模型可以有效重建不同波长的红外图像。关键词:红外图像;轻量;视觉Transformer;超分辨率;自注意力DOI:10.11907/rjdk.221167开放科学(资源服务)标识码(OSID):中图分类号:TP183文献标识码:A文章编号:1672-7800(2023)002-0021-07Wide-rangeInfraredImageSuper-ResolutionReconstructionIntegratingLightweightViTandCNNSHENKai-tao1,MINTian-yue2,HUDe-min2(1.InformationOffice,UniversityofShanghaiforScience&Technology;2.SchoolofOptical-Electrical&ComputerEngineering,UniversityofShanghaiforScience&Technology,Shanghai200093,China)Abstract:Inordertosolvetheproblemthattheattentionmechanismmodelofconvolutionneuralnetworks(CNN)canonlyfocusonlocalfea⁃turesandsmallreceptivefieldwhenreconstructinginfraredimageswithawidewavelengthrange,proposeanewmethodwithlightweightViTandCNNsuitableforreconstructinginfraredimageswithawiderange.ThemodelusedanimprovedlightweightresidualblockcombinedwithalightweightViTblocktobuildaglobalself-attentionmechanismmodel,learnedlong-distanceattentiondependenciesbetweendifferentfea⁃turemapregionstoassistreconstructionandconstrainthesolutionspace.ItusedHuberlossfunctiontomakethemodelconvergestably.Itminedthedeeptransformationrelationshipbetweenhighan...