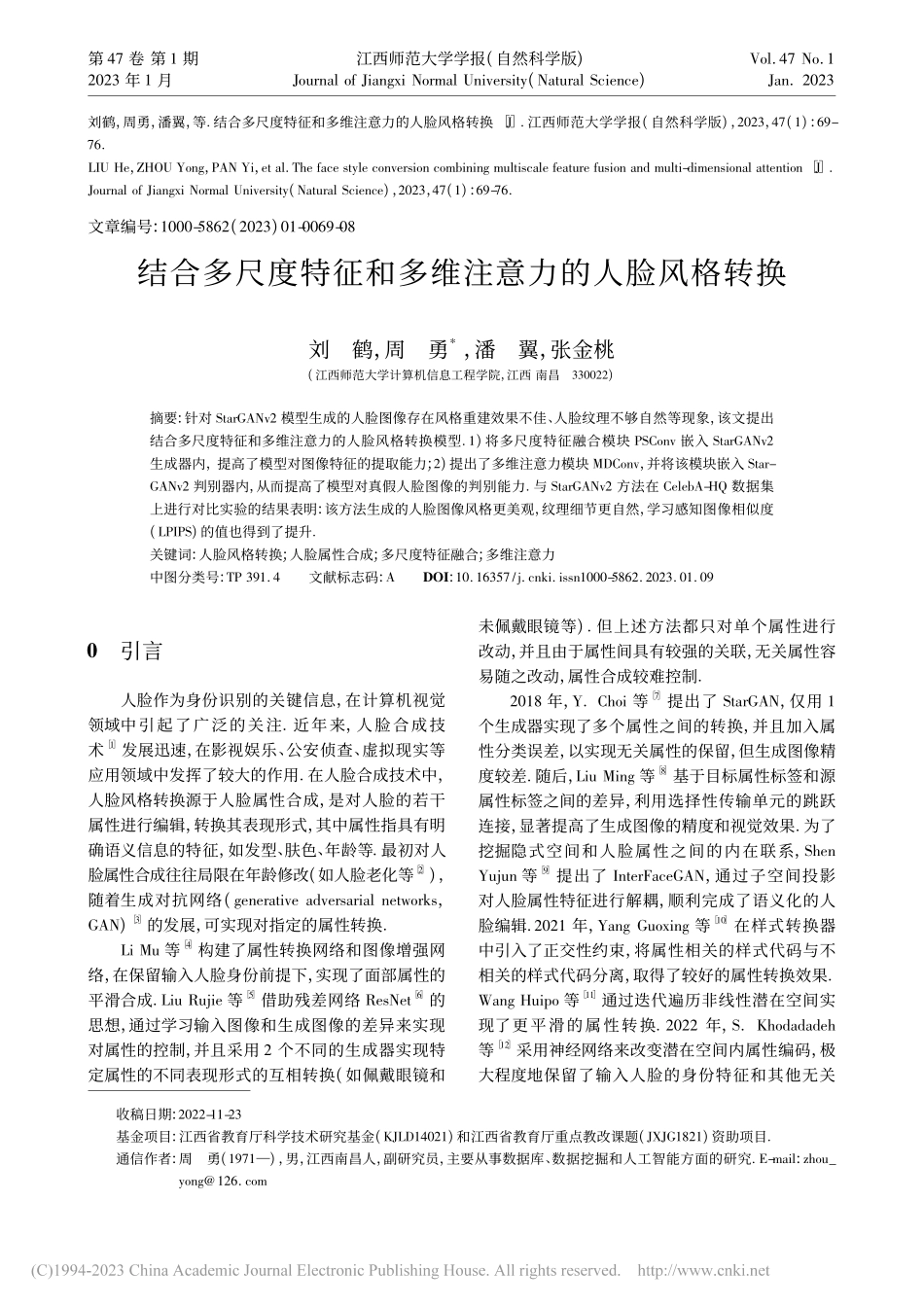

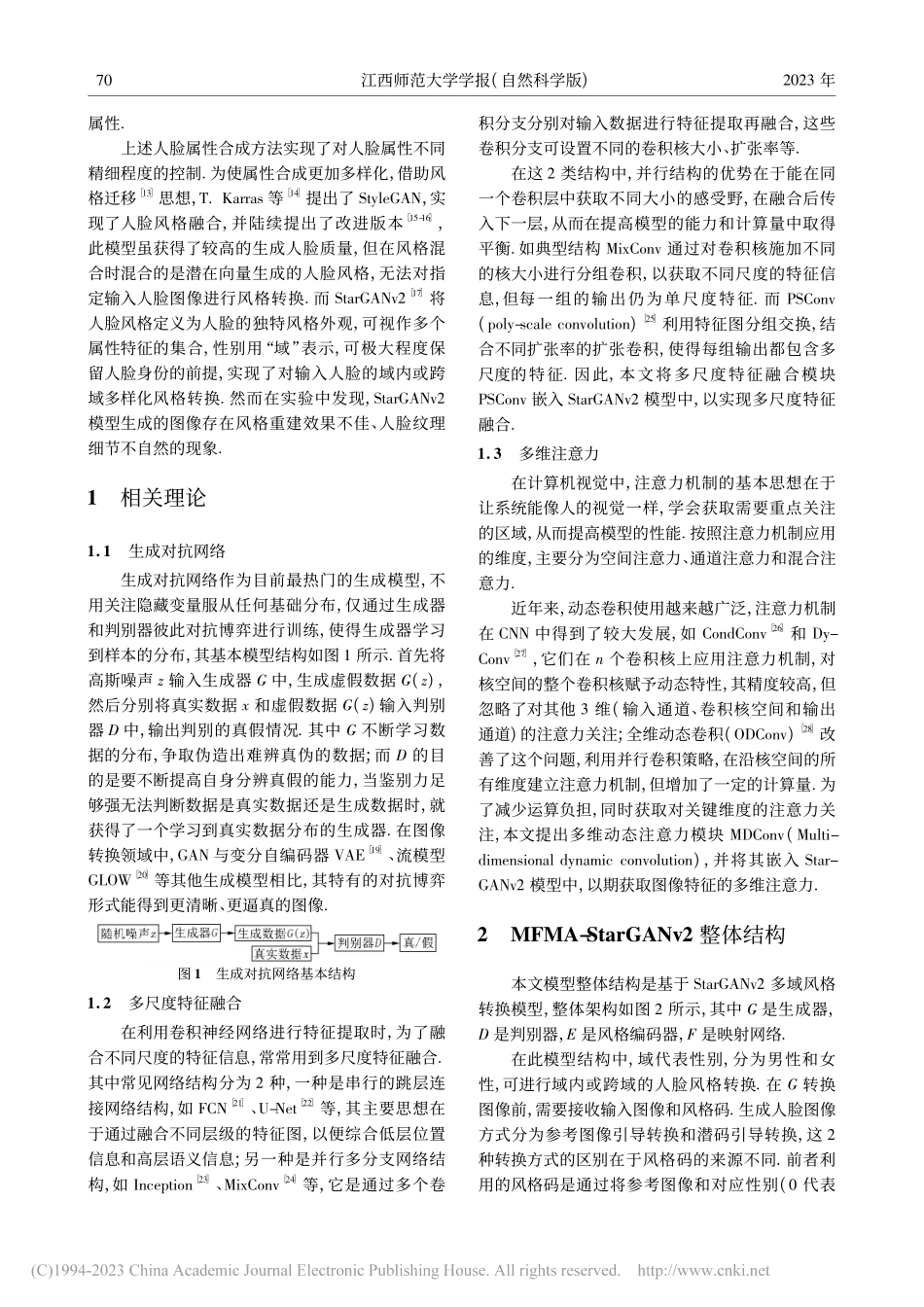

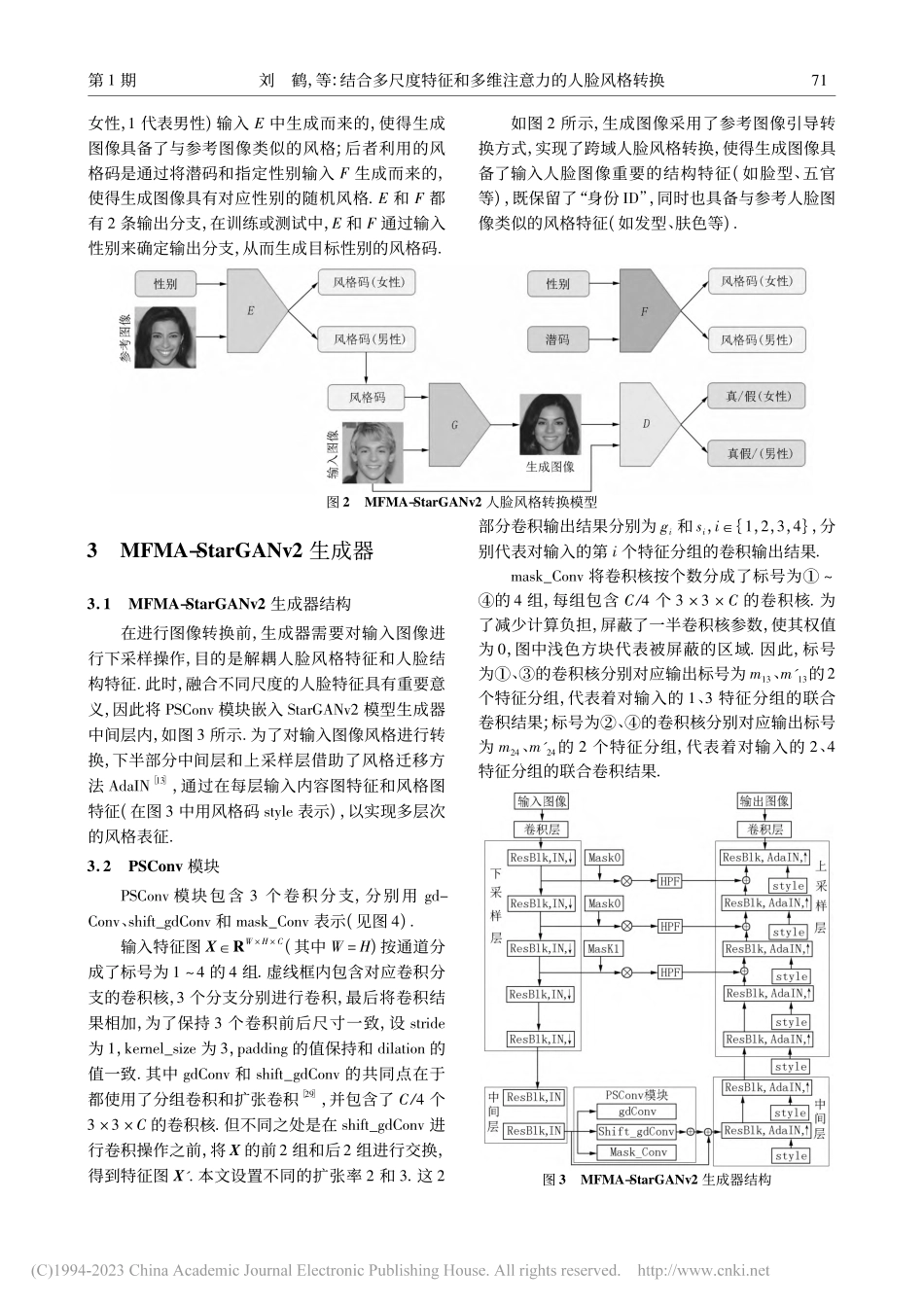

收稿日期:2022-11-23基金项目:江西省教育厅科学技术研究基金(KJLD14021)和江西省教育厅重点教改课题(JXJG1821)资助项目.通信作者:周勇(1971—),男,江西南昌人,副研究员,主要从事数据库、数据挖掘和人工智能方面的研究.E-mail:zhou_yong@126.com刘鹤,周勇,潘翼,等.结合多尺度特征和多维注意力的人脸风格转换[J].江西师范大学学报(自然科学版),2023,47(1):69-76.LIUHe,ZHOUYong,PANYi,etal.Thefacestyleconversioncombiningmultiscalefeaturefusionandmulti-dimensionalattention[J].JournalofJiangxiNormalUniversity(NaturalScience),2023,47(1):69-76.文章编号:1000-5862(2023)01-0069-08结合多尺度特征和多维注意力的人脸风格转换刘鹤,周勇*,潘翼,张金桃(江西师范大学计算机信息工程学院,江西南昌330022)摘要:针对StarGANv2模型生成的人脸图像存在风格重建效果不佳、人脸纹理不够自然等现象,该文提出结合多尺度特征和多维注意力的人脸风格转换模型.1)将多尺度特征融合模块PSConv嵌入StarGANv2生成器内,提高了模型对图像特征的提取能力;2)提出了多维注意力模块MDConv,并将该模块嵌入Star-GANv2判别器内,从而提高了模型对真假人脸图像的判别能力.与StarGANv2方法在CelebA-HQ数据集上进行对比实验的结果表明:该方法生成的人脸图像风格更美观,纹理细节更自然,学习感知图像相似度(LPIPS)的值也得到了提升.关键词:人脸风格转换;人脸属性合成;多尺度特征融合;多维注意力中图分类号:TP391.4文献标志码:ADOI:10.16357/j.cnki.issn1000-5862.2023.01.090引言人脸作为身份识别的关键信息,在计算机视觉领域中引起了广泛的关注.近年来,人脸合成技术[1]发展迅速,在影视娱乐、公安侦查、虚拟现实等应用领域中发挥了较大的作用.在人脸合成技术中,人脸风格转换源于人脸属性合成,是对人脸的若干属性进行编辑,转换其表现形式,其中属性指具有明确语义信息的特征,如发型、肤色、年龄等.最初对人脸属性合成往往局限在年龄修改(如人脸老化等[2]),随着生成对抗网络(generativeadversarialnetworks,GAN)[3]的发展,可实现对指定的属性转换.LiMu等[4]构建了属性转换网络和图像增强网络,在保留输入人脸身份前提下,实现了面部属性的平滑合成.LiuRujie等[5]借助残差网络ResNet[6]的思想,通过学习输入图像和生成图像的差异来实现对属性的控制,并且采用2个不同的生成器实现特定属性的不同表现...