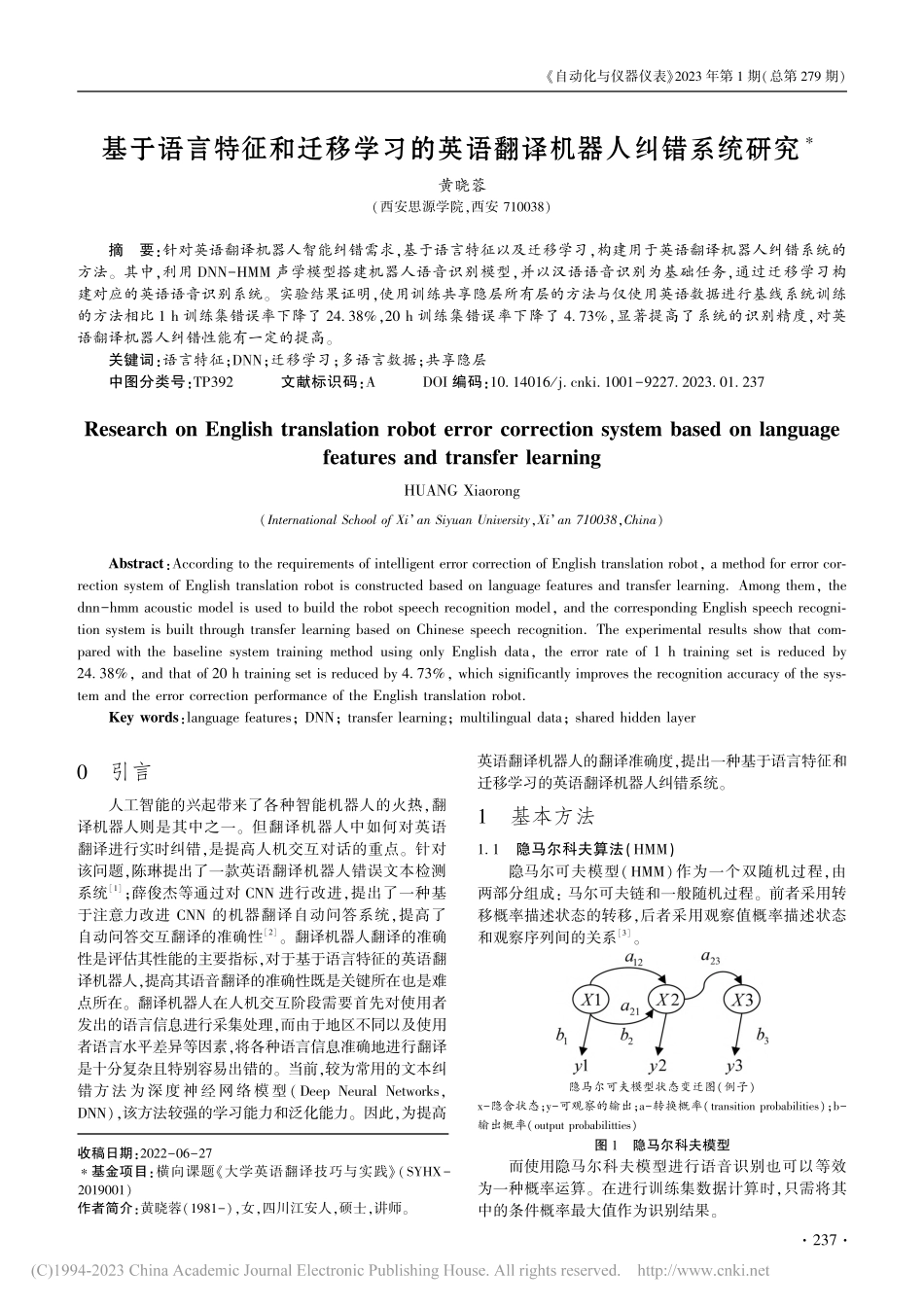

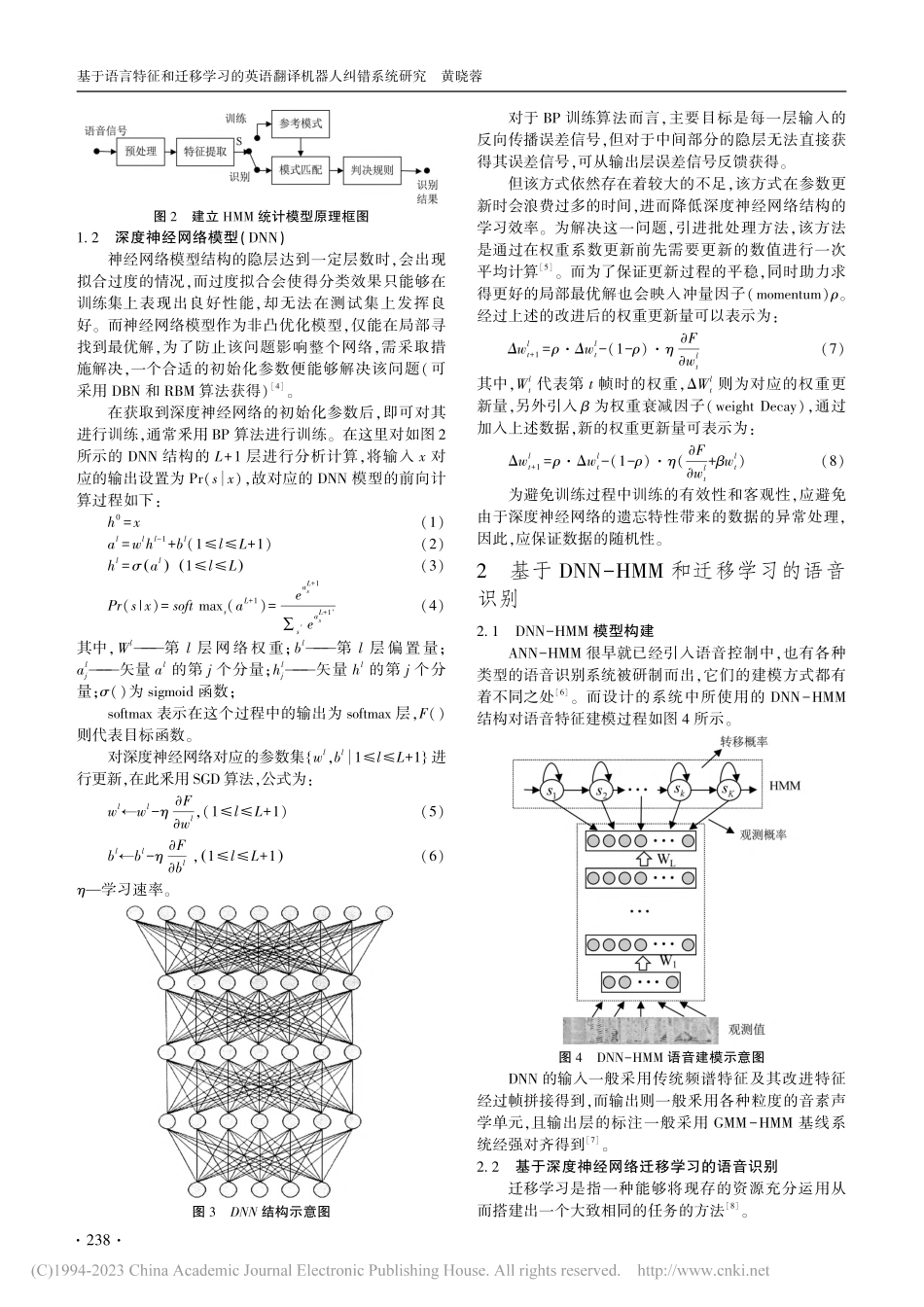

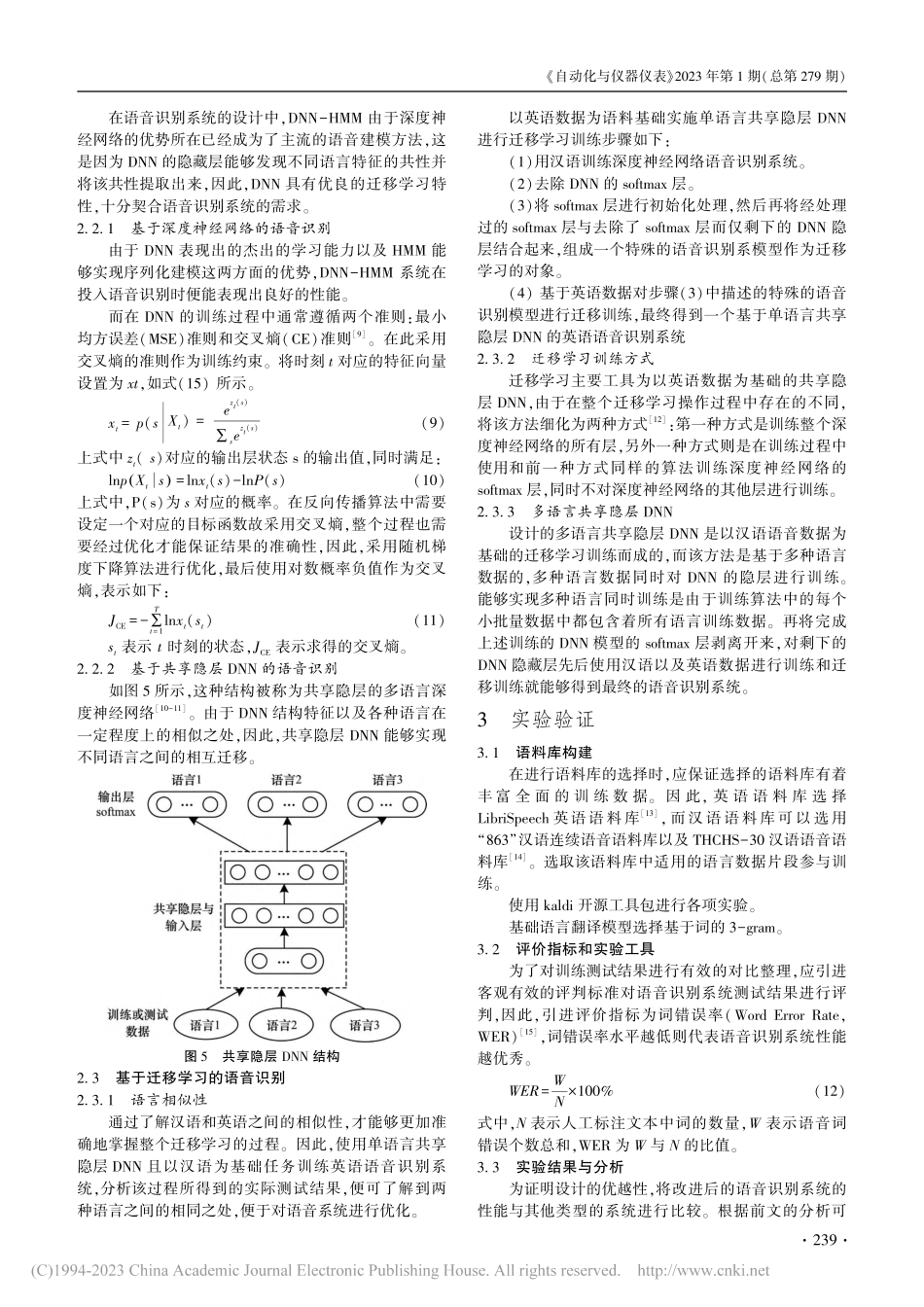

收稿日期:2022-06-27∗基金项目:横向课题《大学英语翻译技巧与实践》(SYHX-2019001)作者简介:黄晓蓉(1981-),女,四川江安人,硕士,讲师。基于语言特征和迁移学习的英语翻译机器人纠错系统研究∗黄晓蓉(西安思源学院,西安710038)摘要:针对英语翻译机器人智能纠错需求,基于语言特征以及迁移学习,构建用于英语翻译机器人纠错系统的方法。其中,利用DNN-HMM声学模型搭建机器人语音识别模型,并以汉语语音识别为基础任务,通过迁移学习构建对应的英语语音识别系统。实验结果证明,使用训练共享隐层所有层的方法与仅使用英语数据进行基线系统训练的方法相比1h训练集错误率下降了24.38%,20h训练集错误率下降了4.73%,显著提高了系统的识别精度,对英语翻译机器人纠错性能有一定的提高。关键词:语言特征;DNN;迁移学习;多语言数据;共享隐层中图分类号:TP392文献标识码:ADOI编码:10.14016/j.cnki.1001-9227.2023.01.237ResearchonEnglishtranslationroboterrorcorrectionsystembasedonlanguagefeaturesandtransferlearningHUANGXiaorong(InternationalSchoolofXi’anSiyuanUniversity,Xi’an710038,China)Abstract:AccordingtotherequirementsofintelligenterrorcorrectionofEnglishtranslationrobot,amethodforerrorcor-rectionsystemofEnglishtranslationrobotisconstructedbasedonlanguagefeaturesandtransferlearning.Amongthem,thednn-hmmacousticmodelisusedtobuildtherobotspeechrecognitionmodel,andthecorrespondingEnglishspeechrecogni-tionsystemisbuiltthroughtransferlearningbasedonChinesespeechrecognition.Theexperimentalresultsshowthatcom-paredwiththebaselinesystemtrainingmethodusingonlyEnglishdata,theerrorrateof1htrainingsetisreducedby24.38%,andthatof20htrainingsetisreducedby4.73%,whichsignificantlyimprovestherecognitionaccuracyofthesys-temandtheerrorcorrectionperformanceoftheEnglishtranslationrobot.Keywords:languagefeatures;DNN;transferlearning;multilingualdata;sharedhiddenlayer0引言人工智能的兴起带来了各种智能机器人的火热,翻译机器人则是其中之一。但翻译机器人中如何对英语翻译进行实时纠错,是提高人机交互对话的重点。针对该问题,陈琳提出了一款英语翻译机器人错误文本检测系统[1];薛俊杰等通过对CNN进行改进,提出了一种基于注意力改进CNN的机器翻译自动问答系统,提高了自动问答交互翻译的准确性[2]。...