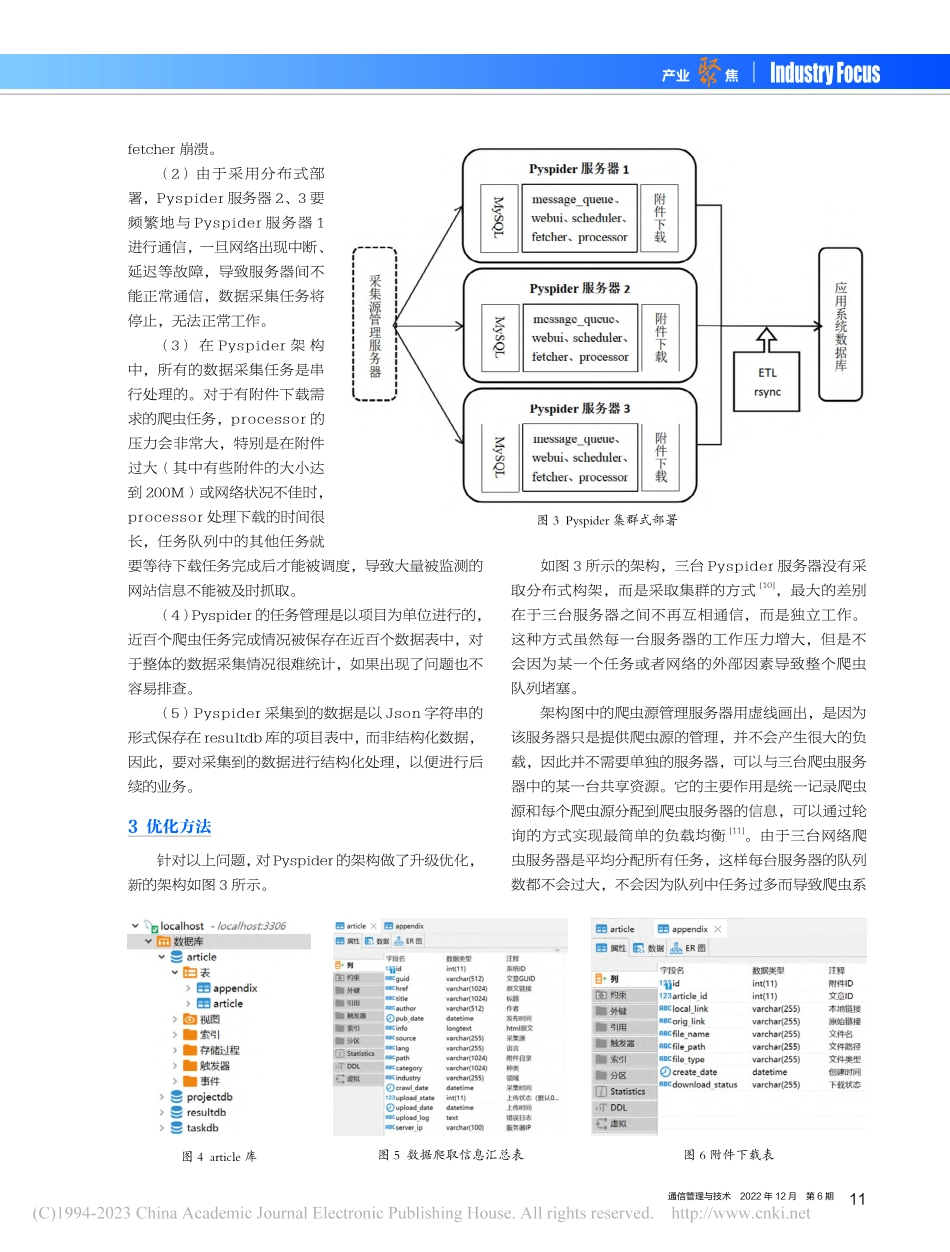

通信管理与技术2022年12月第6期9产业聚焦IndustryFocus1引言截至2021年12月,中国网民人数达到10.32亿[1],互联网已经成为信息传播的重要途径,但海量的数据也给互联网信息的监控带来很大的困难,传统的对重点网站逐一查看的方式已经不能满足需求,取而代之的是先通过网络爬虫将这些网站的内容爬取到系统平台,然后再进行集中管理和使用。1.1网络爬虫网络爬虫是互联网时代和大数据时代的共同产物[2],是通过程序脚本,按照一定的规则,自动将网站页面的信息获取到指定的服务器上,用来进行集中阅读和分析使用。因其工作机制很像蜘蛛爬网,因此也叫网络蜘蛛[3]。网络爬虫的主要工作包括三部分:页面的获取、页面的解析和数据的保存[4]。在有些爬虫框架(如Pyspider)中,提供了数据处理接口(processor),可以在爬取到数据的同时加入其他定制功能,例如下载附件和图片、数据清洗等,提高了网络爬虫的灵活性和适用性。1.2PyspiderPyspider是一个用Python语言编写的分布式网络爬虫框架,拥有强大的WebUI和在线调试功能。与其它爬虫框架相比,Pyspider不仅支持MySQL、MongoDB、SQLite等多种数据库,而且在任务监视、项目管理和结果查询等方面拥有完善的工具。Pyspider是一个开源的爬虫框架,可利用Python构建爬虫脚本,实现对目标数据的抓取,在GitHub上收获了15.5K的星标,是目前最为流行的爬虫框架之一。Pyspider的架构和任务流程如图1所示[5]。Pyspider包括四个组成部分。(1)WebUI:这是Pyspider的特色功能之一,可以在线调试爬虫,监督任务,管理项目,查看任务完成情况。基于Pyspider的网络爬虫架构的分析与优化●李鲲程1费军旗1范春梅2/文1.中国信息通信研究院2.北京邮电大学摘要:为了从互联网海量数据中获取数据资源,实现对前沿技术动态的监控,使用Pyspider框架定时爬取大批网站的信息,并通过python脚本定时将爬取的数据导入到业务系统中。最初,系统采用了Pyspider官方推荐的分布式架构,在使用中发现存在任务队列容易堵塞、受网络质量影响大、获得的数据不利于统计和使用等问题。针对上述问题和业务需要,对Pyspider框架进行优化,将分布式架构转变为集群式架构;剥离与网页内容获取和保存不相关的任务,在Pyspider框架外独立完成。经测试,改进后的架构工作效率和稳定性大幅提升,达到了预期的效果。关键词:Pyspider;网络爬虫;分布式;集群中图分类号:TP29文献标识码:B文章编号:1672-6200(2022)06-0009-04图1Pyspider架构和任...