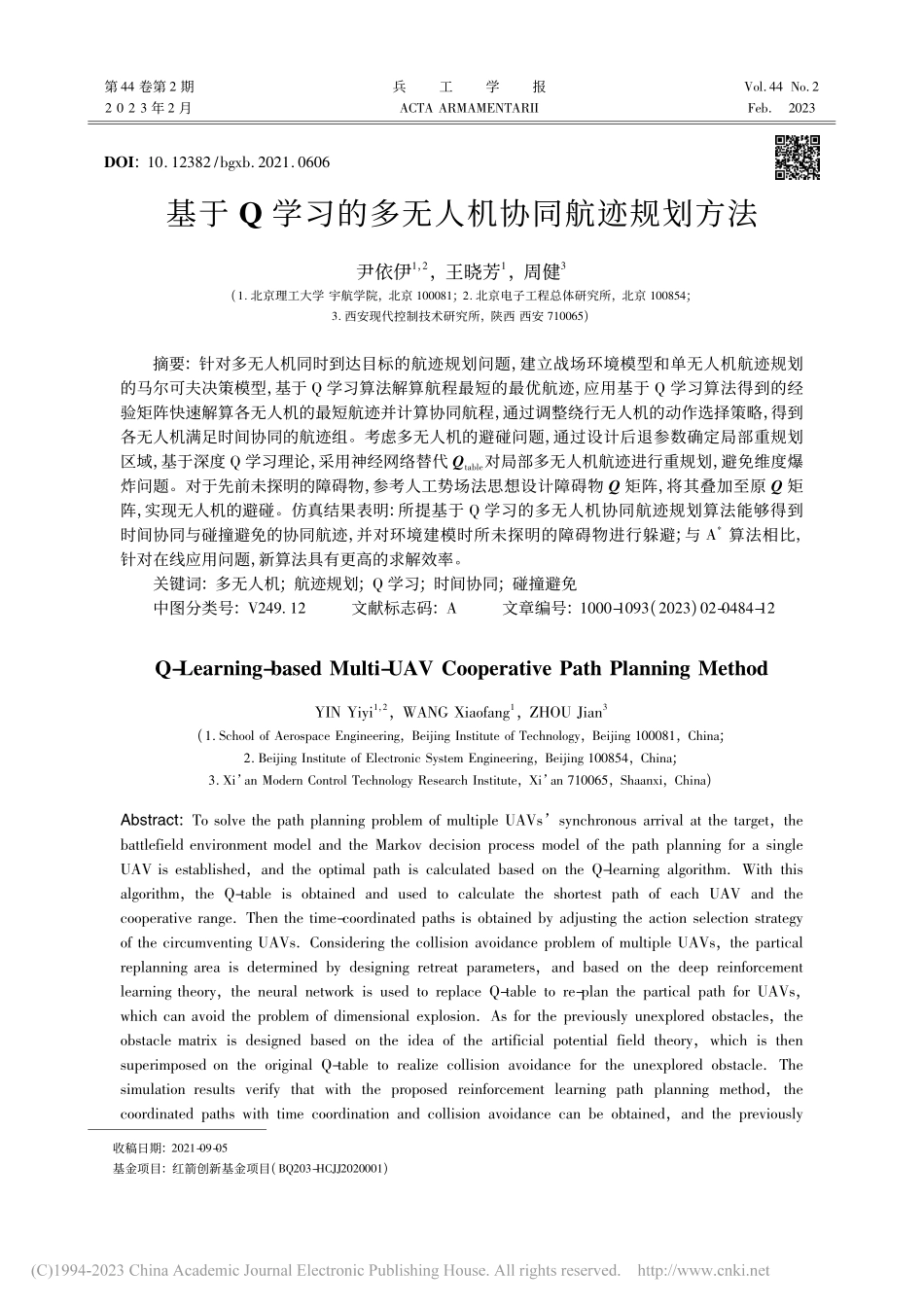

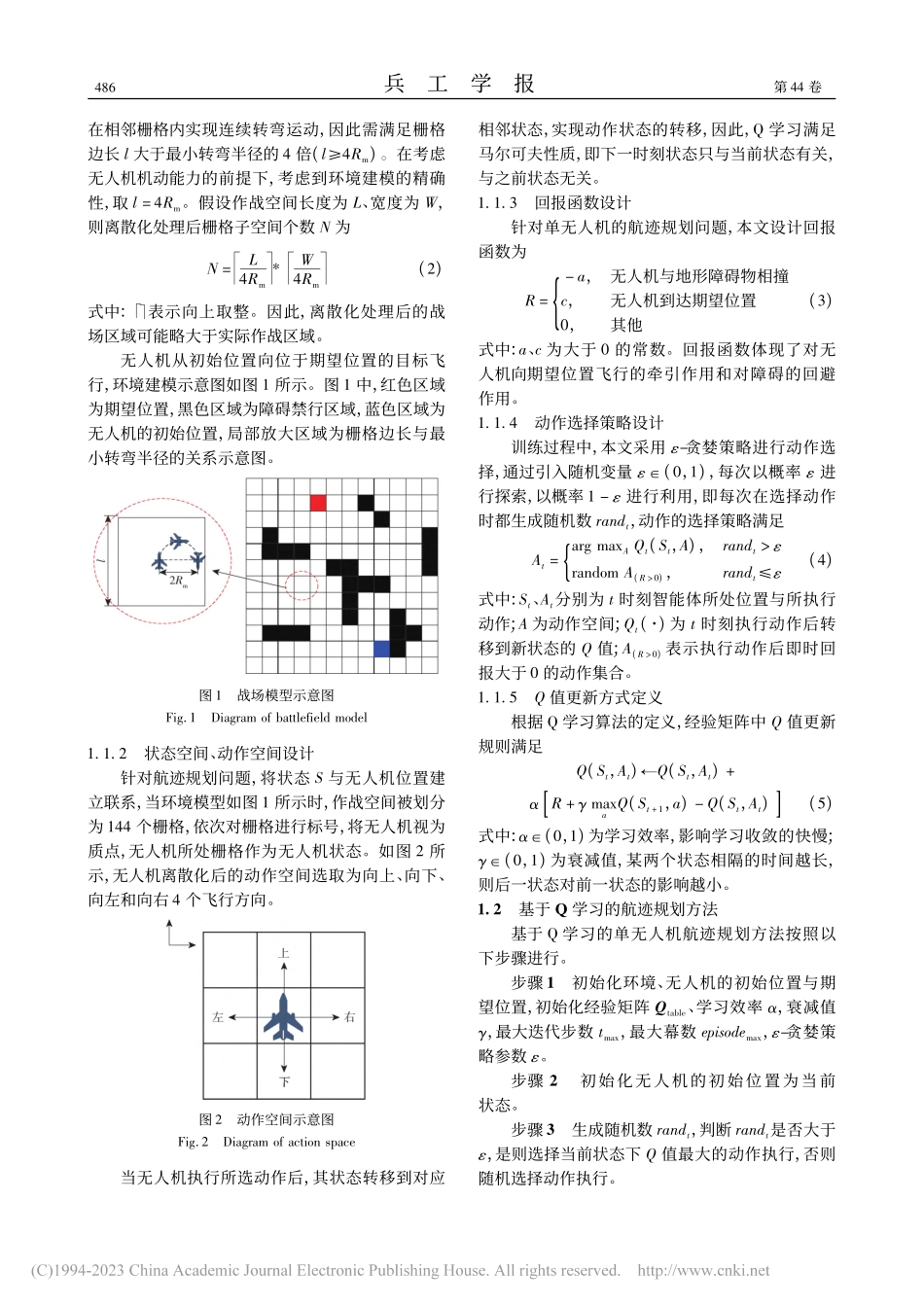

第44卷第2期2023年2月兵工学报ACTAARMAMENTARIIVol.44No.2Feb.2023DOI:10.12382/bgxb.2021.0606基于Q学习的多无人机协同航迹规划方法尹依伊1,2,王晓芳1,周健3(1.北京理工大学宇航学院,北京100081;2.北京电子工程总体研究所,北京100854;3.西安现代控制技术研究所,陕西西安710065)摘要:针对多无人机同时到达目标的航迹规划问题,建立战场环境模型和单无人机航迹规划的马尔可夫决策模型,基于Q学习算法解算航程最短的最优航迹,应用基于Q学习算法得到的经验矩阵快速解算各无人机的最短航迹并计算协同航程,通过调整绕行无人机的动作选择策略,得到各无人机满足时间协同的航迹组。考虑多无人机的避碰问题,通过设计后退参数确定局部重规划区域,基于深度Q学习理论,采用神经网络替代Qtable对局部多无人机航迹进行重规划,避免维度爆炸问题。对于先前未探明的障碍物,参考人工势场法思想设计障碍物Q矩阵,将其叠加至原Q矩阵,实现无人机的避碰。仿真结果表明:所提基于Q学习的多无人机协同航迹规划算法能够得到时间协同与碰撞避免的协同航迹,并对环境建模时所未探明的障碍物进行躲避;与A*算法相比,针对在线应用问题,新算法具有更高的求解效率。关键词:多无人机;航迹规划;Q学习;时间协同;碰撞避免中图分类号:V249.12文献标志码:A文章编号:1000-1093(2023)02-0484-12收稿日期:2021-09-05基金项目:红箭创新基金项目(BQ203-HCJJ2020001)Q-Learning-basedMulti-UAVCooperativePathPlanningMethodYINYiyi1,2,WANGXiaofang1,ZHOUJian3(1.SchoolofAerospaceEngineering,BeijingInstituteofTechnology,Beijing100081,China;2.BeijingInstituteofElectronicSystemEngineering,Beijing100854,China;3.Xi’anModernControlTechnologyResearchInstitute,Xi’an710065,Shaanxi,China)Abstract:TosolvethepathplanningproblemofmultipleUAVs’synchronousarrivalatthetarget,thebattlefieldenvironmentmodelandtheMarkovdecisionprocessmodelofthepathplanningforasingleUAVisestablished,andtheoptimalpathiscalculatedbasedontheQ-learningalgorithm.Withthisalgorithm,theQ-tableisobtainedandusedtocalculatetheshortestpathofeachUAVandthecooperativerange.Thenthetime-coordinatedpathsisobtainedbyadjustingtheactionselectionstrategyofthecircumventingUAVs.ConsideringthecollisionavoidanceproblemofmultipleUAVs...