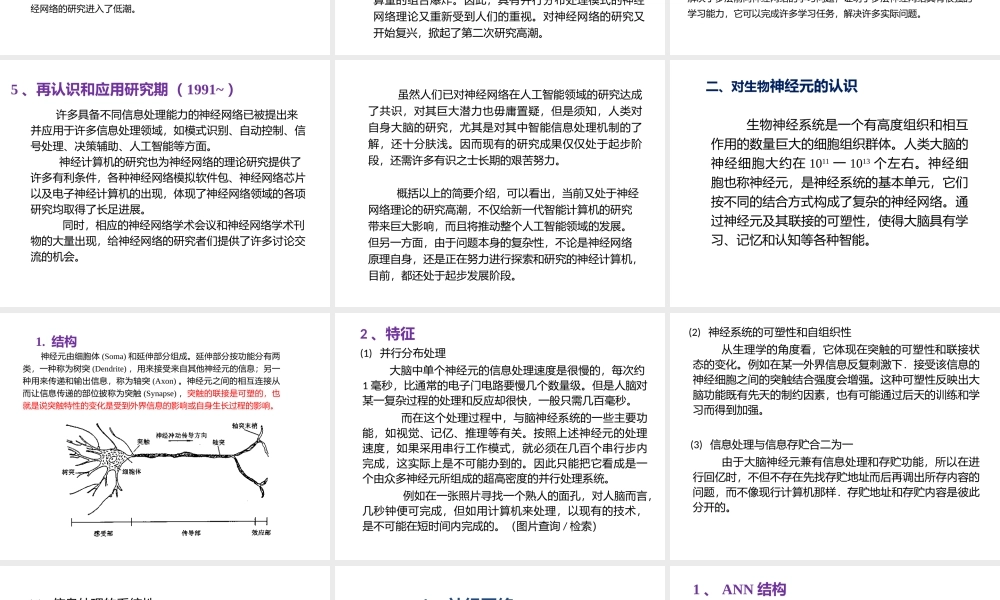

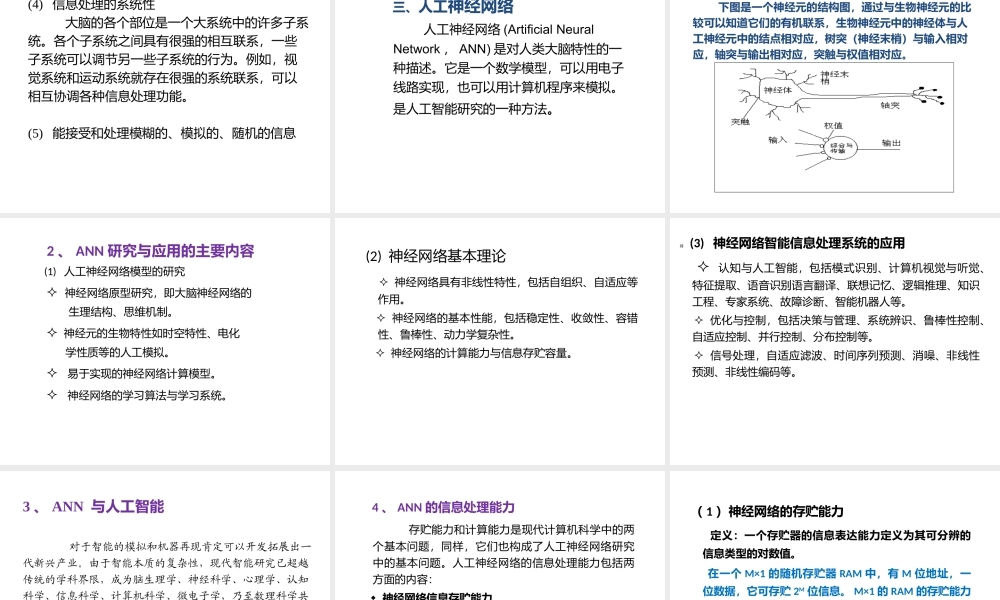

神经网络与多传感器数据融合第6讲知识基础1、激励函数(阶跃函数、非线性函数、连续函数、单调函数)、函数收敛2、偏微分、梯度、方差与均方差3、向量与矩阵4、最优解与解空间5、Matlab使用6、人工智能基础1、萌芽期40年代初,美国McCulloch和Pitts从信息处理的角度,研究神经细胞行为的数学模型表达.提出了阈值加权和模型—MP模型。1949年,心理学家Hebb提出著名的Hebb学习规则,即由神经元之间结合强度的改变来实现神经学习的方法。Hebb学习规的基本思想至今在神经网络的研究中仍发挥着重要作用。一、人工神经网络的研究与发展50年代末期,Rosenblatt提出感知机模型(Perceptron)。感知机虽然比较简单,却已具有神经网络的一些基本性质,如分布式存贮、并行处理、可学习性、连续计算等。这些神经网络的特性与当时流行串行的、离散的、符号处理的电子计算机及其相应的人工智能技术有本质上的不同,由此引起许多研究者的兴趣。在60代掀起了神经网络研究的第一次高潮。但是,当时人们对神经网络研究过于乐观,认为只要将这种神经元互连成一个网络,就可以解决人脑思维的模拟问题,然而,后来的研究结果却又使人们走到另一个极端上。2、第一次高潮60年代末,美国著名人工智能专家Minsky和Papert对Rosenblatt的工作进行了深人研究,出版了有较大影响的《Perceptron》一书,指出感知机的功能和处理能力的局限性,同时也指出如果在感知器中引入隐含神经元,增加神经网络的层次,可以提高神经网络的处理能力,但是却无法给出相应的网络学习算法。另一方面,以为串行信息处理及以它为基础的传统人工智能技术的潜力是无穷的,这就暂时掩盖了发展新型计算机和寻找新的人工智能途径的必要性和迫切性。再者,当时对大脑的计算原理、对神经网络计算的优点、缺点、可能性及其局限性等还很不清楚,使对神经网络的研究进入了低潮。3、反思期进入80年代,首先是基于“知识库”的专家系统的研究和运用,在许多方面取得了较大成功。但在一段时间以后,实际情况表明专家系统并不像人们所希望的那样高明,特别是在处理视觉、听觉、形象思维、联想记忆以及运动控制等方面,传统的计算机和人工智能技术面临着重重困难。模拟人脑的智能信息处理过程,如果仅靠串行逻辑和符号处理等传统的方法来济决复杂的问题,会产生计算量的组合爆炸。因此,具有并行分布处理模式的神经网络理论又重新受到人们的重视。对神经网络的研究又开始复兴,掀起了第二次研究高潮。4、第二次高潮19...