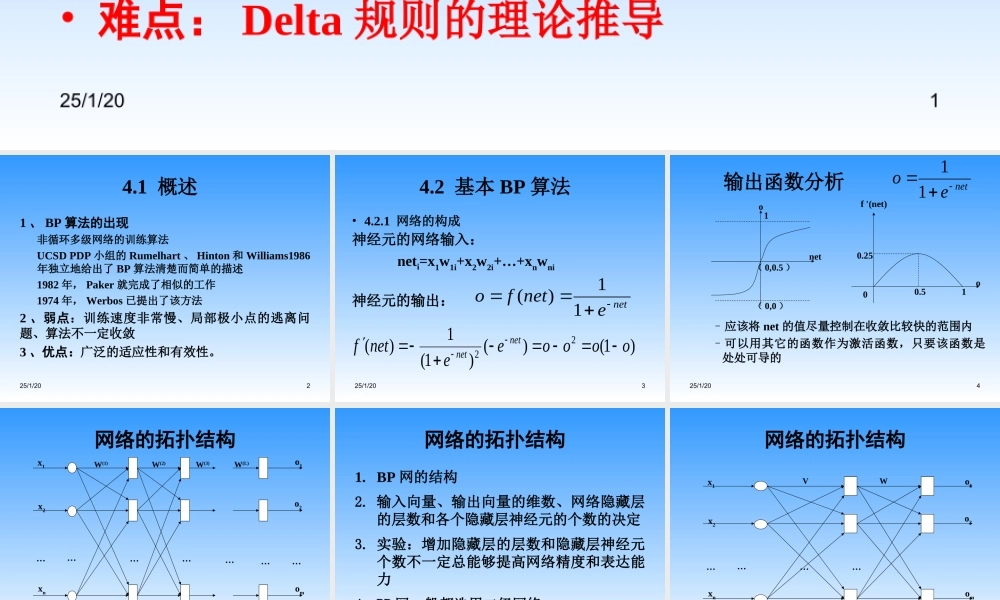

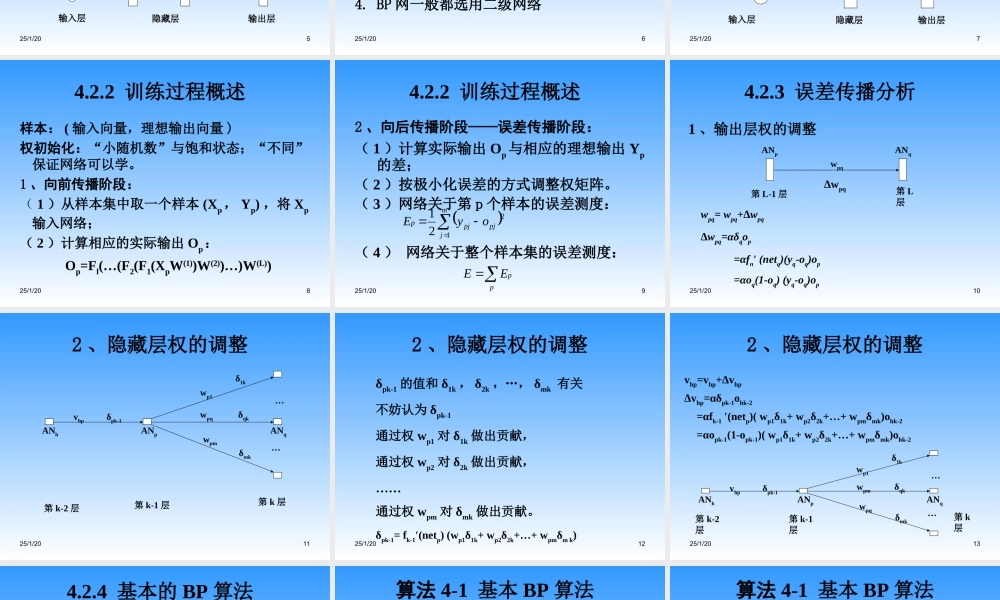

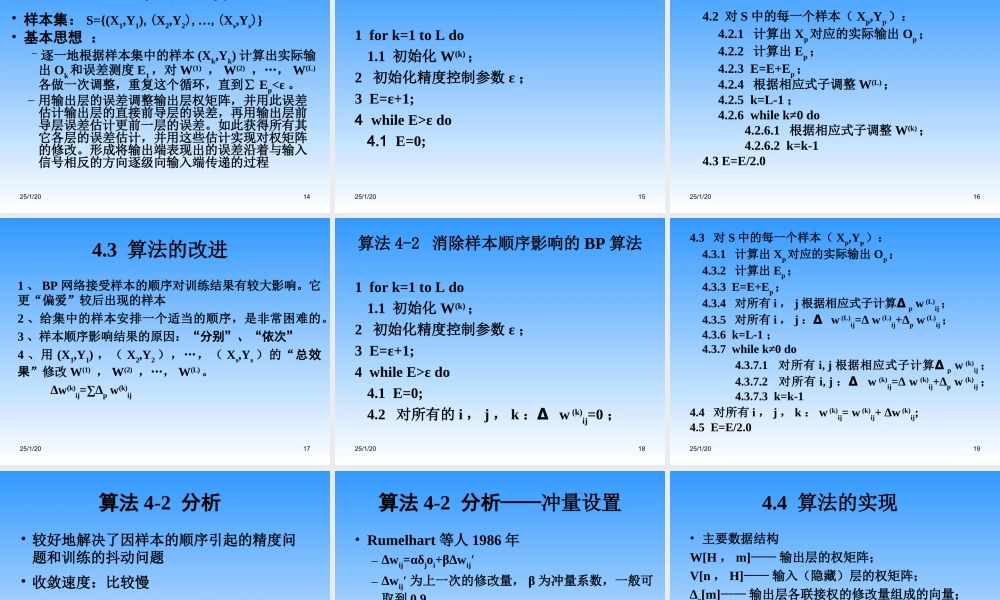

25/1/201第4章BP网络•主要内容:–BP网络的构成–隐藏层权的调整分析–Delta规则理论推导–算法的收敛速度及其改进讨论–BP网络中的几个重要问题•重点:BP算法•难点:Delta规则的理论推导25/1/2024.1概述1、BP算法的出现非循环多级网络的训练算法UCSDPDP小组的Rumelhart、Hinton和Williams1986年独立地给出了BP算法清楚而简单的描述1982年,Paker就完成了相似的工作1974年,Werbos已提出了该方法2、弱点:训练速度非常慢、局部极小点的逃离问题、算法不一定收敛3、优点:广泛的适应性和有效性。25/1/2034.2基本BP算法•4.2.1网络的构成神经元的网络输入:neti=x1w1i+x2w2i+…+xnwni神经元的输出:netenetfo11)()1()()1(1)(22ooooeenetfnetnet25/1/204输出函数分析0.5f′(net)0.25o011(0,0.5)net(0,0)oneteo11–应该将net的值尽量控制在收敛比较快的范围内–可以用其它的函数作为激活函数,只要该函数是处处可导的25/1/205网络的拓扑结构x1o1输出层隐藏层输入层x2o2omxn…………………W(1)W(2)W(3)W(L)25/1/206网络的拓扑结构1.BP网的结构2.输入向量、输出向量的维数、网络隐藏层的层数和各个隐藏层神经元的个数的决定3.实验:增加隐藏层的层数和隐藏层神经元个数不一定总能够提高网络精度和表达能力4.BP网一般都选用二级网络25/1/207网络的拓扑结构x1o1输出层隐藏层输入层x2o2omxn…………WV25/1/2084.2.2训练过程概述样本:(输入向量,理想输出向量)权初始化:“小随机数”与饱和状态;“不同”保证网络可以学。1、向前传播阶段:(1)从样本集中取一个样本(Xp,Yp),将Xp输入网络;(2)计算相应的实际输出Op:Op=Fl(…(F2(F1(XpW(1))W(2))…)W(L))25/1/2094.2.2训练过程概述2、向后传播阶段——误差传播阶段:(1)计算实际输出Op与相应的理想输出Yp的差;(2)按极小化误差的方式调整权矩阵。(3)网络关于第p个样本的误差测度:mjpjpjpoyE1221(4)网络关于整个样本集的误差测度:ppEE25/1/20104.2.3误差传播分析1、输出层权的调整wpq=wpq+∆wpq∆wpq=αδqop=αfn′(netq)(yq-oq)op=αoq(1-oq)(yq-oq)opwpqANpANq第L-1层第L层∆wpq25/1/20112、隐藏层权的调整ANpANqANhvhpδpk-1δ1kwp1wpqδqkwpmδmk第k-2层第k层第k-1层……25/1/20122、隐藏层权的调整δpk-1的值和δ1k,δ2k,…,δmk有关不妨认为δpk-1通过权wp1对δ1k做出贡献,通过权wp2对δ2k做出贡献,……通过权wpm对...